As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Como moderar um conteúdo

Você pode usar o Amazon Rekognition para detectar conteúdo impróprio, indesejado ou ofensivo. Você pode usar a APIs moderação do Rekognition em situações de mídia social, mídia de transmissão, publicidade e comércio eletrônico para criar uma experiência de usuário mais segura, fornecer garantias de segurança da marca aos anunciantes e cumprir as regulamentações locais e globais.

Atualmente, muitas empresas dependem inteiramente de moderadores humanos para revisar conteúdo de terceiros ou gerado por usuários, enquanto outras simplesmente reagem às reclamações dos usuários para remover imagens, anúncios ou vídeos ofensivos ou inapropriados. No entanto, os moderadores humanos sozinhos não conseguem escalonar para atender a essas necessidades com qualidade ou velocidade suficientes, o que gera uma experiência ruim para o usuário, altos custos para alcançar essa escala ou até mesmo uma perda de reputação da marca. Ao usar o Rekognition para moderação de imagens e vídeos, os moderadores humanos podem revisar um conjunto muito menor de conteúdo, normalmente de 1 a 5% do volume total, já sinalizado pelo machine learning. Isso permite concentrar os esforços em atividades mais valiosas e ainda abordar a moderação de forma completa por uma fração do custo atual. Para configurar a força de trabalho humana e realizar tarefas de revisão humana, você pode usar o Amazon Augmented AI, que já está integrado ao Rekognition.

Você pode aprimorar a precisão do modelo de aprendizado profundo de moderação com o recurso de moderação personalizada. Com a moderação personalizada, você treina um adaptador de moderação personalizado enviando suas imagens e fazendo anotações nessas imagens. O adaptador treinado pode então ser fornecido à DetectModerationLabelsoperação para melhorar seu desempenho em suas imagens. Consulte Aprimorando a precisão com moderação personalizada para obter mais informações.

Rótulos aceitos pelas operações de moderação de conteúdo do Rekognition

-

Para baixar uma lista dos rótulos de moderação, clique aqui.

Tópicos

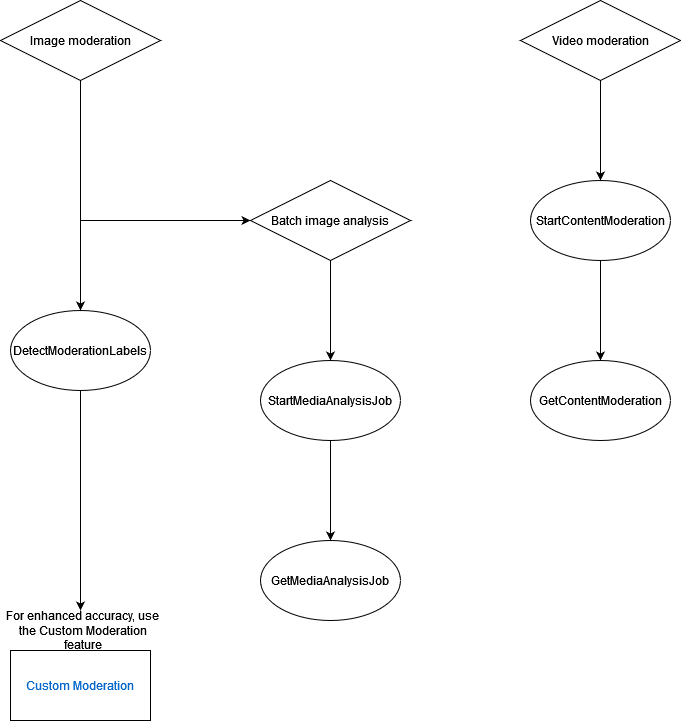

O diagrama a seguir mostra a ordem das operações de chamada, dependendo de suas metas de uso dos componentes de imagem ou vídeo da moderação de conteúdo: