Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Pemecahan masalah: DAGs, Operator, Koneksi, dan masalah lain di Apache Airflow v1

Topik di halaman ini berisi resolusi untuk Apache Airflow v1.10.12 dependensi Python, plugin DAGs khusus,, Operator, Koneksi, tugas, dan masalah server Web yang mungkin Anda temui di lingkungan Alur Kerja Terkelola Amazon untuk Apache Airflow.

Daftar Isi

Saya menerima kesalahan 'Broken DAG' saat menggunakan operator Amazon DynamoDB

Saya menerima kesalahan 'Broken DAG: No module named psycopg2'

Saya menerima kesalahan 'Broken DAG' saat menggunakan operator Slack

Saya menerima berbagai kesalahan saat menginstal Google/GCP/BigQuery

Saya menerima kesalahan 'Broken DAG: No module named Cython'

Memperbarui requirements.txt

Topik berikut menjelaskan kesalahan yang mungkin Anda terima saat memperbaruirequirements.txt.

Menambahkan apache-airflow-providers-amazon menyebabkan lingkungan saya gagal

apache-airflow-providers-hanya kompatibel dengan Apache Airflow v2. xyzapache-airflow-backport-providers-kompatibel dengan Apache Airflow 1.10.12.xyz

DAG rusak

Topik berikut menjelaskan kesalahan yang mungkin Anda terima saat menjalankan DAGs.

Saya menerima kesalahan 'Broken DAG' saat menggunakan operator Amazon DynamoDB

Kami merekomendasikan langkah-langkah berikut:

-

Uji DAGs, plugin kustom, dan dependensi Python Anda secara lokal menggunakan on. aws-mwaa-local-runner

GitHub -

Tambahkan paket berikut ke paket Anda

requirements.txt.boto -

Jelajahi cara untuk menentukan dependensi Python dalam

requirements.txtfile, lihat. Mengelola dependensi Python di requirements.txt

Saya menerima kesalahan 'Broken DAG: No module named psycopg2'

Kami merekomendasikan langkah-langkah berikut:

-

Uji DAGs, plugin kustom, dan dependensi Python Anda secara lokal menggunakan on. aws-mwaa-local-runner

GitHub -

Tambahkan yang berikut ini ke

requirements.txtversi Apache Airflow Anda. Misalnya:apache-airflow[postgres]==1.10.12 -

Jelajahi cara untuk menentukan dependensi Python dalam

requirements.txtfile, lihat. Mengelola dependensi Python di requirements.txt

Saya menerima kesalahan 'Broken DAG' saat menggunakan operator Slack

Kami merekomendasikan langkah-langkah berikut:

-

Uji DAGs, plugin kustom, dan dependensi Python Anda secara lokal menggunakan on. aws-mwaa-local-runner

GitHub -

Tambahkan paket berikut ke Anda

requirements.txtdan tentukan versi Apache Airflow Anda. Misalnya:apache-airflow[slack]==1.10.12 -

Jelajahi cara untuk menentukan dependensi Python dalam

requirements.txtfile, lihat. Mengelola dependensi Python di requirements.txt

Saya menerima berbagai kesalahan saat menginstal Google/GCP/BigQuery

Amazon MWAA menggunakan Amazon Linux yang memerlukan versi tertentu dari pustaka Cython dan kriptografi. Kami merekomendasikan langkah-langkah berikut:

-

Uji DAGs, plugin kustom, dan dependensi Python Anda secara lokal menggunakan on. aws-mwaa-local-runner

GitHub -

Tambahkan paket berikut ke paket Anda

requirements.txt.grpcio==1.27.2 cython==0.29.21 pandas-gbq==0.13.3 cryptography==3.3.2 apache-airflow-backport-providers-amazon[google] -

Jika Anda tidak menggunakan penyedia backport, Anda dapat menggunakan:

grpcio==1.27.2 cython==0.29.21 pandas-gbq==0.13.3 cryptography==3.3.2 apache-airflow[gcp]==1.10.12 -

Jelajahi cara untuk menentukan dependensi Python dalam

requirements.txtfile, lihat. Mengelola dependensi Python di requirements.txt

Saya menerima kesalahan 'Broken DAG: No module named Cython'

Amazon MWAA menggunakan Amazon Linux yang membutuhkan versi Cython tertentu. Kami merekomendasikan langkah-langkah berikut:

-

Uji DAGs, plugin kustom, dan dependensi Python Anda secara lokal menggunakan on. aws-mwaa-local-runner

GitHub -

Tambahkan paket berikut ke paket Anda

requirements.txt.cython==0.29.21 -

Pustaka Cython memiliki berbagai versi dependensi pip yang diperlukan. Misalnya, menggunakan

awswrangler==2.4.0requirespyarrow<3.1.0,>=2.0.0, jadi pip3 mencoba menginstalpyarrow==3.0.0yang menyebabkan kesalahan Broken DAG. Kami merekomendasikan untuk menentukan eksplisit versi tertua yang dapat diterima. Misalnya, jika Anda menentukan nilai minimumpyarrow==2.0.0sebelumnyaawswrangler==2.4.0maka kesalahan akan hilang, danrequirements.txtpenginstalan dengan benar. Persyaratan akhir akan terlihat seperti ini:cython==0.29.21 pyarrow==2.0.0 awswrangler==2.4.0 -

Jelajahi cara untuk menentukan dependensi Python dalam

requirements.txtfile, lihat. Mengelola dependensi Python di requirements.txt

Operator

Topik berikut menjelaskan kesalahan yang mungkin Anda terima saat menggunakan Operator.

Saya menerima kesalahan menggunakan BigQuery operator

Amazon MWAA tidak mendukung operator dengan ekstensi UI. Kami merekomendasikan langkah-langkah berikut:

-

Uji DAGs, plugin kustom, dan dependensi Python Anda secara lokal menggunakan on. aws-mwaa-local-runner

GitHub -

Solusinya adalah mengganti ekstensi dengan menambahkan baris di DAG untuk disetel

<operator name>.operator_extra_links = Nonesetelah mengimpor operator masalah. Misalnya:from airflow.contrib.operators.bigquery_operator import BigQueryOperator BigQueryOperator.operator_extra_links = None -

Anda dapat menggunakan pendekatan ini untuk semua DAGs dengan menambahkan hal di atas ke plugin. Sebagai contoh, lihatMembuat plugin khusus untuk Apache Airflow PythonVirtualenvOperator.

Koneksi

Topik berikut menjelaskan kesalahan yang mungkin Anda terima saat menggunakan koneksi Apache Airflow, atau menggunakan database lain. AWS

Saya tidak dapat terhubung ke Snowflake

Kami merekomendasikan langkah-langkah berikut:

-

Uji DAGs, plugin kustom, dan dependensi Python Anda secara lokal menggunakan on. aws-mwaa-local-runner

GitHub -

Tambahkan entri berikut ke requirements.txt untuk lingkungan Anda.

asn1crypto == 0.24.0 snowflake-connector-python == 1.7.2 -

Tambahkan impor berikut ke DAG Anda:

from airflow.contrib.hooks.snowflake_hook import SnowflakeHook from airflow.contrib.operators.snowflake_operator import SnowflakeOperator

Pastikan objek koneksi Apache Airflow menyertakan pasangan kunci-nilai berikut:

-

Id Conn: snowflake_conn

-

Jenis Conn: Kepingan Salju

-

Tuan rumah:<my account>. <my region if not us-west-2>.snowflakecomputing.com

-

Skema: <my schema>

-

Masuk: <my user name>

-

Kata sandi: ********

-

Pelabuhan: <port, if any>

-

Ekstra:

{ "account": "<my account>", "warehouse": "<my warehouse>", "database": "<my database>", "region": "<my region if not using us-west-2 otherwise omit this line>" }

Misalnya:

>>> import json >>> from airflow.models.connection import Connection >>> myconn = Connection( ... conn_id='snowflake_conn', ... conn_type='Snowflake', ... host='123456789012.us-east-1.snowflakecomputing.com', ... schema='YOUR_SCHEMA' ... login='YOUR_USERNAME', ... password='YOUR_PASSWORD', ... port='YOUR_PORT' ... extra=json.dumps(dict(account='123456789012', warehouse='YOUR_WAREHOUSE', database='YOUR_DB_OPTION', region='us-east-1')), ... )

Saya tidak dapat terhubung ke Secrets Manager

Kami merekomendasikan langkah-langkah berikut:

-

Pelajari cara membuat kunci rahasia untuk koneksi dan variabel Apache Airflow Anda. Mengkonfigurasi koneksi Apache Airflow menggunakan rahasia AWS Secrets Manager

-

Pelajari cara menggunakan kunci rahasia untuk variabel

test-variableApache Airflow () di. Menggunakan kunci rahasia AWS Secrets Manager untuk variabel Apache Airflow -

Pelajari cara menggunakan kunci rahasia untuk koneksi

myconnApache Airflow () di. Menggunakan kunci rahasia AWS Secrets Manager untuk koneksi Apache Airflow

<DB-identifier-name>Saya tidak dapat terhubung ke server MySQL saya di '.cluster-id. <region>.rds.amazonaws.com'

Grup keamanan Amazon MWAA dan grup keamanan RDS memerlukan aturan masuk untuk memungkinkan lalu lintas ke dan dari satu sama lain. Kami merekomendasikan langkah-langkah berikut:

-

Ubah grup keamanan RDS untuk mengizinkan semua lalu lintas dari grup keamanan VPC Amazon MWAA.

-

Ubah grup keamanan VPC Amazon MWAA untuk memungkinkan semua lalu lintas dari grup keamanan RDS.

-

Jalankan kembali tugas Anda dan verifikasi apakah kueri SQL berhasil dengan memeriksa log Apache Airflow di Log. CloudWatch

Server web

Topik berikut menjelaskan kesalahan yang mungkin Anda terima untuk server Web Apache Airflow Anda di Amazon MWAA.

Saya menggunakan BigQueryOperator dan itu menyebabkan server web saya mogok

Kami merekomendasikan langkah-langkah berikut:

-

Operator Apache Airflow seperti

BigQueryOperatorQuboleOperatordan yangoperator_extra_linksberisi dapat menyebabkan server web Apache Airflow Anda mogok. Operator ini mencoba memuat kode ke server web Anda, yang tidak diizinkan karena alasan keamanan. Kami menyarankan untuk menambal operator di DAG Anda dengan menambahkan kode berikut setelah pernyataan impor Anda:BigQueryOperator.operator_extra_links = None -

Uji DAGs, plugin kustom, dan dependensi Python Anda secara lokal menggunakan on. aws-mwaa-local-runner

GitHub

Saya melihat kesalahan 5xx saat mengakses server web

Kami merekomendasikan langkah-langkah berikut:

-

Periksa opsi konfigurasi Apache Airflow. Verifikasi bahwa pasangan nilai kunci yang Anda tentukan sebagai opsi konfigurasi Apache Airflow, seperti AWS Secrets Manager, telah dikonfigurasi dengan benar. Untuk mempelajari lebih lanjut, lihatSaya tidak dapat terhubung ke Secrets Manager.

-

Periksa

requirements.txt. Verifikasi paket “ekstra” Aliran Udara dan pustaka lain yang tercantum dalam Andarequirements.txtkompatibel dengan versi Apache Airflow Anda. -

Jelajahi cara untuk menentukan dependensi Python dalam

requirements.txtfile, lihat. Mengelola dependensi Python di requirements.txt

Saya melihat kesalahan 'Penjadwal tampaknya tidak berjalan'

Jika penjadwal tampaknya tidak berjalan, atau “detak jantung” terakhir diterima beberapa jam yang lalu, Anda DAGs mungkin tidak muncul di Apache Airflow, dan tugas baru tidak akan dijadwalkan.

Kami merekomendasikan langkah-langkah berikut:

-

Konfirmasikan bahwa grup keamanan VPC Anda mengizinkan akses masuk ke port.

5432Port ini diperlukan untuk terhubung ke database metadata Amazon Aurora PostgreSQL untuk lingkungan Anda. Setelah aturan ini ditambahkan, berikan Amazon MWAA beberapa menit, dan kesalahan akan hilang. Untuk mempelajari lebih lanjut, lihatKeamanan di VPC Anda di Amazon MWAA.catatan

-

Kesalahan terkait database biasanya merupakan gejala kegagalan penjadwal dan bukan akar penyebabnya.

-

Jika scheduler tidak berjalan, mungkin karena sejumlah faktor seperti kegagalan instalasi dependensi, atau penjadwal kelebihan beban. Konfirmasikan bahwa DAGs, plugin, dan persyaratan Anda berfungsi dengan benar dengan melihat grup log yang sesuai di CloudWatch Log. Untuk mempelajari lebih lanjut, lihatPemantauan dan metrik untuk Alur Kerja Terkelola Amazon untuk Apache Airflow.

Tugas

Topik berikut menjelaskan kesalahan yang mungkin Anda terima untuk tugas Apache Airflow di suatu lingkungan.

Saya melihat tugas saya macet atau tidak selesai

Jika tugas Apache Airflow Anda “macet” atau tidak selesai, kami merekomendasikan langkah-langkah berikut:

-

Mungkin ada sejumlah besar yang DAGs didefinisikan. Kurangi jumlah DAGs dan lakukan pembaruan lingkungan (seperti mengubah level log) untuk memaksa reset.

-

Aliran udara DAGs mem-parsing apakah mereka diaktifkan atau tidak. Jika Anda menggunakan lebih dari 50% kapasitas lingkungan Anda, Anda dapat mulai mengatasi Apache Airflow Scheduler. Hal ini menyebabkan Total Parse Time yang besar dalam CloudWatch Metrik atau waktu pemrosesan DAG yang lama di CloudWatch Log. Ada cara lain untuk mengoptimalkan konfigurasi Apache Airflow yang berada di luar cakupan panduan ini.

-

Untuk mempelajari lebih lanjut tentang praktik terbaik yang kami sarankan untuk menyesuaikan kinerja lingkungan Anda, lihatPenyetelan kinerja untuk Apache Airflow di Amazon MWAA.

-

-

Mungkin ada banyak tugas dalam antrian. Ini sering muncul sebagai jumlah tugas yang besar—dan berkembang—dalam status “Tidak Ada”, atau sebagai jumlah besar dalam Tugas Tugas Antrian Tertunda. and/or CloudWatch Ini dapat terjadi karena alasan berikut:

-

Jika ada lebih banyak tugas untuk dijalankan daripada lingkungan yang memiliki kapasitas untuk dijalankan, and/or sejumlah besar tugas yang diantrian sebelum penskalaan otomatis memiliki waktu untuk mendeteksi tugas dan menyebarkan Pekerja tambahan.

-

Jika ada lebih banyak tugas untuk dijalankan daripada lingkungan yang memiliki kapasitas untuk dijalankan, kami sarankan untuk mengurangi jumlah tugas yang Anda DAGs jalankan secara bersamaan, and/or meningkatkan Pekerja Apache Airflow minimum.

-

Jika ada sejumlah besar tugas yang diantrian sebelum penskalaan otomatis memiliki waktu untuk mendeteksi dan menyebarkan pekerja tambahan, kami merekomendasikan penerapan tugas yang mengejutkan untuk meningkatkan Pekerja Aliran Udara Apache minimum. and/or

-

Anda dapat menggunakan perintah update-environment di AWS Command Line Interface (AWS CLI) untuk mengubah jumlah minimum atau maksimum Pekerja yang berjalan di lingkungan Anda.

aws mwaa update-environment --name MyEnvironmentName --min-workers 2 --max-workers 10 -

Untuk mempelajari lebih lanjut tentang praktik terbaik yang kami sarankan untuk menyesuaikan kinerja lingkungan Anda, lihatPenyetelan kinerja untuk Apache Airflow di Amazon MWAA.

-

-

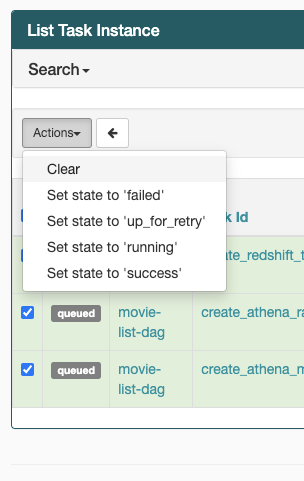

Jika tugas Anda macet dalam status “berjalan”, Anda juga dapat menghapus tugas atau menandainya sebagai berhasil atau gagal. Hal ini memungkinkan komponen penskalaan otomatis untuk lingkungan Anda untuk mengurangi jumlah pekerja yang berjalan di lingkungan Anda. Gambar berikut menunjukkan contoh tugas yang terdampar.

-

Pilih lingkaran untuk tugas yang terdampar, lalu pilih Hapus (seperti yang ditunjukkan). Hal ini memungkinkan Amazon MWAA untuk menurunkan skala pekerja; jika tidak, Amazon MWAA tidak dapat menentukan mana yang DAGs diaktifkan atau dinonaktifkan, dan tidak dapat menurunkan skala, jika masih ada tugas antrian.

-

-

Pelajari lebih lanjut tentang siklus hidup tugas Apache Airflow di Concepts dalam

panduan referensi Apache Airflow.

CLI

Topik berikut menjelaskan kesalahan yang mungkin Anda terima saat menjalankan perintah CLI Aliran Udara di. AWS Command Line Interface

Saya melihat kesalahan '503' saat memicu DAG di CLI

CLI Airflow berjalan di server Web Apache Airflow, yang memiliki konkurensi terbatas. Biasanya maksimal 4 perintah CLI dapat berjalan secara bersamaan.