Avviso di fine del supporto: il 7 ottobre 2026, AWS il supporto per. AWS IoT Greengrass Version 1 Dopo il 7 ottobre 2026, non potrai più accedere alle risorse. AWS IoT Greengrass V1 Per ulteriori informazioni, visita Migrate from. AWS IoT Greengrass Version 1

Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Come configurare l'inferenza di Machine Learning mediante la Console di gestione AWS

Per seguire i passaggi di questo tutorial, è necessario AWS IoT Greengrass Core v1.10 o versione successiva.

Puoi eseguire l'inferenza di Machine Learning (ML) in locale su un dispositivo core Greengrass utilizzando i dati generati localmente. Per informazioni, inclusi i requisiti e i vincoli, consulta Esecuzione dell'inferenza di Machine Learning.

Questo tutorial descrive come utilizzare Console di gestione AWS per configurare un gruppo Greengrass per eseguire un'app di inferenza Lambda che riconosce le immagini da una fotocamera localmente, senza inviare dati al cloud. L'app di inferenza accede al modulo fotocamera su un Raspberry Pi ed esegue l'inferenza utilizzando il modello open source. SqueezeNet

Il tutorial include le seguenti fasi di alto livello:

Prerequisiti

Per completare questo tutorial, è necessario quanto segue:

-

Raspberry Pi 4 Model B o Raspberry Pi 3 Model B/B+, configurato e configurato per l'uso con. AWS IoT Greengrass Per configurare Raspberry Pi con AWS IoT Greengrass, eseguire lo script di configurazione del dispositivo Greengrass o assicurarsi di aver completato il modulo 1 e il modulo 2 di Iniziare con AWS IoT Greengrass.

Nota

Il Raspberry Pi potrebbe richiedere un alimentatore

da 2,5 A per eseguire i framework di deep learning generalmente utilizzati per la classificazione delle immagini. Un alimentatore con una potenza nominale inferiore potrebbe causare il riavvio del dispositivo. -

Modulo della telecamera Raspberry Pi V2 da 8 Megapixel, 1080p

. Per informazioni su come configurare la fotocamera, consulta Collegamento della fotocamera nella documentazione di Raspberry Pi. -

Un gruppo e un core Greengrass. Per informazioni su come creare un gruppo o un nucleo Greengrass, vedere. Iniziare con AWS IoT Greengrass

Nota

Questo tutorial utilizza un Raspberry Pi, ma AWS IoT Greengrass supporta altre piattaforme, come Intel Atom e NVIDIA Jetson. TX2 Nell'esempio di Jetson TX2, è possibile utilizzare immagini statiche anziché immagini trasmesse in streaming da una fotocamera. Se si utilizza l' TX2 esempio Jetson, potrebbe essere necessario installare Python 3.6 anziché Python 3.7. Per informazioni sulla configurazione del dispositivo in modo da poter installare il software Core, consulta. AWS IoT Greengrass Configurazione di altri dispositivi

Per le piattaforme di terze parti che AWS IoT Greengrass non supportano, è necessario eseguire la funzione Lambda in modalità non containerizzata. Per l'esecuzione in modalità non containerizzata, è necessario eseguire la funzione Lambda come utente root. Per ulteriori informazioni, consulta Considerazioni sulla scelta della containerizzazione delle funzioni Lambda e Impostazione dell'identità di accesso predefinita per le funzioni Lambda in un gruppo.

Fase 1: Configurare il dispositivo Raspberry Pi

In questa fase, verranno installati gli aggiornamenti del sistema operativo Raspbian, il software del modulo della telecamera e le dipendenze Python e verrà abilitata l'interfaccia della telecamera.

Esegui i seguenti comandi nel terminale Raspberry Pi.

-

Installare gli aggiornamenti in Raspbian.

sudo apt-get update sudo apt-get dist-upgrade -

Installare l'interfaccia

picameraper il modulo della telecamera e le altre librerie Python necessarie per questo tutorial.sudo apt-get install -y python3-dev python3-setuptools python3-pip python3-picameraConvalidare l'installazione:

-

Assicurati che l'installazione di Python 3.7 includa pip.

python3 -m pipSe pip non è installato, scaricarlo dal sito Web pip

ed eseguire il comando seguente. python3 get-pip.py -

Assicurati che la versione Python sia 3.7 o superiore.

python3 --versionSe l'output elenca una versione precedente, eseguire il comando seguente.

sudo apt-get install -y python3.7-dev -

Assicurati che Setuptools e Picamera siano stati installati correttamente.

sudo -u ggc_user bash -c 'python3 -c "import setuptools"' sudo -u ggc_user bash -c 'python3 -c "import picamera"'Se l'output non contiene errori, la convalida ha esito positivo.

Nota

Se l'eseguibile Python installato sul dispositivo è

python3.7, utilizzarepython3.7invece dipython3per i comandi in questo tutorial. Assicurati che l'installazione di pip sia mappata alla versionepython3.7opython3corretta per evitare errori di dipendenza. -

-

Riavvia il dispositivo Raspberry Pi.

sudo reboot -

Apri lo strumento di configurazione di Raspberry Pi.

sudo raspi-config -

Utilizza i tasti freccia per aprire Interfacing Options (Opzioni di interfaccia) e abilita l'interfaccia della telecamera. Se richiesto, consenti il riavvio del dispositivo.

-

Utilizza il seguente comando per eseguire il test della configurazione della telecamera.

raspistill -v -o test.jpgViene visualizzata una finestra di anteprima sul dispositivo Raspberry Pi, viene salvata un'immagine denominata

test.jpgnella directory corrente e vengono visualizzati informazioni sulla telecamera nel terminale Raspberry Pi.

Fase 2: Installare il framework MXNet

In questo passaggio, installa MXNet le librerie sul tuo Raspberry Pi.

-

Accedere al Raspberry Pi da remoto.

ssh pi@your-device-ip-address -

Apri la MXNet documentazione, apri Installazione MXNet

e segui le istruzioni per l'installazione MXNet sul dispositivo. Nota

Ti consigliamo di installare la versione 1.5.0 e di compilarlo MXNet dal codice sorgente per questo tutorial per evitare conflitti tra dispositivi.

-

Dopo l'installazione MXNet, convalida la seguente configurazione:

-

Assicurati che l'account

ggc_userdi sistema possa utilizzare il MXNet framework.sudo -u ggc_user bash -c 'python3 -c "import mxnet"' -

Assicurati che NumPy sia installato.

sudo -u ggc_user bash -c 'python3 -c "import numpy"'

-

Fase 3: Creare un pacchetto MXNet modello

In questo passaggio, crea un pacchetto modello che contenga un MXNet modello preaddestrato di esempio da caricare su Amazon Simple Storage Service (Amazon S3). AWS IoT Greengrass può utilizzare un pacchetto modello di Amazon S3, a condizione che utilizzi il formato tar.gz o zip.

-

Sul tuo computer, scarica l' MXNet esempio per Raspberry Pi da. Esempi di Machine Learning

-

Decomprimere il file

mxnet-py3-armv7l.tar.gzscaricato. -

Passa alla directory

squeezenet.cdpath-to-downloaded-sample/mxnet-py3-armv7l/models/squeezenetIl file

squeezenet.zipin questa directory è il pacchetto del modello. Contiene elementi del modello SqueezeNet open source per un modello di classificazione delle immagini. Successivamente, carichi questo pacchetto modello su Amazon S3.

Fase 4: Creare e pubblicare una funzione Lambda

In questo passaggio, crea un pacchetto di distribuzione della funzione Lambda e una funzione Lambda. Quindi pubblicare una versione della funzione e creare un alias.

Innanzitutto, crea il pacchetto di distribuzione della funzione Lambda.

-

Nel computer, passare alla directory

examplesnel pacchetto di esempio decompresso in Fase 3: Creare un pacchetto MXNet modello.cdpath-to-downloaded-sample/mxnet-py3-armv7l/examplesLa directory

examplescontiene il codice di funzione e le dipendenze.-

greengrassObjectClassification.pyè il codice di inferenza utilizzato in questo tutorial. È possibile utilizzare questo codice come modello per creare la propria funzione di inferenza. -

greengrasssdkè la versione 1.5.0 del AWS IoT Greengrass Core SDK for Python.Nota

Se è disponibile una nuova versione, è possibile scaricarla e aggiornare la versione dell'SDK nel pacchetto di distribuzione. Per ulteriori informazioni, consulta AWS IoT Greengrass Core SDK for GitHub Python on

.

-

-

Comprimere il contenuto della directory

examplesin un file denominatogreengrassObjectClassification.zip. Questo è il pacchetto di distribuzione.zip -r greengrassObjectClassification.zip .Nota

Assicurarsi inoltre che i file

.pye le dipendenze si trovino nella radice della directory.Quindi, crea la funzione Lambda.

-

Dalla AWS IoT console, scegli Funzioni e Crea funzione.

-

Scegli Author da zero e usa i seguenti valori per creare la tua funzione:

-

Nel campo Function name (Nome funzione), immettere

greengrassObjectClassification. -

In Runtime, scegliere Python 3.7.

Per le autorizzazioni, mantieni l'impostazione predefinita. Questo crea un ruolo di esecuzione che concede le autorizzazioni Lambda di base. Questo ruolo non viene utilizzato da. AWS IoT Greengrass

-

-

Scegli Crea funzione.

Ora carica il pacchetto di distribuzione della funzione Lambda e registra il gestore.

-

Scegli la tua funzione Lambda e carica il pacchetto di implementazione della funzione Lambda.

-

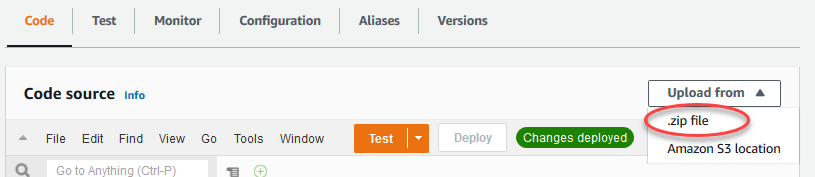

Nella scheda Codice, in Codice sorgente, scegli Carica da. Dal menu a discesa, scegli un file.zip.

-

Scegli Carica, quindi scegli il pacchetto di

greengrassObjectClassification.zipdistribuzione. Quindi, scegliere Save (Salva). -

Nella scheda Codice della funzione, in Impostazioni di runtime, scegliete Modifica, quindi immettete i seguenti valori.

-

In Runtime, scegliere Python 3.7.

-

Per Handler (Gestore), inserire

greengrassObjectClassification.function_handler.

Seleziona Salva.

-

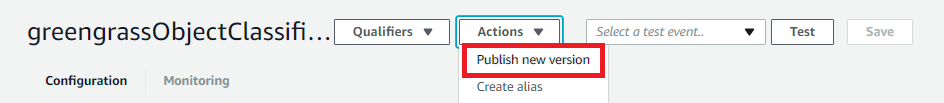

Successivamente, pubblica la prima versione della tua funzione Lambda. Quindi, creare un alias per la versione.

Nota

I gruppi Greengrass possono fare riferimento a una funzione Lambda tramite alias (consigliato) o per versione. L'utilizzo di un alias semplifica la gestione degli aggiornamenti del codice perché non è necessario modificare la tabella di sottoscrizione o la definizione del gruppo quando il codice della funzione viene aggiornato. Invece, è sufficiente indirizzare l'alias alla nuova versione della funzione.

-

-

Nel menu Actions (Operazioni), seleziona Publish new version (Pubblica nuova versione).

-

Per Version description (Descrizione versione), immettere

First version, quindi scegliere Publish (Pubblica). -

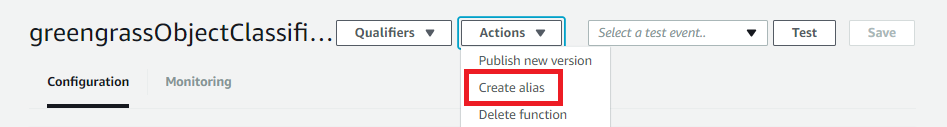

Nella pagina di configurazione greengrassObjectClassification: 1, dal menu Azioni, scegli Crea alias.

-

Nella pagina Create a new alias (Crea un nuovo alias), utilizza i seguenti valori:

-

Per Nome, immetti

mlTest. -

Per Version (Versione), immettere

1.

Nota

AWS IoT Greengrass non supporta gli alias Lambda per le versioni $LATEST.

-

-

Seleziona Salva.

Ora aggiungete la funzione Lambda al vostro gruppo Greengrass.

Fase 5: Aggiungere la funzione Lambda al gruppo Greengrass

In questo passaggio, aggiungi la funzione Lambda al gruppo e quindi configura il ciclo di vita e le variabili di ambiente.

Innanzitutto, aggiungi la funzione Lambda al tuo gruppo Greengrass.

-

Nel riquadro di navigazione della AWS IoT console, in Gestione, espandi i dispositivi Greengrass, quindi scegli Gruppi (V1).

-

Dalla pagina di configurazione del gruppo, scegli la scheda Funzioni Lambda.

-

Nella sezione Funzioni My Lambda, scegli Aggiungi.

-

Per la funzione Lambda, scegli. greengrassObjectClassification

-

Per la versione della funzione Lambda, scegli Alias:MLTest.

Quindi, configura il ciclo di vita e le variabili di ambiente della funzione Lambda.

-

Nella sezione di configurazione della funzione Lambda, apporta i seguenti aggiornamenti.

Nota

Ti consigliamo di eseguire la funzione Lambda senza containerizzazione, a meno che il tuo business case non lo richieda. Ciò consente l'accesso alla GPU e alla fotocamera del dispositivo senza configurare le risorse del dispositivo. Se esegui senza containerizzazione, devi anche concedere l'accesso root alle tue funzioni Lambda AWS IoT Greengrass .

-

Per eseguire senza containerizzazione:

-

Per Utente e gruppo di sistema, scegli.

Another user ID/group IDPer ID utente di sistema, immettere0. Per ID del gruppo di sistema, immettere0.Ciò consente alla funzione Lambda di funzionare come root. Per ulteriori informazioni sull'esecuzione come root, consultaImpostazione dell'identità di accesso predefinita per le funzioni Lambda in un gruppo.

Suggerimento

È inoltre necessario aggiornare il

config.jsonfile per concedere l'accesso root alla funzione Lambda. Per la procedura, vediEsecuzione di una funzione Lambda come utente root. -

Per la containerizzazione della funzione Lambda, scegli Nessun contenitore.

Per ulteriori informazioni sull'esecuzione senza containerizzazione, consulta. Considerazioni sulla scelta della containerizzazione delle funzioni Lambda

-

Per Timeout, immettere

10 seconds. -

Per Pinned, scegli True.

Per ulteriori informazioni, consulta Configurazione del ciclo di vita per le funzioni Greengrass Lambda.

-

-

Per eseguire invece in modalità containerizzata:

Nota

Si sconsiglia l'esecuzione in modalità containerizzata a meno che il business case non lo richieda.

-

Per Utente e gruppo di sistema, scegli Usa i valori predefiniti del gruppo.

-

Per la containerizzazione delle funzioni Lambda, scegli Usa default di gruppo.

-

Per Memory limit (Limite memoria), immettere

96 MB. -

Per Timeout, immettere

10 seconds. -

Per Pinned, scegli True.

Per ulteriori informazioni, consulta Configurazione del ciclo di vita per le funzioni Greengrass Lambda.

-

-

-

In Environment variables (Variabili di ambiente), creare una coppia chiave-valore. Una coppia chiave-valore è richiesta dalle funzioni che interagiscono con i MXNet modelli su un Raspberry Pi.

Per la chiave, utilizzare MXNET_ENGINE_TYPE. Per il valore, usa. NaiveEngine

Nota

Nelle funzioni Lambda definite dall'utente, puoi facoltativamente impostare la variabile di ambiente nel codice della funzione.

-

Mantieni i valori predefiniti per tutte le altre proprietà e scegli Aggiungi funzione Lambda.

Fase 6: aggiunta di risorse al gruppo Greengrass

In questo passaggio, crea risorse per il modulo telecamera e il modello di inferenza ML e associa le risorse alla funzione Lambda. Ciò consente alla funzione Lambda di accedere alle risorse sul dispositivo principale.

Nota

Se si esegue in modalità non containerizzata, è AWS IoT Greengrass possibile accedere alla GPU e alla fotocamera del dispositivo senza configurare queste risorse del dispositivo.

Innanzitutto, crea due risorse locali per la telecamera: una per la memoria condivisa e una per l'interfaccia del dispositivo. Per ulteriori informazioni sull'accesso alle risorse locali, consulta Accedi alle risorse locali con funzioni e connettori Lambda.

-

Nella pagina di configurazione del gruppo, scegli la scheda Risorse.

-

Nella sezione Risorse locali, scegli Aggiungi risorsa locale.

-

Nella pagina Aggiungi una risorsa locale, utilizza i seguenti valori:

-

Per Resource Name (Nome risorsa) immetti

videoCoreSharedMemory. -

Per Resource type (Tipo di risorsa), scegli Device (Dispositivo).

-

Per Percorso del dispositivo locale, immettere

/dev/vcsm.Il percorso del dispositivo è il percorso assoluto locale della risorsa del dispositivo. Questo percorso può fare riferimento solo a un dispositivo a caratteri o un dispositivo a blocchi in

/dev. -

Per il proprietario del gruppo di sistema e le autorizzazioni di accesso ai file, scegli Aggiungi automaticamente le autorizzazioni del file system del gruppo di sistema proprietario della risorsa.

L'opzione System group owner and file access permissions (proprietario del gruppo di sistema e autorizzazioni di accesso ai file) consente di concedere ulteriori autorizzazioni di accesso ai file al processo Lambda. Per ulteriori informazioni, consulta Autorizzazione di accesso ai file dell'owner del gruppo.

-

-

A questo punto, aggiungi una risorsa del dispositivo locale per l'interfaccia della telecamera.

-

Scegli Aggiungi risorsa locale.

-

Nella pagina Aggiungi una risorsa locale, utilizza i seguenti valori:

-

Per Resource Name (Nome risorsa) immetti

videoCoreInterface. -

Per Resource type (Tipo di risorsa), scegli Device (Dispositivo).

-

Per Percorso del dispositivo locale, immettere

/dev/vchiq. -

Per il proprietario del gruppo di sistema e le autorizzazioni di accesso ai file, scegli Aggiungi automaticamente le autorizzazioni del file system del gruppo di sistema proprietario della risorsa.

-

-

Nella parte inferiore della pagina, scegli Aggiungi risorsa.

Ora aggiungi il modello di inferenza come una risorsa Machine Learning. Questo passaggio include il caricamento del pacchetto squeezenet.zip modello su Amazon S3.

-

Nella scheda Risorse per il tuo gruppo, nella sezione Machine Learning, scegli Aggiungi risorsa di machine learning.

-

Nella pagina Aggiungi una risorsa di machine learning, per Nome risorsa, inserisci

squeezenet_model. -

Per Model source, scegli Usa un modello archiviato in S3, ad esempio un modello ottimizzato tramite Deep Learning Compiler.

-

Per S3 URI, inserisci un percorso in cui viene salvato il bucket S3.

-

Seleziona Sfoglia S3. Si apre una nuova scheda nella console Amazon S3.

-

Nella scheda della console Amazon S3, carica il

squeezenet.zipfile in un bucket S3. Per informazioni, vedi Come faccio a caricare file e cartelle in un bucket S3? nella Guida per l'utente di Amazon Simple Storage Service.Nota

Affinché il bucket S3 sia accessibile, il nome del bucket deve contenere la stringa

greengrasse il bucket deve trovarsi nella stessa regione per cui lo utilizzi. AWS IoT Greengrass Scegliere un nome univoco (ad esempiogreengrass-bucket-). Non utilizzare un punto (user-id-epoch-time.) nel nome del bucket. -

Nella scheda della AWS IoT Greengrass console, individua e scegli il tuo bucket S3. Individuare e il file

squeezenet.zipcaricato e scegliere Select (Seleziona). Potrebbe essere necessario scegliere Refresh (Aggiorna) per aggiornare l'elenco dei bucket e dei file disponibili. -

Per Destination path (Percorso di destinazione), immetti

/greengrass-machine-learning/mxnet/squeezenet.Questa è la destinazione del modello locale nello spazio dei nomi di runtime Lambda. Quando distribuisci il gruppo, AWS IoT Greengrass recupera il pacchetto del modello sorgente e quindi estrae il contenuto nella directory specificata. La funzione Lambda di esempio per questo tutorial è già configurata per utilizzare questo percorso (nella

model_pathvariabile). -

In Proprietario del gruppo di sistema e autorizzazioni di accesso ai file, scegli Nessun gruppo di sistema.

-

Scegliere Add resource (Aggiungi risorsa).

Utilizzo di modelli addestrati all' SageMaker intelligenza artificiale

Questo tutorial utilizza un modello archiviato in Amazon S3, ma puoi utilizzare facilmente anche modelli SageMaker AI. La AWS IoT Greengrass console ha un'integrazione SageMaker AI integrata, quindi non è necessario caricare manualmente questi modelli su Amazon S3. Per i requisiti e le limitazioni per l'utilizzo dei modelli di SageMaker intelligenza artificiale, consultaOrigini di modello supportate.

Per utilizzare un modello di SageMaker intelligenza artificiale:

-

Per Model source, scegli Usa un modello addestrato all' AWS SageMaker intelligenza artificiale, quindi scegli il nome del processo di formazione del modello.

-

Per Percorso di destinazione, inserisci il percorso della directory in cui la funzione Lambda cerca il modello.

Fase 7: aggiunta di una sottoscrizione al gruppo Greengrass

In questa fase, aggiungere una sottoscrizione al gruppo. Questo abbonamento consente alla funzione Lambda di inviare risultati di previsione AWS IoT pubblicandoli su un argomento MQTT.

-

Nella pagina di configurazione del gruppo, scegli la scheda Abbonamenti, quindi scegli Aggiungi abbonamento.

-

Nella pagina dei dettagli dell'abbonamento, configura l'origine e la destinazione come segue:

-

In Tipo di sorgente, scegli Funzione Lambda, quindi scegli. greengrassObjectClassification

-

Nel tipo di Target, scegli Servizio, quindi scegli IoT Cloud.

-

-

Nel filtro per argomenti

hello/world, inserisci, quindi scegli Crea abbonamento.

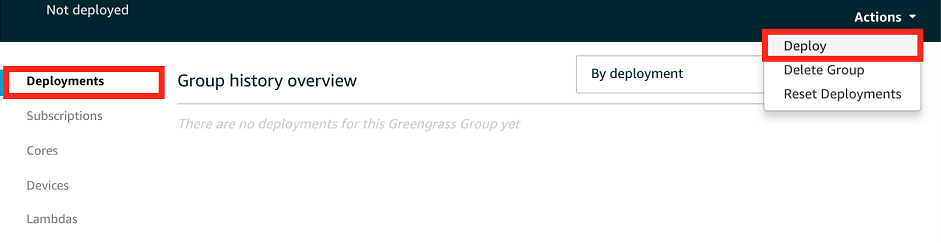

Fase 8: distribuzione del gruppo Greengrass

In questa fase, distribuire la versione corrente della definizione del gruppo nel dispositivo core Greengrass. La definizione contiene la funzione Lambda, le risorse e le configurazioni di sottoscrizione che hai aggiunto.

-

Assicurati che il AWS IoT Greengrass core sia in esecuzione. Esegui i seguenti comandi nel terminale di Raspberry Pi in base alle esigenze.

Per controllare se il daemon è in esecuzione:

ps aux | grep -E 'greengrass.*daemon'Se l'output contiene una voce

rootper/greengrass/ggc/packages/1.11.6/bin/daemon, allora il daemon è in esecuzione.Nota

La versione indicata nel percorso dipende dalla versione del software AWS IoT Greengrass Core installata sul dispositivo principale.

Per avviare il demone:

cd /greengrass/ggc/core/ sudo ./greengrassd start

-

Nella pagina di configurazione del gruppo, scegli Deploy.

-

Nella scheda Funzioni Lambda, nella sezione Funzioni System Lambda, seleziona Rilevatore IP e scegli Modifica.

-

Nella finestra di dialogo Modifica impostazioni del rilevatore IP, seleziona Rileva e sostituisci automaticamente gli endpoint del broker MQTT.

-

Seleziona Salva.

Questo consente ai dispositivi di acquisire automaticamente informazioni di base sulla connettività, come, ad esempio indirizzo IP, DNS e numero della porta. Il rilevamento automatico è consigliato, ma supporta AWS IoT Greengrass anche gli endpoint specificati manualmente. Ti viene chiesto il metodo di individuazione solo la prima volta che il gruppo viene distribuito.

Nota

Se richiesto, concedi l'autorizzazione a creare il ruolo di servizio Greengrass e associarlo al Account AWS tuo ruolo attuale. Regione AWS Questo ruolo consente di accedere AWS IoT Greengrass alle tue risorse nei AWS servizi.

Nella pagina Deployments (Distribuzioni) vengono visualizzati il timestamp della distribuzione, l'ID versione e lo stato. Una volta completata, lo stato visualizzato per la distribuzione dovrebbe essere Completato.

Per ulteriori informazioni sulle implementazioni, consulta Distribuisci AWS IoT Greengrass i gruppi su un core AWS IoT Greengrass. Per la risoluzione dei problemi, consultare Risoluzione dei problemi AWS IoT Greengrass.

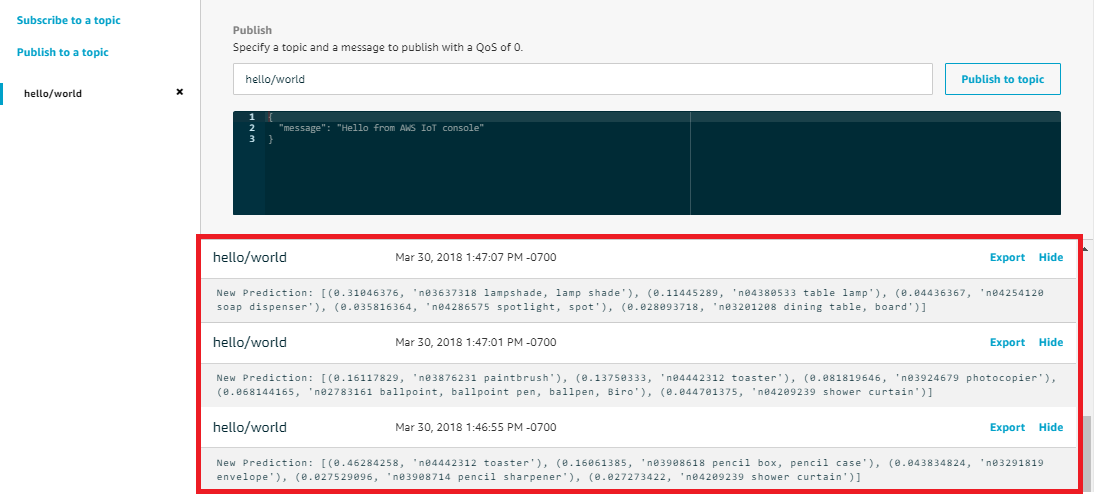

Fase 9: esecuzione del test dell'app di inferenza

Ora puoi verificare se la distribuzione è configurata correttamente. Per eseguire il test, è necessario abbonarsi all'hello/worldargomento e visualizzare i risultati della previsione pubblicati dalla funzione Lambda.

Nota

Se a dispositivo Raspberry Pi è collegato un monitor, il segnale attivo della telecamera viene visualizzato in una finestra di anteprima.

-

Nella AWS IoT console, in Test, scegli MQTT test client.

-

In Subscriptions (Sottoscrizioni), utilizza i seguenti valori:

-

Per l’argomento della sottoscrizione, utilizzare ciao/mondo.

-

In Configurazione aggiuntiva, per la visualizzazione del payload MQTT, scegli Visualizza i payload come stringhe.

-

-

Scegliere Subscribe (Effettua sottoscrizione).

Se il test ha esito positivo, i messaggi della funzione Lambda vengono visualizzati nella parte inferiore della pagina. Ogni messaggio contiene i primi cinque risultati predittivi dell'immagine nel formato: probabilità, ID classe prevista e nome della classe corrispondente.

Risoluzione dei problemi di AWS IoT Greengrass inferenza ML

Se il test non viene completato correttamente, puoi provare a eseguire la procedura di risoluzione dei problemi riportata di seguito. Esegui i comandi nel terminale Raspberry Pi.

Controlla i log degli errori

-

Passare all'utente root e navigare alla directory

log. L'accesso ai AWS IoT Greengrass log richiede i permessi di root.sudo su cd /greengrass/ggc/var/log -

Nella directory

system, controllareruntime.logopython_runtime.log.Nella directory

user/, controllareregion/account-idgreengrassObjectClassification.log.Per ulteriori informazioni, consulta Risoluzione dei problemi con i log.

Errore di decompressione in runtime.log

Se runtime.log contiene un errore simile al seguente, assicurati che il pacchetto del modello di origine tar.gz contenga una directory principale.

Greengrass deployment error: unable to download the artifact model-arn: Error while processing.

Error while unpacking the file from /tmp/greengrass/artifacts/model-arn/path to /greengrass/ggc/deployment/path/model-arn,

error: open /greengrass/ggc/deployment/path/model-arn/squeezenet/squeezenet_v1.1-0000.params: no such file or directorySe il pacchetto non dispone di una directory principale contenente i file del modello, ricomprimi il modello utilizzando il seguente comando:

tar -zcvf model.tar.gz ./model

Per esempio:

─$tar -zcvf test.tar.gz ./test./test ./test/some.file ./test/some.file2 ./test/some.file3

Nota

Non includere i caratteri finali /* in questo comando.

Verifica che la funzione Lambda sia implementata correttamente

-

Elenca il contenuto della Lambda distribuita nella

/lambdadirectory. Prima di eseguire il comando, sostituisci i valori dei segnaposti.cd /greengrass/ggc/deployment/lambda/arn:aws:lambda:region:account:function:function-name:function-versionls -la -

Verifica che la directory contenga gli stessi file inclusi nel pacchetto di distribuzione

greengrassObjectClassification.zipcaricato in Fase 4: Creare e pubblicare una funzione Lambda.Assicurati inoltre che i file

.pye le dipendenze si trovino nella root della directory.

Verifica che il modello di inferenza sia stato distribuito correttamente

-

Trova il numero di identificazione del processo (PID) del processo di runtime Lambda:

ps aux | grep 'lambda-function-name*'Nell'output, il PID appare nella seconda colonna della riga per il processo di runtime Lambda.

-

Inserisci lo spazio dei nomi di runtime Lambda. Assicurati di sostituire il

pidvalore segnaposto prima di eseguire il comando.Nota

Questa directory e il suo contenuto si trovano nello spazio dei nomi di runtime Lambda, quindi non sono visibili in un normale spazio dei nomi Linux.

sudo nsenter -tpid-m /bin/bash -

Elenca i contenuti della directory locale specificata per la risorsa ML.

cd /greengrass-machine-learning/mxnet/squeezenet/ ls -lsDovrebbero essere visualizzati i seguenti file:

32 -rw-r--r-- 1 ggc_user ggc_group 31675 Nov 18 15:19 synset.txt 32 -rw-r--r-- 1 ggc_user ggc_group 28707 Nov 18 15:19 squeezenet_v1.1-symbol.json 4832 -rw-r--r-- 1 ggc_user ggc_group 4945062 Nov 18 15:19 squeezenet_v1.1-0000.params

Passaggi successivi

Successivamente, esplora altre app di inferenza. AWS IoT Greengrass fornisce altre funzioni Lambda che è possibile utilizzare per provare l'inferenza locale. Il pacchetto degli esempi è disponibile nella cartella delle librerie precompilate scaricata nella Fase 2: Installare il framework MXNet .

Configurazione di un dispositivo Intel Atom

Per eseguire questo tutorial su un dispositivo Intel Atom, è necessario fornire immagini di origine, configurare la funzione Lambda e aggiungere un'altra risorsa del dispositivo locale. Per utilizzare la GPU per l'inferenza, assicurarsi che sul dispositivo sia installato il seguente software:

-

OpenCL versione 1.0 o successiva

-

Python 3.7 e pip

Nota

Se il dispositivo è preconfigurato con Python 3.6, puoi invece creare un collegamento simbolico a Python 3.7. Per ulteriori informazioni, consulta Passo 2.

-

Scarica immagini PNG o JPG statiche per la funzione Lambda da utilizzare per la classificazione delle immagini. L'esempio funziona in modo ottimale con file immagine di dimensioni ridotte.

Salva i file immagine nella directory contenente il file

greengrassObjectClassification.py(o in una sottodirectory di questa directory). Si trova nel pacchetto di distribuzione della funzione Lambda in cui carichi. Fase 4: Creare e pubblicare una funzione LambdaNota

Se la utilizzi AWS DeepLens, puoi utilizzare la videocamera di bordo o montare la tua fotocamera per eseguire inferenze sulle immagini acquisite anziché sulle immagini statiche. Tuttavia, ti consigliamo di iniziare con le immagini statiche.

Se si utilizza una telecamera, assicurarsi che il pacchetto APT

awscamsia installato e aggiornato. Per ulteriori informazioni, consulta Aggiorna il tuo AWS DeepLens dispositivo nella Guida per gli AWS DeepLens sviluppatori. -

Se non stai usando Python 3.7, assicurati di creare un collegamento simbolico da Python 3.x a Python 3.7. Questo configura il tuo dispositivo per usare Python 3 con. AWS IoT Greengrass Eseguire il seguente comando per individuare l'installazione di Python:

which python3Eseguire il comando seguente per creare il collegamento simbolico.

sudo ln -spath-to-python-3.x/python3.xpath-to-python-3.7/python3.7Riavviare il dispositivo.

-

Modifica la configurazione della funzione Lambda. Segui la procedura riportata in Fase 5: Aggiungere la funzione Lambda al gruppo Greengrass.

Nota

Ti consigliamo di eseguire la funzione Lambda senza containerizzazione, a meno che il tuo business case non lo richieda. Ciò consente l'accesso alla GPU e alla fotocamera del dispositivo senza configurare le risorse del dispositivo. Se esegui senza containerizzazione, devi anche concedere l'accesso root alle tue funzioni Lambda AWS IoT Greengrass .

-

Per eseguire senza containerizzazione:

-

Per Utente e gruppo di sistema, scegli.

Another user ID/group IDPer ID utente di sistema, immettere0. Per ID del gruppo di sistema, immettere0.Ciò consente alla funzione Lambda di funzionare come root. Per ulteriori informazioni sull'esecuzione come root, consultaImpostazione dell'identità di accesso predefinita per le funzioni Lambda in un gruppo.

Suggerimento

È inoltre necessario aggiornare il

config.jsonfile per concedere l'accesso root alla funzione Lambda. Per la procedura, vediEsecuzione di una funzione Lambda come utente root. -

Per la containerizzazione della funzione Lambda, scegli Nessun contenitore.

Per ulteriori informazioni sull'esecuzione senza containerizzazione, consulta. Considerazioni sulla scelta della containerizzazione delle funzioni Lambda

-

Aggiornare il valore Timeout a 5 secondi. In questo modo, il timeout della richiesta non viene eseguito troppo presto. L'esecuzione dell'inferenza richiede alcuni minuti dopo la configurazione.

-

In Bloccato, scegli True.

-

In Parametri aggiuntivi, per Accesso in lettura alla directory /sys, scegli Abilitato.

-

Per Lambda lifecycle (Ciclo di vita Lambda), scegli Make this function long-lived and keep it running indefinitely (Rendi questa funzione di lunga durata e mantieni in esecuzione a tempo indeterminato).

-

-

Per eseguire invece in modalità containerizzata:

Nota

Si sconsiglia l'esecuzione in modalità containerizzata a meno che il business case non lo richieda.

-

Aggiornare il valore Timeout a 5 secondi. In questo modo, il timeout della richiesta non viene eseguito troppo presto. L'esecuzione dell'inferenza richiede alcuni minuti dopo la configurazione.

-

Per Pinned, scegli True.

-

In Parametri aggiuntivi, per Accesso in lettura alla directory /sys, scegli Abilitato.

-

-

-

Se è in esecuzione in modalità containerizzata, aggiungi la risorsa del dispositivo locale richiesta per concedere l'accesso alla GPU del dispositivo.

Nota

Se esegui in modalità non containerizzata, AWS IoT Greengrass puoi accedere alla GPU del dispositivo senza configurare le risorse del dispositivo.

-

Nella pagina di configurazione del gruppo, scegli la scheda Risorse.

-

Scegli Aggiungi risorsa locale.

-

Definisci la risorsa:

-

Per Resource Name (Nome risorsa) immetti

renderD128. -

Per Tipo di risorsa, scegli Dispositivo locale.

-

Per Device path (Percorso dispositivo), immetti

/dev/dri/renderD128. -

Per il proprietario del gruppo di sistema e le autorizzazioni di accesso ai file, scegli Aggiungi automaticamente le autorizzazioni del file system del gruppo di sistema proprietario della risorsa.

-

Per le affiliazioni alle funzioni Lambda, concedi l'accesso in lettura e scrittura alla tua funzione Lambda.

-

-

Configurazione di un NVIDIA Jetson TX2

Per eseguire questo tutorial su un NVIDIA Jetson TX2, fornisci immagini sorgente e configura la funzione Lambda. Se stai utilizzando la GPU, devi anche aggiungere le risorse locali del dispositivo.

-

Assicurati che il tuo dispositivo Jetson sia configurato in modo da poter installare il software Core. AWS IoT Greengrass Per ulteriori informazioni sulla configurazione del dispositivo, consulta Configurazione di altri dispositivi.

-

Apri la MXNet documentazione, vai a Installazione MXNet su un Jetson

e segui le istruzioni per l'installazione MXNet sul dispositivo Jetson. Nota

Se vuoi creare MXNet dal codice sorgente, segui le istruzioni per creare la libreria condivisa. Modifica le seguenti impostazioni nel tuo

config.mkfile per lavorare con un dispositivo Jetson TX2 :-

Aggiungere

-gencode arch=compute-62, code=sm_62all'impostazioneCUDA_ARCH. -

Attivare CUDA.

USE_CUDA = 1

-

-

Scarica immagini PNG o JPG statiche per la funzione Lambda da utilizzare per la classificazione delle immagini. L'app funziona in modo ottimale con i file immagine di dimensioni ridotte. In alternativa, puoi implementare una telecamera sulla scheda Jetson per acquisire le immagini di origine.

Salvare i file immagine nella directory contenente il file

greengrassObjectClassification.py. È possibile salvarli anche in una sottodirectory di questa directory. Questa directory si trova nel pacchetto di distribuzione della funzione Lambda in cui carichi. Fase 4: Creare e pubblicare una funzione Lambda -

Crea un collegamento simbolico da Python 3.7 a Python 3.6 con cui usare Python 3. AWS IoT Greengrass Eseguire il seguente comando per individuare l'installazione di Python:

which python3Eseguire il comando seguente per creare il collegamento simbolico.

sudo ln -spath-to-python-3.6/python3.6path-to-python-3.7/python3.7Riavviare il dispositivo.

-

Assicurati che l'account di

ggc_usersistema possa utilizzare il framework: MXNet“sudo -u ggc_user bash -c 'python3 -c "import mxnet"' -

Modifica la configurazione della funzione Lambda. Segui la procedura riportata in Fase 5: Aggiungere la funzione Lambda al gruppo Greengrass.

Nota

Ti consigliamo di eseguire la funzione Lambda senza containerizzazione, a meno che il tuo business case non lo richieda. Ciò consente l'accesso alla GPU e alla fotocamera del dispositivo senza configurare le risorse del dispositivo. Se esegui senza containerizzazione, devi anche concedere l'accesso root alle tue funzioni Lambda AWS IoT Greengrass .

-

Per eseguire senza containerizzazione:

-

Per Utente e gruppo di sistema, scegli.

Another user ID/group IDPer ID utente di sistema, immettere0. Per ID del gruppo di sistema, immettere0.Ciò consente alla funzione Lambda di funzionare come root. Per ulteriori informazioni sull'esecuzione come root, consultaImpostazione dell'identità di accesso predefinita per le funzioni Lambda in un gruppo.

Suggerimento

È inoltre necessario aggiornare il

config.jsonfile per concedere l'accesso root alla funzione Lambda. Per la procedura, vediEsecuzione di una funzione Lambda come utente root. -

Per la containerizzazione della funzione Lambda, scegli Nessun contenitore.

Per ulteriori informazioni sull'esecuzione senza containerizzazione, consulta. Considerazioni sulla scelta della containerizzazione delle funzioni Lambda

-

In Parametri aggiuntivi, per Accesso in lettura alla directory /sys, scegli Abilitato.

-

In Variabili di ambiente, aggiungi le seguenti coppie chiave-valore alla tua funzione Lambda. Questo configura l'utilizzo del framework AWS IoT Greengrass . MXNet

Chiave

Valore

PATH

/usr/local/cuda/bin: $PATH

MXNET_HOME

$HOME/mxnet/

PYTHONPATH

$MXNET_HOME/python:$PYTHONPATH

CUDA_HOME

/usr/local/cuda

LD_LIBRARY_PATH

$LD_LIBRARY_PATH:${CUDA_HOME}/lib64

-

-

Per eseguire invece in modalità containerizzata:

Nota

Si sconsiglia l'esecuzione in modalità containerizzata a meno che il business case non lo richieda.

-

Aumenta il valore di Memory limit (Limite memoria). Utilizzare 500 MB per la CPU o almeno 2000 MB per la GPU.

-

In Parametri aggiuntivi, per Accesso in lettura alla directory /sys, scegli Abilitato.

-

In Variabili di ambiente, aggiungi le seguenti coppie chiave-valore alla tua funzione Lambda. Questo configura l'utilizzo del framework AWS IoT Greengrass . MXNet

Chiave

Valore

PATH

/usr/local/cuda/bin: $PATH

MXNET_HOME

$HOME/mxnet/

PYTHONPATH

$MXNET_HOME/python:$PYTHONPATH

CUDA_HOME

/usr/local/cuda

LD_LIBRARY_PATH

$LD_LIBRARY_PATH:${CUDA_HOME}/lib64

-

-

-

Se è in esecuzione in modalità containerizzata, aggiungi le seguenti risorse del dispositivo locale per concedere l'accesso alla GPU del dispositivo. Segui la procedura riportata in Fase 6: aggiunta di risorse al gruppo Greengrass.

Nota

Se esegui in modalità non containerizzata, AWS IoT Greengrass puoi accedere alla GPU del dispositivo senza configurare le risorse del dispositivo.

Per ogni risorsa:

-

Per Resource type (Tipo di risorsa), scegli Device (Dispositivo).

-

Per il proprietario del gruppo di sistema e le autorizzazioni di accesso ai file, scegli Aggiungi automaticamente le autorizzazioni del file system del gruppo di sistema proprietario della risorsa.

Nome

Percorso dispositivo

nvhost-ctrl

/dev/nvhost-ctrl

nvhost-gpu

/dev/nvhost-gpu

nvhost-ctrl-gpu

/dev/ nvhost-ctrl-gpu

nvhost-dbg-gpu

/dev/ nvhost-dbg-gpu

nvhost-prof-gpu

/dev/ nvhost-prof-gpu

nvmap

/dev/nvmap

nvhost-vic

/dev/nvhost-vic

tegra_dc_ctrl

/dev/tegra_dc_ctrl

-

-

Se è in esecuzione in modalità containerizzata, aggiungi la seguente risorsa di volume locale per concedere l'accesso alla fotocamera del tuo dispositivo. Segui la procedura riportata in Fase 6: aggiunta di risorse al gruppo Greengrass.

Nota

Se si esegue in modalità non containerizzata, è AWS IoT Greengrass possibile accedere alla fotocamera del dispositivo senza configurare le risorse di volume.

-

Per Resource type (Tipo di risorsa), scegli Volume.

-

Per il proprietario del gruppo di sistema e le autorizzazioni di accesso ai file, scegli Aggiungi automaticamente le autorizzazioni del file system del gruppo di sistema proprietario della risorsa.

Nome

Percorso di origine

Percorso di destinazione

shm

/dev/shm

/dev/shm

tmp

/tmp

/tmp

-