기계 번역으로 제공되는 번역입니다. 제공된 번역과 원본 영어의 내용이 상충하는 경우에는 영어 버전이 우선합니다.

솔루션 개요

확장 가능한 ML 프레임워크

여러 사업 분야에 수백만 명의 고객이 분산되어 있는 비즈니스에서 ML 워크플로를 활용하려면 다양한 도구를 사용하여 사일로화된 팀이 소유하고 관리하는 데이터를 통합하여 비즈니스 가치를 실현해야 합니다. 은행은 고객의 데이터를 보호하기 위해 최선을 다하고 있습니다. 마찬가지로 ML 모델 개발에 사용되는 인프라에도 엄격한 보안 표준이 적용됩니다. 이러한 추가 보안은 복잡성을 더욱 가중시키고 새로운 ML 모델의 가치 실현 시간에 영향을 미칩니다. 확장 가능한 ML 프레임워크에서는 현대화되고 표준화된 도구 세트를 사용하여 다양한 도구를 결합하는 데 필요한 노력을 줄이고 새로운 ML 모델의 RTL(Route To Live) 프로세스를 간소화할 수 있습니다.

전통적으로 FS 업계에서 데이터 과학 활동의 관리 및 지원은 조직 전체의 데이터 팀을 위한 요구 사항을 수집하고, 리소스를 프로비저닝하고, 인프라를 유지 관리하는 중앙 플랫폼 팀에 의해 제어됩니다. 조직 전체의 페더레이션 팀에서 ML 사용을 빠르게 확장하려면 확장 가능한 ML 프레임워크를 사용하여 새로운 모델 및 파이프라인 개발자에게 셀프 서비스 기능을 제공합니다. 이를 통해 개발자는 사전 승인되고 표준화된 최신 보안 인프라를 배포할 수 있습니다. 궁극적으로 이러한 셀프 서비스 기능은 중앙 집중식 플랫폼 팀에 대한 조직의 의존도를 줄이고 ML 모델 개발의 가치 실현 시간을 단축합니다.

확장 가능한 ML 프레임워크를 통해 데이터 사이언티스트 또는 ML 엔지니어 등의 데이터 소비자는 다음을 수행하여 비즈니스 가치를 실현할 수 있습니다.

모델 훈련에 필요한 사전 승인된 데이터 탐색 및 검색

사전 승인된 데이터에 빠르고 쉽게 액세스

사전 승인된 데이터를 사용하여 모델 실행 가능성 입증

검증된 모델을 다른 사용자가 사용할 수 있도록 실운영 환경에 공개

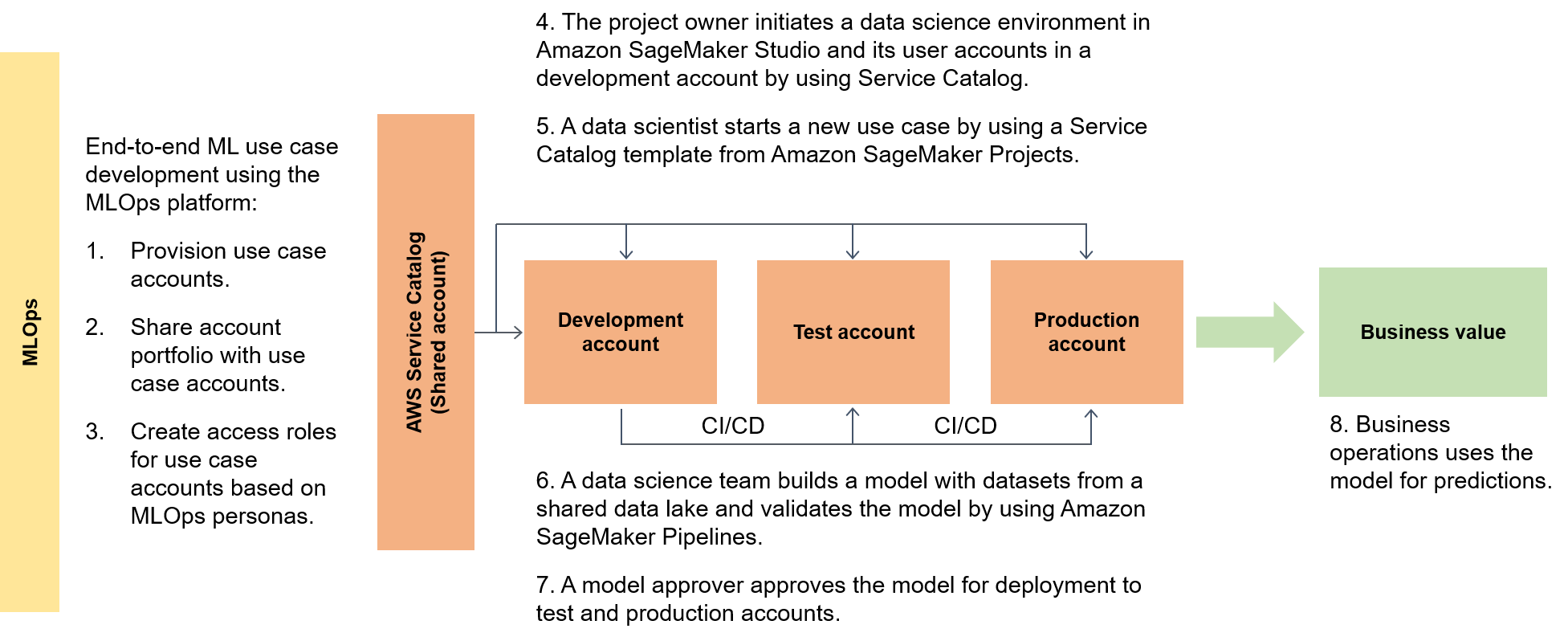

다음 다이어그램에서는 프레임워크의 엔드 투 엔드 흐름과 ML 사용 사례의 간소화된 RTL(Route To Live)을 보여줍니다.

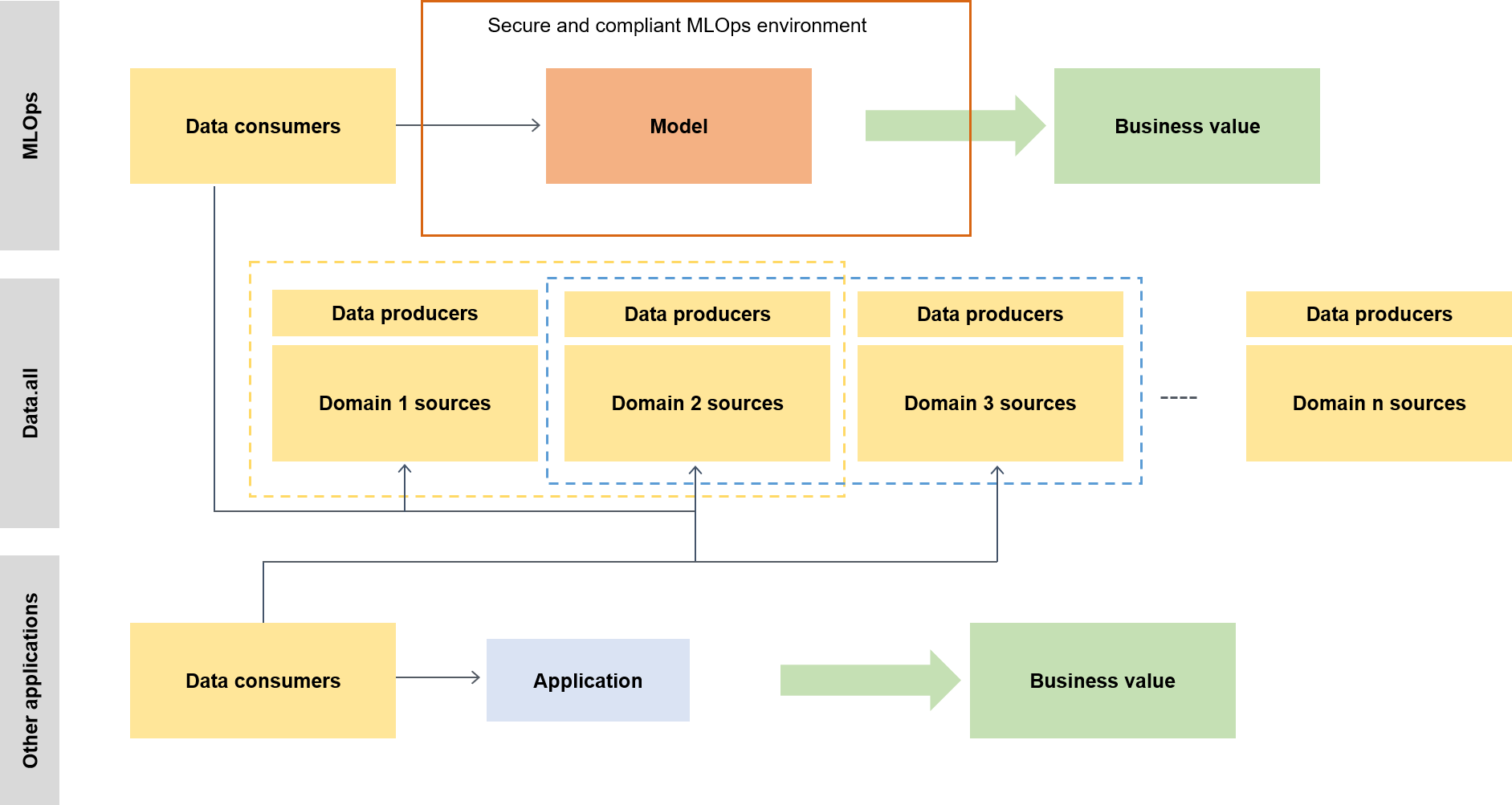

넓은 맥락에서 보면 데이터 소비자는 다음 다이어그램과 같이 data.all이라는 서버리스 액셀러레이터를 사용하여 여러 데이터 레이크에 걸쳐 데이터를 소싱한 다음 데이터를 사용하여 모델을 훈련합니다.

하위 수준에서 확장 가능한 ML 프레임워크에는 다음이 포함됩니다.

셀프 서비스 인프라 배포 - 중앙 팀에 대한 의존도를 줄이세요.

Central Python 패키지 관리 시스템 - 사전 승인된 Python 패키지를 모델 개발에 사용할 수 있게 하세요.

모델 개발 및 프로모션을 위한 CI/CD 파이프라인 - 지속적 통합 및 지속적 전달(CI/CD) 파이프라인을 코드형 인프라(IaC) 템플릿의 일부로 포함시켜 TTL(Time To Live)을 줄이세요.

모델 테스트 기능 - 새 모델에 자동으로 제공되는 단위 테스트, 모델 테스트, 통합 테스트 및 엔드 투 엔드 테스트 기능을 활용하세요.

모델 디커플링 및 오케스트레이션 - Amazon SageMaker AI Pipelines

을 사용하여 다양한 단계의 컴퓨팅 리소스 요구 사항 및 오케스트레이션에 따라 모델 단계를 디커플링하여 불필요한 컴퓨팅을 방지하고 배포를 더 견고하게 만듭니다. 코드 표준화 - PEP 8(Python Enhancement Proposal) 표준

검증에 CI/CD 파이프라인 통합을 사용하여 코드 품질을 높이세요. 빠른 시작 일반 ML 템플릿 - 배포에 SageMaker AI 프로젝트를 사용하여 버튼을 클릭하여 ML 모델링 환경(개발, 사전 프로덕션 및 프로덕션) 및 관련 파이프라인을 인스턴스화하는 Service Catalog 템플릿을 가져옵니다.

데이터 및 모델 품질 모니터링 - Amazon SageMaker AI 모델 모니터를 사용하여 데이터 및 모델 품질의 드리프트를 자동으로 모니터링하여 모델이 운영 요구 사항 및 위험 허용 범위 내에서 작동하는지 확인합니다.

바이어스 모니터링 – 모델 소유자가 데이터 불균형을 자동으로 확인하고 세상의 변화로 인해 모델에 바이어스가 생겼는지 여부를 확인하여 공정하고 공평한 결정을 내릴 수 있도록 하세요.

메타데이터의 중앙 허브

data.all

SageMaker 검증

다양한 데이터 처리 및 ML 아키텍처에서 SageMaker AI의 기능을 입증하기 위해 기능을 구현하는 팀은 은행 리더십 팀과 함께 다양한 은행 고객 부문의 복잡성이 다양한 사용 사례를 선택합니다. 사용 사례 데이터는 난독화되어 기능 입증 단계를 위해 사용 사례 개발 계정의 로컬 Amazon Simple Storage Service(Amazon S3)

원래 훈련 환경에서 SageMaker AI 아키텍처로 모델 마이그레이션이 완료되면 클라우드 호스팅 데이터 레이크를 통해 프로덕션 모델에서 데이터를 읽을 수 있습니다. 그런 다음 프로덕션 모델에서 생성된 예측이 데이터 레이크에 다시 기록됩니다.

후보 사용 사례가 마이그레이션된 후 확장 가능한 ML 프레임워크는 대상 지표에 대한 초기 기준을 사용합니다. 확장 가능한 ML 프레임워크를 통해 가능한 시간 개선의 증거로 이전 온프레미스 또는 기타 클라우드 제공업체 타이밍과 기준을 비교할 수 있습니다.