As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Padrão de roteamento de caminhos

O roteamento por caminhos é o mecanismo de agrupar vários ou todos APIs sob o mesmo nome de host e usar um URI de solicitação para isolar serviços; por exemplo, ou. api.example.com/service-a api.example.com/service-b

Caso de uso típico

A maioria das equipes opta por esse método porque deseja uma arquitetura simples — um desenvolvedor precisa se lembrar de apenas uma URL, como api.example.com, para interagir com a API HTTP. A documentação da API geralmente é mais fácil de digerir porque geralmente é mantida unida em vez de ser dividida em diferentes portais ou. PDFs

O roteamento com base no caminho é considerado um mecanismo simples para compartilhar uma API HTTP. No entanto, envolve sobrecarga operacional, como configuração, autorização, integrações e latência adicional devido a vários saltos. Também requer processos maduros de gerenciamento de mudanças para garantir que uma configuração incorreta não interrompa todos os serviços.

AWS Ativado, há várias maneiras de compartilhar uma API e rotear de forma eficaz para o serviço correto. As seções a seguir abordam três abordagens: proxy reverso do serviço HTTP, API Gateway e Amazon CloudFront. Nenhuma das abordagens sugeridas para unificar os serviços de API depende dos serviços posteriores em execução no AWS. Os serviços podem ser executados em qualquer lugar sem problemas ou com qualquer tecnologia, desde que sejam compatíveis com HTTP.

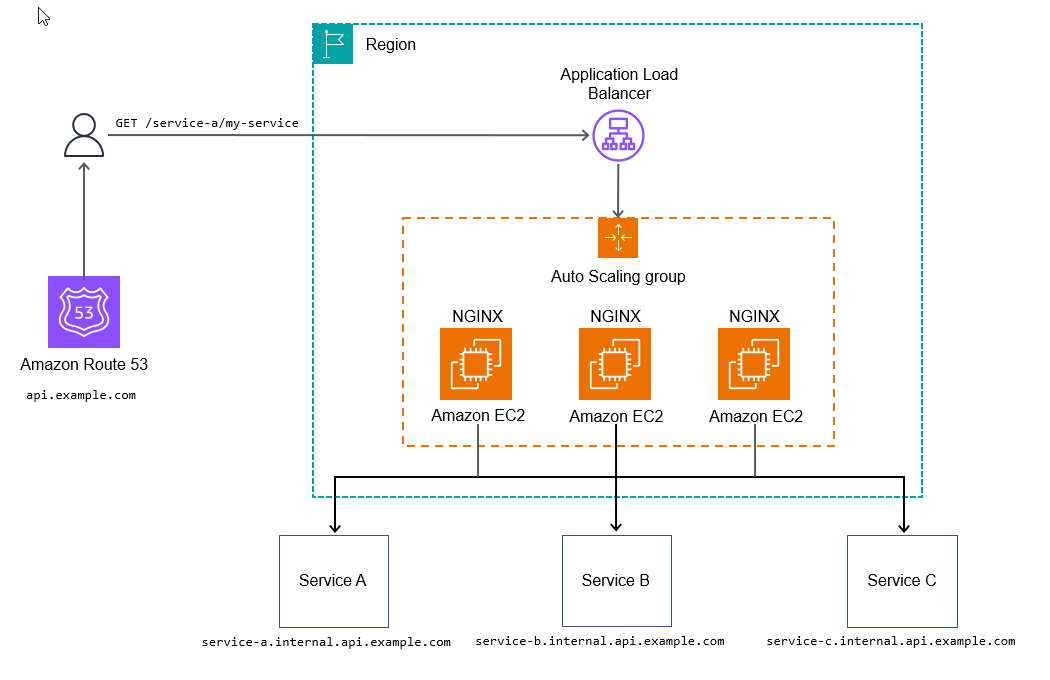

Proxy reverso de serviço HTTP

Você pode usar um servidor HTTP, como o NGINX

A configuração a seguir para o NGINX mapeia dinamicamente uma solicitação HTTP de api.example.com/my-service/ para my-service.internal.api.example.com.

server { listen 80; location (^/[\w-]+)/(.*) { proxy_pass $scheme://$1.internal.api.example.com/$2; } }

O diagrama a seguir ilustra o método de proxy reverso de serviço HTTP.

Essa abordagem pode ser suficiente para alguns casos de uso que não usam configurações adicionais para iniciar o processamento de solicitações, permitindo que a API posterior colete métricas e registros.

Para se preparar para a prontidão de produção operacional, você deve poder adicionar observabilidade para todos os níveis de sua pilha, adicionar configurações adicionais ou adicionar scripts para personalizar seu ponto de entrada de API para permitir atributos mais avançados, como limitação de taxa ou tokens de uso.

Prós

O objetivo final do método de proxy reverso do serviço HTTP é criar uma abordagem escalável e gerenciável para unificação APIs em um único domínio, de forma que pareça coerente para qualquer consumidor de API. Essa abordagem também permite que suas equipes de serviço implantem e gerenciem suas próprias equipes APIs, com o mínimo de sobrecarga após a implantação. AWS serviços gerenciados para rastreamento, como AWS X-Ray

Contras

A principal desvantagem dessa abordagem são os testes e o gerenciamento extensivos dos componentes de infraestrutura necessários, embora isso possa não ser um problema se você tiver equipes de engenharia de confiabilidade de sites (SRE) instaladas.

Há um ponto de inflexão de custos com esse método. Em volumes baixos a médios, ele é mais caro do que alguns dos outros métodos discutidos neste guia. Em grandes volumes, é muito econômico (cerca de 100 mil transações por segundo ou mais).

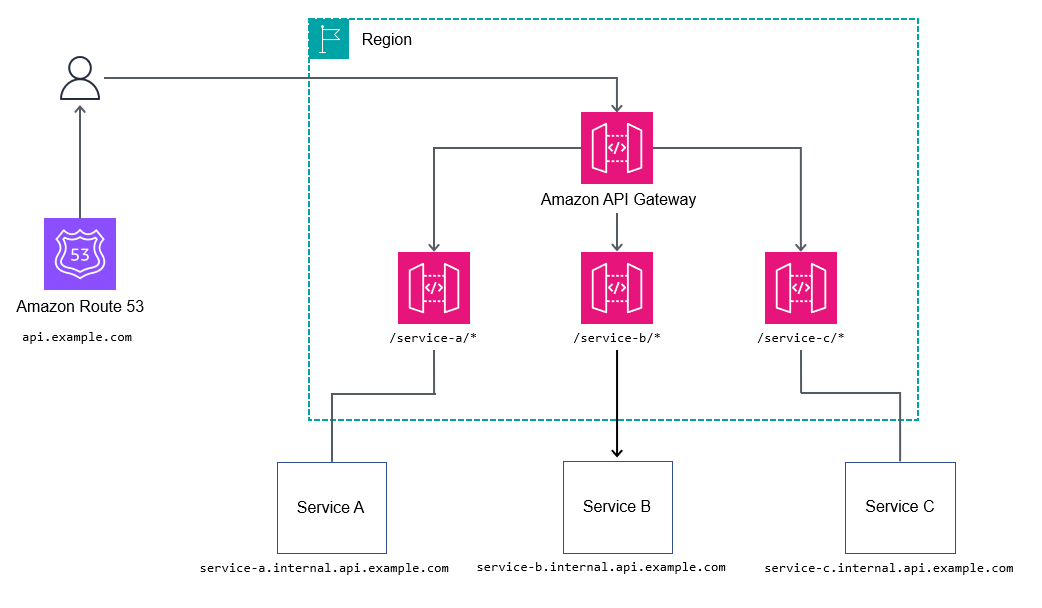

API Gateway

O serviço Amazon API Gatewayapi.example.com e, em seguida, solicitações de proxy para o serviço aninhado; por exemplo, billing.internal.api.example.com.

Provavelmente não é uma boa ideia ser muito granular mapeando todos os caminhos em todos os serviços no gateway de API raiz ou principal. Em vez disso, opte por caminhos curinga, como o /billing/*, para encaminhar solicitações para o serviço de cobrança. Ao não mapear todos os caminhos no gateway de API raiz ou principal, você ganha mais flexibilidade em relação ao seu APIs, porque não precisa atualizar o gateway da API raiz a cada alteração da API.

Prós

Para controlar fluxos de trabalho mais complexos, como alterar os atributos da solicitação, o REST APIs expõe a Apache Velocity Template Language (VTL) para permitir que você modifique a solicitação e a resposta. O REST APIs pode fornecer benefícios adicionais, como estes:

-

Autenticação N/Z com AWS Identity and Access Management (IAM), Amazon Cognito ou autorizadores AWS Lambda

-

Tokens de uso para agrupar consumidores em diferentes níveis (consulte Acelerar solicitações de API para obter melhor throughput na documentação do API Gateway)

Contras

Em grandes volumes, o custo pode ser um problema para alguns usuários.

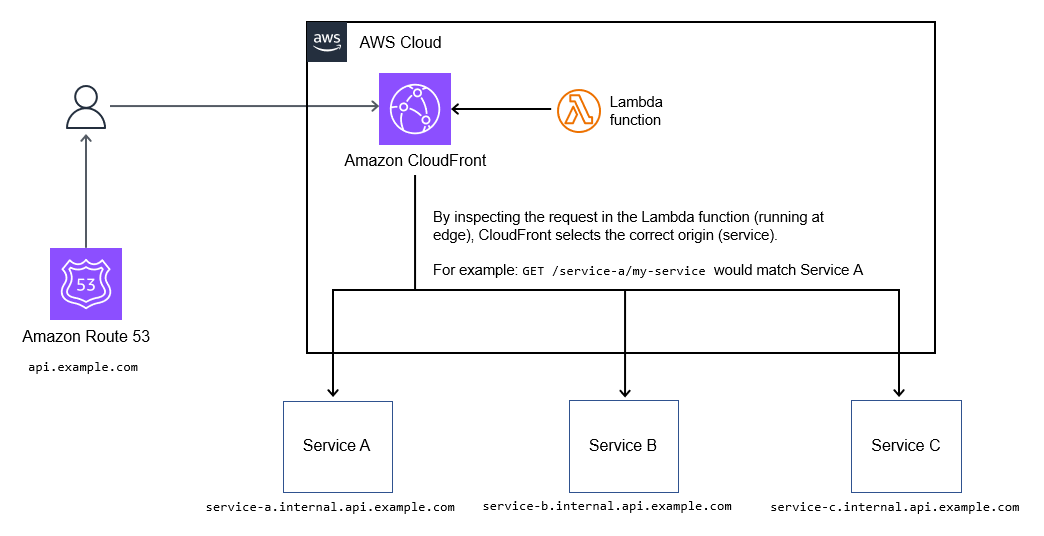

CloudFront

Você pode usar o recurso de seleção dinâmica de origem na Amazon CloudFrontapi.example.com.

Caso de uso típico

A lógica de roteamento vive como código dentro da função Lambda @Edge, portanto, ela oferece suporte a mecanismos de roteamento altamente personalizáveis, A/B como testes, lançamentos canários, sinalização de recursos e reescrita de caminhos. Isso é ilustrado no diagrama a seguir.

Prós

Se você precisa armazenar em cache as respostas da API, esse método é uma boa maneira de unificar uma coleção de serviços em um único endpoint. É um método econômico para unificar coleções de. APIs

Além disso, CloudFront suporta criptografia em nível de campo, bem como integração com AWS WAF para limitação de taxa básica e básica. ACLs

Contras

Esse método suporta no máximo 250 origens (serviços) que podem ser unificadas. Esse limite é suficiente para a maioria das implantações, mas pode causar problemas em um grande número de implantações APIs à medida que você aumenta seu portfólio de serviços.

Atualmente, a atualização das funções do Lambda @Edge leva alguns minutos. CloudFront também leva até 30 minutos para concluir a propagação das alterações em todos os pontos de presença. Em última análise, isso bloqueia novas atualizações até que elas sejam concluídas.