Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Solución de problemas: operadores DAGs, conexiones y otros problemas en Apache Airflow v1

Los temas de esta página contienen soluciones a las dependencias de Python de Apache Airflow v1.10.12, los complementos personalizados, los operadores, las conexiones DAGs, las tareas y los problemas del servidor web que puede encontrar en un entorno de Amazon Managed Workflows para Apache Airflow.

Contenido

He recibido un mensaje de error “Broken DAG” al utilizar los operadores de Amazon DynamoDB

He recibido el mensaje de error “Broken DAG: No module named psycopg2”

He recibido el mensaje de error “Broken DAG” al usar los operadores de Slack

He recibido varios errores de instalación Google/GCP/BigQuery

He recibido el mensaje de error “Broken DAG: No module named Cython”.

Actualización de requirements.txt

En el siguiente tema se describen los errores que puede encontrar al actualizar su requirements.txt.

Al agregar apache-airflow-providers-amazon, se produce un error en mi entorno

apache-airflow-providers- solo es compatible con Apache Airflow v2. xyzapache-airflow-backport-providers- es compatible con Apache Airflow 1.10.12.xyz

DAG roto

En el siguiente tema se describen los errores que se pueden producir al ejecutar DAGs.

He recibido un mensaje de error “Broken DAG” al utilizar los operadores de Amazon DynamoDB

Recomendamos los siguientes pasos:

-

Pruebe sus DAGs complementos personalizados y sus dependencias de Python de forma local con la función aws-mwaa-local-runner

on GitHub. -

Agregue el paquete siguiente a su

requirements.txt.boto -

Explore las formas de especificar las dependencias de Python en un

requirements.txtarchivo, consulte. Administración de las dependencias de Python en requirements.txt

He recibido el mensaje de error “Broken DAG: No module named psycopg2”

Recomendamos los siguientes pasos:

-

Pruebe sus DAGs complementos personalizados y sus dependencias de Python de forma local con la función aws-mwaa-local-runner

on GitHub. -

Agregue lo siguiente a su

requirements.txtcon su versión de Apache Airflow. Por ejemplo:apache-airflow[postgres]==1.10.12 -

Explore las formas de especificar las dependencias de Python en un

requirements.txtarchivo, consulte. Administración de las dependencias de Python en requirements.txt

He recibido el mensaje de error “Broken DAG” al usar los operadores de Slack

Recomendamos los siguientes pasos:

-

Pruebe sus DAGs complementos personalizados y sus dependencias de Python de forma local con la función aws-mwaa-local-runner

on GitHub. -

Agregue el paquete siguiente a su

requirements.txty especifique su versión de Apache Airflow. Por ejemplo:apache-airflow[slack]==1.10.12 -

Explore las formas de especificar las dependencias de Python en un

requirements.txtarchivo, consulte. Administración de las dependencias de Python en requirements.txt

He recibido varios errores de instalación Google/GCP/BigQuery

Amazon MWAA utiliza Amazon Linux, que requiere una versión específica de Cython y bibliotecas de criptografía. Recomendamos los siguientes pasos:

-

Pruebe sus DAGs complementos personalizados y sus dependencias de Python de forma local con la función aws-mwaa-local-runner

on GitHub. -

Agregue el paquete siguiente a su

requirements.txt.grpcio==1.27.2 cython==0.29.21 pandas-gbq==0.13.3 cryptography==3.3.2 apache-airflow-backport-providers-amazon[google] -

Si no utiliza proveedores de backport, puede usar:

grpcio==1.27.2 cython==0.29.21 pandas-gbq==0.13.3 cryptography==3.3.2 apache-airflow[gcp]==1.10.12 -

Explore las formas de especificar las dependencias de Python en un

requirements.txtarchivo, consulte. Administración de las dependencias de Python en requirements.txt

He recibido el mensaje de error “Broken DAG: No module named Cython”.

Amazon MWAA utiliza Amazon Linux, que requiere una versión específica de Cython. Recomendamos los siguientes pasos:

-

Pruebe sus DAGs complementos personalizados y sus dependencias de Python de forma local con la función aws-mwaa-local-runner

on GitHub. -

Agregue el paquete siguiente a su

requirements.txt.cython==0.29.21 -

Las bibliotecas de Cython requieren varias versiones de dependencia de pip. Por ejemplo, el uso de

awswrangler==2.4.0requierepyarrow<3.1.0,>=2.0.0, por lo que pip3 intenta instalarpyarrow==3.0.0, lo que provoca un error “Broken DAG”. Recomendamos especificar la versión más antigua aceptable de forma explícita. Por ejemplo, si especifica el valor mínimopyarrow==2.0.0antes deawswrangler==2.4.0, entonces el error desaparece yrequirements.txtse instala correctamente. Los requisitos finales deben tener el siguiente aspecto:cython==0.29.21 pyarrow==2.0.0 awswrangler==2.4.0 -

Explore las formas de especificar las dependencias de Python en un

requirements.txtarchivo, consulte. Administración de las dependencias de Python en requirements.txt

Operadores

En el siguiente tema se describen los errores que se pueden producir al utilizar operadores.

He recibido un error al utilizar el operador BigQuery

Amazon MWAA no admite operadores con extensiones de interfaz de usuario. Recomendamos los siguientes pasos:

-

Pruebe sus DAGs complementos personalizados y sus dependencias de Python de forma local con la función aws-mwaa-local-runner

on GitHub. -

Una solución alternativa consiste en anular la extensión añadiendo una línea en el DAG para configurar

<operator name>.operator_extra_links = Nonedespués de importar los operadores problemáticos. Por ejemplo:from airflow.contrib.operators.bigquery_operator import BigQueryOperator BigQueryOperator.operator_extra_links = None -

Puedes usar este enfoque para todos DAGs agregando lo anterior a un complemento. Para ver un ejemplo, consulteCreación de un complemento personalizado para Apache Airflow PythonVirtualenvOperator.

Connections

En el siguiente tema se describen los errores que puede recibir al utilizar una conexión de Apache Airflow o al utilizar otra AWS base de datos.

No puedo conectarme a Snowflake

Recomendamos los siguientes pasos:

-

Pruebe sus DAGs complementos personalizados y sus dependencias de Python de forma local con la función aws-mwaa-local-runner

on GitHub. -

Agregue las siguientes entradas al archivo requirements.txt de su entorno.

asn1crypto == 0.24.0 snowflake-connector-python == 1.7.2 -

Añada las siguientes importaciones al DAG:

from airflow.contrib.hooks.snowflake_hook import SnowflakeHook from airflow.contrib.operators.snowflake_operator import SnowflakeOperator

Asegúrese de que el objeto de conexión de Apache Airflow incluya los siguientes pares clave-valor:

-

ID de conexión: snowflake_conn

-

Tipo de conexión: Snowflake

-

Host: <my account> <my region if not us-west-2>.snowflakecomputing.com

-

Esquema: <my schema>

-

Inicio de sesión: <my user name>

-

Contraseña: ********

-

Puerto: <port, if any>

-

Extra:

{ "account": "<my account>", "warehouse": "<my warehouse>", "database": "<my database>", "region": "<my region if not using us-west-2 otherwise omit this line>" }

Por ejemplo:

>>> import json >>> from airflow.models.connection import Connection >>> myconn = Connection( ... conn_id='snowflake_conn', ... conn_type='Snowflake', ... host='123456789012.us-east-1.snowflakecomputing.com', ... schema='YOUR_SCHEMA' ... login='YOUR_USERNAME', ... password='YOUR_PASSWORD', ... port='YOUR_PORT' ... extra=json.dumps(dict(account='123456789012', warehouse='YOUR_WAREHOUSE', database='YOUR_DB_OPTION', region='us-east-1')), ... )

No puedo conectarme a Secrets Manager

Recomendamos los siguientes pasos:

-

Aprenda a crear claves secretas para su conexión y variables de Apache Airflow en Configuración de una conexión de Apache Airflow mediante un secreto AWS Secrets Manager.

-

Aprenda a usar la clave secreta para una variable de Apache Airflow (

test-variable) en Uso de una clave secreta AWS Secrets Manager para una variable de Apache Airflow. -

Aprenda a usar la clave secreta para una conexión de Apache Airflow (

myconn) en Uso de una clave secreta AWS Secrets Manager para una conexión de Apache Airflow.

No puedo conectarme a mi servidor MySQL en “<DB-identifier-name>.cluster-id. <region>.rds.amazonaws.com”.

El grupo de seguridad de Amazon MWAA y el grupo de seguridad de RDS necesitan una regla de entrada para permitir que el tráfico entre sí y entre ellos. Recomendamos los siguientes pasos:

-

Modifique el grupo de seguridad de RDS para permitir todo el tráfico del grupo de seguridad de VPC de Amazon MWAA.

-

Modifique el grupo de seguridad de VPC de Amazon MWAA para permitir todo el tráfico procedente del grupo de seguridad de RDS.

-

Vuelva a ejecutar las tareas y compruebe si la consulta SQL se ha realizado correctamente comprobando los registros de Apache Airflow en los registros CloudWatch .

Servidor web

En el siguiente tema se describen los errores que puede encontrar en su servidor web Apache Airflow en Amazon MWAA.

Estoy usando el BigQueryOperator y eso está provocando que mi servidor web se bloquee

Recomendamos los siguientes pasos:

-

Los operadores de Apache Airflow, como

BigQueryOperatoryQuboleOperator, que contienenoperator_extra_links, podrían provocar que su servidor web Apache Airflow se bloquee. Estos operadores intentan cargar código en su servidor web, lo que no está permitido por motivos de seguridad. Le recomendamos que aplique parches a los operadores en su DAG añadiendo el siguiente código después de las instrucciones de importación:BigQueryOperator.operator_extra_links = None -

Pruebe sus DAGs complementos personalizados y sus dependencias de Python de forma local con la función aws-mwaa-local-runner

on GitHub.

Aparece un error 5xx al acceder al servidor web

Recomendamos los siguientes pasos:

-

Compruebe las opciones de configuración de Apache Airflow. Compruebe que los pares clave-valor que especificó como opción de configuración de Apache Airflow, por ejemplo, se hayan configurado AWS Secrets Manager correctamente. Para obtener más información, consulte. No puedo conectarme a Secrets Manager

-

Compruebe los

requirements.txt. Compruebe que el paquete “extras” de Airflow y las demás bibliotecas que figuran en surequirements.txtsean compatibles con su versión de Apache Airflow. -

Explore las formas de especificar las dependencias de Python en un

requirements.txtarchivo, consulte. Administración de las dependencias de Python en requirements.txt

Aparece el mensaje de error “The scheduler does not appear to be running”

Si parece que el programador no se está ejecutando o el último «latido» se recibió hace varias horas, es DAGs posible que no aparezcas en Apache Airflow y no se programarán nuevas tareas.

Recomendamos los siguientes pasos:

-

Confirme que su grupo de seguridad de VPC permita el acceso entrante al puerto

5432. Este puerto es necesario para conectarse a la base de datos de metadatos de PostgreSQL de Amazon Aurora de su entorno. Tras añadir esta regla, dé unos minutos a Amazon MWAA y el error desaparecerá. Para obtener más información, consulte. Seguridad en la VPC en Amazon MWAAnota

-

La base de metadatos de Aurora PostgreSQL forma parte de la arquitectura de servicios de Amazon MWAA y no está visible en la suya. Cuenta de AWS

-

Los errores relacionados con la base de datos suelen ser síntoma de un fallo del programador, no su causa principal.

-

-

Si el programador no se está ejecutando, podría deberse a varios factores, como errores en la instalación de las dependencias o a una sobrecarga del programador. Compruebe que sus DAGs complementos y requisitos funcionan correctamente consultando los grupos de registros correspondientes en Logs. CloudWatch Para obtener más información, consultaMonitorización y métricas de Amazon Managed Workflows para Apache Airflow.

Tareas

En el siguiente tema se describen los errores que puede encontrar al realizar tareas de Apache Airflow en un entorno.

Veo que mis tareas están bloqueadas o no se están completando

Si sus tareas de Apache Airflow están “bloqueadas” o no se completan, le recomendamos que siga los siguientes pasos:

-

Es posible que haya un gran número de DAGs definiciones. Reduzca el número DAGs y actualice el entorno (por ejemplo, cambiando el nivel de registro) para forzar el restablecimiento.

-

Airflow analiza DAGs si están activados o no. Si utiliza más del 50 % de la capacidad de su entorno, puede que el programador de Apache Airflow empiece a sobrecargarse. Esto se traduce en un mayor tiempo total de análisis en CloudWatch las métricas o en tiempos de procesamiento del DAG prolongados en CloudWatch los registros. Hay otras formas de optimizar las configuraciones de Apache Airflow que no se tratan en esta guía.

-

Para obtener más información sobre las prácticas recomendadas que recomendamos para ajustar el rendimiento de su entorno, consulteAjuste del desempeño de Apache Airflow en Amazon MWAA.

-

-

Es posible que haya una gran cantidad de tareas en la cola. Esto suele aparecer como un número elevado (y creciente) de tareas en el estado «Ninguna», o como un número elevado de tareas en cola (tareas pendientes). and/or CloudWatch Esto puede producirse por varias razones:

-

Si hay más tareas que ejecutar de las que el entorno tiene capacidad para ejecutar, and/or una gran cantidad de tareas que estaban en cola antes del escalado automático tienen tiempo de detectarlas y desplegar más trabajadores.

-

Si hay más tareas que ejecutar de las que un entorno tiene capacidad para ejecutar, se recomienda reducir la cantidad de tareas que se DAGs ejecutan simultáneamente y and/or aumentar el número mínimo de trabajadores de Apache Airflow.

-

Si hay un gran número de tareas en cola antes de que el escalado automático haya tenido tiempo de detectar y desplegar más trabajadores, recomendamos escalonar el despliegue de tareas y and/or aumentar el número mínimo de trabajadores de Apache Airflow.

-

Puede usar el comando update-environment en AWS Command Line Interface (AWS CLI) para cambiar la cantidad mínima o máxima de trabajadores que se ejecutan en su entorno.

aws mwaa update-environment --name MyEnvironmentName --min-workers 2 --max-workers 10 -

Para obtener más información sobre las prácticas recomendadas que recomendamos para ajustar el rendimiento de su entorno, consulte. Ajuste del desempeño de Apache Airflow en Amazon MWAA

-

-

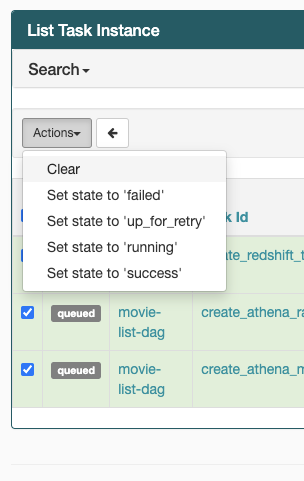

Si sus tareas están bloqueadas en el estado “en ejecución”, también puede borrarlas o marcarlas como ejecutadas o fallidas. Esto permite que el componente de escalado automático de su entorno reduzca verticalmente la cantidad de procesos de trabajo que trabajan en su entorno. En la siguiente imagen se muestra un ejemplo de tarea pendiente.

-

Elija el círculo para la tarea pendiente y, a continuación, seleccione Borrar como se muestra. Esto permite a Amazon MWAA reducir el número de trabajadores; de lo contrario, Amazon MWAA no puede determinar cuáles DAGs están habilitados o deshabilitados, y no puede reducir la plantilla si todavía hay tareas en cola.

-

-

Para más información sobre el ciclo de vida de las tareas de Apache Airflow en Conceptos

, consulte la guía de referencia de Apache Airflow.

CLI

En el siguiente tema se describen los errores que puede haber al ejecutar los comandos de la CLI de Airflow en AWS Command Line Interface.

Veo un error 503 al activar un DAG en la CLI

La CLI de Airflow se ejecuta en el servidor web de Apache Airflow, que tiene una simultaneidad limitada. Por lo general, se pueden ejecutar un máximo de 4 comandos de CLI simultáneamente.