Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Replicar bases de datos de unidades centrales en AWS mediante Precisely Connect

Creado por Lucio Pereira (AWS), Balaji Mohan (AWS) y Sayantan Giri (AWS)

Resumen

Este patrón describe los pasos para replicar datos de bases de datos de unidades centrales a los almacenes de datos de Amazon casi en tiempo real mediante Precisely Connect. El patrón implementa una arquitectura basada en eventos con Amazon Managed Streaming para Apache Kafka (Amazon MSK) y conectores de bases de datos personalizados en la nube para mejorar la escalabilidad, la resiliencia y el rendimiento.

Precisely Connect es una herramienta de replicación que captura datos de sistemas de unidades centrales heredados y los integra en entornos en la nube. Los datos se replican desde las unidades centrales a AWS mediante la captura de datos de cambios (CDC) mediante flujos de mensajes prácticamente en tiempo real con canalizaciones de datos heterogéneas de baja latencia y alto rendimiento.

Este patrón también abarca una estrategia de recuperación de desastres para canalizaciones de datos resilientes con replicación de datos multirregional y enrutamiento de conmutación por error.

Requisitos previos y limitaciones

Requisitos previos

Una base de datos de mainframe existente (por ejemplo, IBM DB2, IBM Information Management System (IMS) o Virtual Storage Access Method (VSAM), que desee replicar en la nube de AWS

Una cuenta de AWS

activa AWS Direct Connect

o red privada virtual de AWS (AWS VPN ) desde su entorno corporativo a AWS Una nube privada virtual

con una subred a la que pueda acceder su plataforma antigua

Arquitectura

Pila de tecnología de origen

Un entorno de unidad central que incluya al menos una de las siguientes bases de datos:

Base de datos IBM IMS

DB2 Base de datos de IBM

Archivos VSAM

Pila de tecnología de destino

Amazon MSK

Amazon Elastic Kubernetes Service (Amazon EKS) y Amazon EKS Anywhere

Docker

Una base de datos relacional o NoSQL de AWS como la siguiente:

Amazon DynamoDB

Amazon Relational Database Service (Amazon RDS) para Oracle, Amazon RDS para PostgreSQL o Amazon Aurora

Amazon ElastiCache para Redis

Amazon Keyspaces (para Apache Cassandra)

Arquitectura de destino

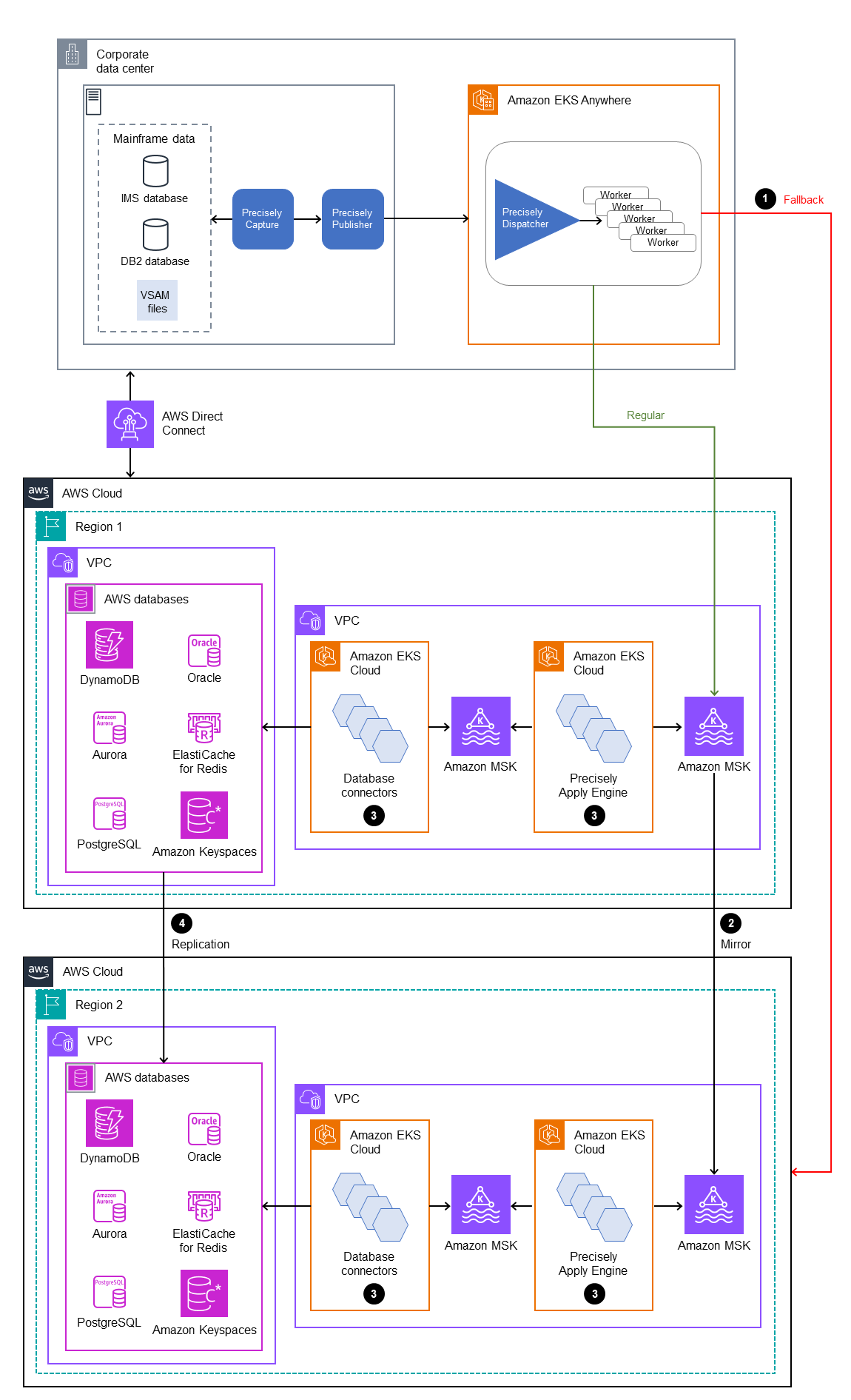

Replicación de datos de unidad central en bases de datos de AWS

El siguiente diagrama ilustra la replicación de datos de mainframe en una base de datos de AWS, como DynamoDB, Amazon RDS, Amazon o Amazon Keyspaces ElastiCache. La replicación se produce prácticamente en tiempo real mediante el uso de Precisely Capture y Publisher en su entorno de unidad central en las instalaciones, Precisely Dispatcher en Amazon EKS Anywhere en su entorno distribuido en las instalaciones y Precisely Apply Engine y los conectores de base de datos en la nube de AWS.

En el diagrama, se muestra el siguiente flujo de trabajo:

Precisely Capture obtiene los datos de unidad central de los registros CDC y los mantiene en un almacenamiento transitorio interno.

Precisely Publisher escucha los cambios en el almacenamiento de datos interno y envía los registros de los CDC a Precisely Dispatcher a través de una conexión TCP/IP.

Precisely Dispatcher recibe los registros de los CDC de Publisher y los envía a Amazon MSK. Dispatcher crea claves de Kafka en función de la configuración del usuario y de varias tareas de trabajo para enviar los datos en paralelo. Dispatcher envía un acuse de recibo a Publisher cuando los registros se han almacenado en Amazon MSK.

Amazon MSK guarda los registros de los CDC en el entorno de nube. El tamaño de las particiones de los temas depende de los requisitos de rendimiento del sistema de procesamiento de transacciones (TPS). La clave de Kafka es obligatoria para seguir ordenando transformaciones y transacciones.

Precisely Apply Engine escucha los registros de CDC de Amazon MSK y transforma los datos (por ejemplo, filtrándolos o mapeándolos) en función de los requisitos de la base de datos de destino. Puede añadir una lógica personalizada a los scripts de Precisely SQD. (SQD es el lenguaje propiedad de Precisely). Precisely Apply Engine transforma cada registro de CDC al formato Apache Avro o JSON y lo distribuye a diferentes temas según sus necesidades.

Los temas de Kafka de destino contienen los registros CDC en varios temas según la base de datos de destino, y Kafka facilita la ordenación de las transacciones en función de la clave de Kafka definida. Las claves de partición se alinean con las particiones correspondientes para permitir un proceso secuencial.

Los conectores de bases de datos (aplicaciones Java personalizadas) escuchan los registros CDC de Amazon MSK y los almacenan en la base de datos de destino.

Puede seleccionar una base de datos de destino en función de sus requisitos. Este patrón es compatible con bases de datos NoSQL y relacionales.

Recuperación de desastres

La continuidad empresarial es clave para el éxito de su organización. La nube de AWS proporciona capacidades de alta disponibilidad (HA) y recuperación de desastres (DR), y respalda los planes de conmutación por error y alternativos de su organización. Este patrón sigue una estrategia de DR activa/pasiva y proporciona una guía de alto nivel para implementar una estrategia de DR que cumpla con sus requisitos de RTO y RPO.

En el siguiente diagrama, se ilustra el flujo de trabajo de DR.

En el diagrama se muestra lo siguiente:

Se requiere una conmutación por error semiautomática si se produce algún error en la Región de AWS 1. En caso de que se produzca un error en la Región 1, el sistema debe iniciar los cambios de enrutamiento para conectar a Precisely Dispatcher con la Región 2.

Amazon MSK replica los datos mediante la duplicación entre regiones. Por este motivo, durante la conmutación por error, hay que promover al clúster de Amazon MSK de la región 2 como líder principal.

Precisely Apply Engine y los conectores de bases de datos son aplicaciones sin estado que pueden funcionar en cualquier región.

La sincronización de la base de datos depende de la base de datos de destino. Por ejemplo, DynamoDB puede usar tablas globales ElastiCache y almacenes de datos globales.

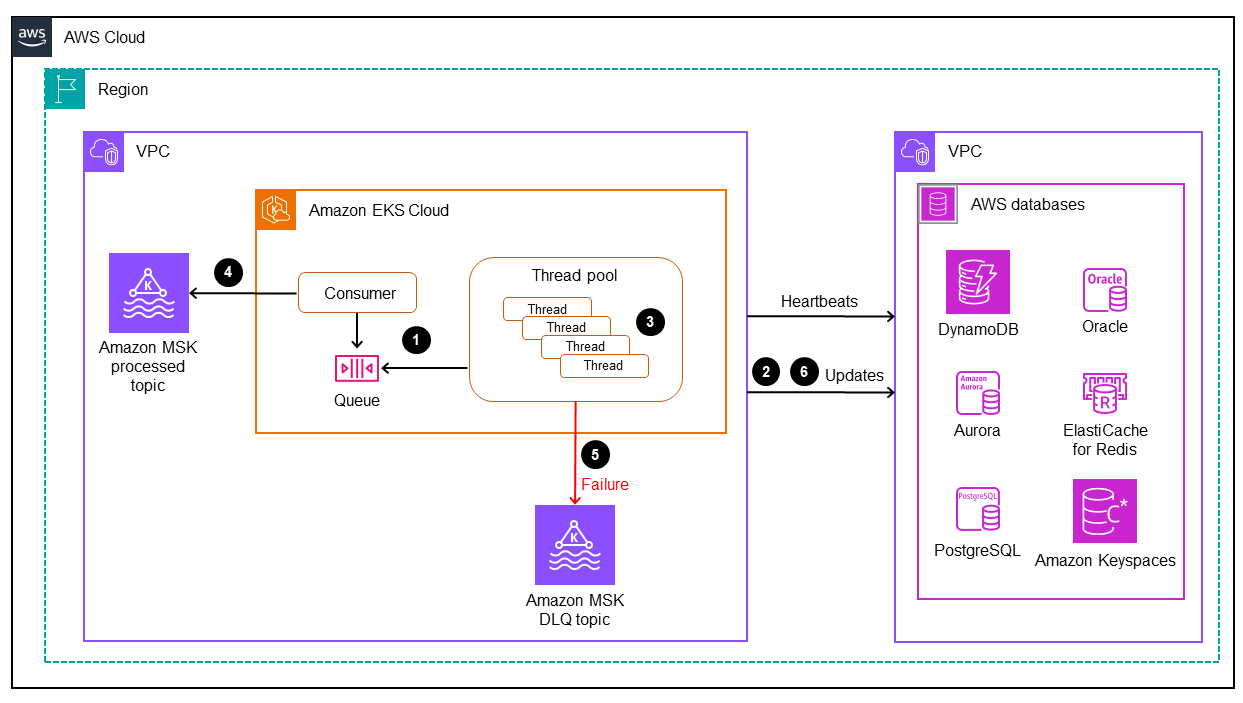

Procesamiento de baja latencia y alto rendimiento mediante conectores de bases de datos

Los conectores de bases de datos son componentes fundamentales en este patrón. Los conectores siguen un enfoque basado en el oyente para recopilar datos de Amazon MSK y enviar las transacciones a la base de datos mediante un procesamiento de alto rendimiento y baja latencia para aplicaciones de misión crítica (niveles 0 y 1). En el siguiente diagrama se ilustra este proceso.

Este patrón permite desarrollar una aplicación personalizada con un consumo de un solo subproceso mediante un motor de procesamiento de subprocesos múltiples.

El proceso principal del conector consume los registros CDC de Amazon MSK y los envía al grupo de subprocesos para su procesamiento.

Los subprocesos del grupo de subprocesos procesan los registros de los CDC y los envían a la base de datos de destino.

Si todos los subprocesos están ocupados, la cola de subprocesos mantiene en espera los registros de la CDC.

El subproceso principal espera a que se borren todos los registros de la cola de subprocesos y envía las compensaciones a Amazon MSK.

Los subprocesos secundarios gestionan los errores. Si se producen errores durante el procesamiento, los mensajes fallidos se envían al tema DLQ (cola de mensajes fallidos).

Los subprocesos secundarios inician actualizaciones condicionales (consulte Expresiones de condición en la documentación de DynamoDB), en función de la marca de tiempo del mainframe, para evitar cualquier duplicación o actualización en la base de datos. out-of-order

Para obtener información sobre cómo implementar una aplicación de consumidor de Kafka con capacidades de subprocesos múltiples, consulte la entrada del blog Consumo de mensajes multiprocesos con el consumidor de Apache Akfka

Herramientas

Servicios de AWS

Amazon Managed Streaming para Apache Kafka (Amazon MSK) es un servicio completamente administrado que le permite crear y ejecutar aplicaciones que utilizan Apache Kafka para procesar datos de streaming.

Amazon Elastic Kubernetes Service (Amazon EKS) le ayuda a ejecutar Kubernetes en AWS sin necesidad de instalar ni mantener su propio plano de control o nodos de Kubernetes.

Amazon EKS Anywhere

le permite implementar, usar y administrar los clústeres de Kubernetes que se ejecutan en sus propios centros de datos. Amazon DynamoDB es un servicio de base de datos de NoSQL completamente administrado que ofrece un rendimiento rápido, predecible y escalable.

Amazon Relational Database Service (Amazon RDS) le ayuda a configurar, utilizar y escalar una base de datos relacional en la nube de AWS.

Amazon le ElastiCache ayuda a configurar, gestionar y escalar entornos de caché en memoria distribuidos en la nube de AWS.

Amazon Keyspaces (para Apache Cassandra) es un servicio de base de datos administrada que le permite migrar, ejecutar y escalar sus cargas de trabajo de Cassandra en la nube de AWS.

Otras herramientas

Precisely Connect

integra los datos de los sistemas de unidad central heredados, como los conjuntos de datos de VSAM o las bases de datos de unidad central de IBM, en plataformas de datos y nube de próxima generación.

Prácticas recomendadas

Encuentre la mejor combinación de particiones Kafka y conectores multiprocesos para lograr un equilibrio óptimo entre rendimiento y costo. Varias instancias de Precisely Capture y Dispatcher pueden aumentar el costo debido al mayor consumo de MIPS (millones de instrucciones por segundo).

Evite añadir lógica de manipulación y transformación de datos a los conectores de bases de datos. Para ello, utilice Precisely Apply Engine, que proporciona tiempos de procesamiento en microsegundos.

Cree solicitudes periódicas o llamadas de comprobación de estado a la base de datos (latidos) en los conectores de la base de datos para calentar la conexión con frecuencia y reducir la latencia.

Implemente una lógica de validación de grupos de subprocesos para comprender las tareas pendientes en la cola de subprocesos y espere a que se completen todos los subprocesos antes del siguiente sondeo de Kafka. Esto ayuda a evitar la pérdida de datos si un nodo, contenedor o proceso se bloquea.

Exponga las métricas de latencia a través de puntos de conexión de estado para mejorar las capacidades de observabilidad mediante paneles y mecanismos de rastreo.

Epics

| Tarea | Descripción | Habilidades requeridas |

|---|---|---|

Configure el proceso de la unidad central (por lotes o en línea) para iniciar el proceso de CDC desde las bases de datos de la unidad central. |

| Ingeniero de unidad central |

Active los flujos de registro de la base de datos de unidad central. |

| Especialista en bases de datos para unidad central |

Utilice el componente Capture para capturar los registros de los CDC. |

| Ingeniero de unidad central, Precisely Connect SME |

Configure el componente Publisher para que escuche al componente Capture. |

| Ingeniero de unidad central, Precisely Connect SME |

Aprovisione Amazon EKS Anywhere en el entorno distribuido en las instalaciones. |

| DevOps ingeniero |

Implemente y configure el componente Dispatcher en el entorno distribuido para que publique los temas en la nube de AWS. |

| DevOps ingeniero, Precisely Connect SME |

| Tarea | Descripción | Habilidades requeridas |

|---|---|---|

Aprovisione un clúster de Amazon EKS en la región de AWS designada. |

| DevOps ingeniero, administrador de redes |

Aprovisione un clúster de MSK y configure los temas de Kafka aplicables. |

| DevOps ingeniero, administrador de red |

Configure el componente Apply Engine para que escuche los temas de Kafka replicados. |

| Precisely Connect SME |

Aprovisione instancias de base de datos en la nube de AWS. |

| Ingeniero de datos, DevOps ingeniero |

Configure e implemente conectores de bases de datos para que escuchen los temas publicados por Apply Engine. |

| Desarrollador de aplicaciones, arquitecto de la nube, ingeniero de datos |

| Tarea | Descripción | Habilidades requeridas |

|---|---|---|

Defina los objetivos de recuperación de desastres para sus aplicaciones empresariales. |

| Arquitecto de la nube, ingeniero de datos, propietario de la aplicación |

Diseñe estrategias de recuperación de desastres basadas en un RTO/RPO definido. |

| Arquitecto de la nube, ingeniero de datos |

Aprovisione clústeres y configuraciones de recuperación de desastres. |

| DevOps ingeniero, administrador de redes, arquitecto de nube |

Ponga a prueba la capacidad de recuperación de desastres de la canalización de CDC. |

| Propietario de aplicaciones, ingeniero de datos, arquitecto de la nube |

Recursos relacionados

Recursos de AWS

Recursos de Precisely Connect

Recursos Confluent