AWS IoT Greengrass Version 1 memasuki fase umur panjang pada 30 Juni 2023. Untuk informasi selengkapnya, lihat kebijakan AWS IoT Greengrass V1 pemeliharaan. Setelah tanggal ini, tidak AWS IoT Greengrass V1 akan merilis pembaruan yang menyediakan fitur, penyempurnaan, perbaikan bug, atau patch keamanan. Perangkat yang berjalan AWS IoT Greengrass V1 tidak akan terganggu dan akan terus beroperasi dan terhubung ke cloud. Kami sangat menyarankan Anda bermigrasi ke AWS IoT Greengrass Version 2, yang menambahkan fitur baru yang signifikan dan dukungan untuk platform tambahan.

Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Cara mengonfigurasi kesimpulan machine learning yang dioptimalkan menggunakan AWS Management Console

Untuk mengikuti langkah-langkah dalam tutorial ini, Anda harus menggunakan AWS IoT Greengrass Core v1.10 atau yang lebih baru.

Anda dapat menggunakan kompiler pembelajaran mendalam SageMaker AI Neo untuk mengoptimalkan efisiensi prediksi model inferensi pembelajaran mesin asli di Tensorflow, Apache,, ONNX, dan XGBoost kerangka kerja untuk MXNet jejak PyTorch yang lebih kecil dan kinerja yang lebih cepat. Anda kemudian dapat mengunduh model yang dioptimalkan dan menginstal runtime pembelajaran mendalam SageMaker AI Neo dan menerapkannya ke AWS IoT Greengrass perangkat Anda untuk inferensi yang lebih cepat.

Tutorial ini menjelaskan cara menggunakan AWS Management Console untuk mengkonfigurasi grup Greengrass untuk menjalankan contoh inferensi Lambda yang mengenali gambar dari kamera secara lokal, tanpa mengirim data ke cloud. Contoh kesimpulan mengakses modul kamera pada Raspberry Pi. Dalam tutorial ini, Anda mengunduh model prepackaged yang dilatih oleh Resnet-50 dan dioptimalkan di kompilator Neo deep learning. Anda kemudian menggunakan model untuk melakukan klasifikasi gambar lokal pada AWS IoT Greengrass perangkat Anda.

Tutorial ini berisi langkah-langkah tingkat tinggi berikut:

Prasyarat

Untuk menyelesaikan tutorial ini, Anda memerlukan:

-

Raspberry Pi 4 Model B, atau Raspberry Pi 3 Model B/B +, diatur dan dikonfigurasi untuk digunakan dengan. AWS IoT Greengrass Untuk mengatur Raspberry Pi Anda dengan AWS IoT Greengrass, jalankan Pengaturan Perangkat Greengrass tersebut, atau pastikan bahwa Anda telah menyelesaikan Modul 1 dan Modul 2 dari Memulai dengan AWS IoT Greengrass.

catatan

Raspberry Pi mungkin memerlukan Catu daya

2.5A untuk menjalankan kerangka kerja deep learning yang biasanya digunakan untuk klasifikasi citra. Catu daya dengan peringkat lebih rendah dapat menyebabkan perangkat melakukan reboot. -

Modul Kamera Raspberry Pi V2 - 8 megapiksel, 1080p

. Untuk mempelajari cara mengatur kamera, lihat Menghubungkan kamera dalam dokumentasi Raspberry Pi. -

Sebuah grup Greengrass dan Greengrass core. Untuk mempelajari cara membuat grup Greengrass atau core, lihat Memulai dengan AWS IoT Greengrass.

catatan

Tutorial ini menggunakan Raspberry Pi, tetapi AWS IoT Greengrass mendukung platform lain, seperti Intel Atom dan NVIDIA Jetson TX2. Jika menggunakan contoh Intel Atom, Anda mungkin butuh menginstal Python 3.6 bukannya Python 3.7. Untuk informasi tentang mengonfigurasi perangkat sehingga Anda dapat menginstal perangkat lunak AWS IoT Greengrass Core, lihatMengatur perangkat lain.

Untuk platform pihak ketiga yang AWS IoT Greengrass tidak mendukung, Anda harus menjalankan fungsi Lambda Anda dalam mode non-kontainer. Untuk menjalankan dalam mode nonkontainerisasi, Anda harus menjalankan fungsi Lambda Anda sebagai root. Untuk informasi selengkapnya, silakan lihat Pertimbangan ketika memilih fungsi Lambda kontainerisasi dan Mengatur identitas akses default untuk fungsi Lambda dalam grup.

Langkah 1: Mengonfigurasi Pi Raspberry

Pada langkah ini, instal pembaruan untuk sistem operasi Raspbian, instal perangkat lunak modul kamera dan Python dependensi, dan mengaktifkan antarmuka kamera.

Jalankan perintah berikut di terminal Raspberry Pi Anda.

-

Menginstal pembaruan untuk Raspbian.

sudo apt-get update sudo apt-get dist-upgrade -

Instal antarmuka

picamerauntuk modul kamera dan pustaka Python lain yang diperlukan untuk tutorial ini.sudo apt-get install -y python3-dev python3-setuptools python3-pip python3-picameraMemvalidasi instalasi:

-

Pastikan bahwa instalasi Python 3.7 anda termasuk pip.

python3 -m pipJika pip tidak terpasang, unduh dari Situs web pip

tersebut, kemudian jalankan perintah berikut. python3 get-pip.py -

Pastikan bahwa versi Python Anda adalah 3.7 atau lebih tinggi.

python3 --versionJika output mencantumkan versi sebelumnya, jalankan perintah berikut.

sudo apt-get install -y python3.7-dev -

Pastikan bahwa Setuptools dan Picamera berhasil diinstal.

sudo -u ggc_user bash -c 'python3 -c "import setuptools"' sudo -u ggc_user bash -c 'python3 -c "import picamera"'Jika output tidak mengandung error, validasi berhasil.

catatan

Jika Python yang dapat dieksekusi diinstal pada perangkat anda adalah

python3.7, gunakanpython3.7daripadapython3untuk perintah di tutorial ini. Pastikan bahwa instalasi pip Anda memetakan versipython3.7ataupython3yang tepat untuk menghindari kesalahan dependensi. -

-

Reboot Raspberry Pi.

sudo reboot -

Buka alat konfigurasi Raspberry Pi.

sudo raspi-config -

Gunakan tombol panah untuk membuka Opsi Antarmuka dan mengaktifkan antarmuka kamera. Jika diminta, izinkan perangkat melakukan reboot.

-

Gunakan perintah berikut untuk menguji pengaturan kamera.

raspistill -v -o test.jpgHal ini akan membuka jendela pratinjau pada Raspberry Pi, menyimpan gambar bernama

test.jpgke direktori Anda saat ini, dan menampilkan informasi tentang kamera di terminal Raspberry Pi.

Langkah 2: Instal runtime pembelajaran mendalam Amazon SageMaker Neo

Dalam langkah ini, menginstal waktu aktif deep learning (DLR) Neo pada Anda Raspberry Pi.

catatan

Kami sarankan menginstal versi 1.1.0 untuk tutorial ini.

-

Masuk ke Raspberry Pi Anda secara jarak jauh.

ssh pi@your-device-ip-address -

Buka dokumentasi DLR, buka Menginstal DLR

, dan menemukan URL wheel untuk perangkat Raspberry Pi. Kemudian, ikuti petunjuk untuk menginstal DLR di perangkat Anda. Sebagai contoh, Anda dapat menggunakan pip: pip3 installrasp3b-wheel-url -

Setelah Anda menginstal DLR, validasikan konfigurasi berikut:

-

Pastikan

ggc_userakun sistem dapat menggunakan perpustakaan DLR.sudo -u ggc_user bash -c 'python3 -c "import dlr"' -

Pastikan NumPy sudah terpasang.

sudo -u ggc_user bash -c 'python3 -c "import numpy"'

-

Langkah 3: Buat fungsi Lambda inferensi

Pada langkah ini, buat paket deployment fungsi Lambda dan fungsi Lambda. Kemudian, terbitkan versi fungsi dan membuat alias.

-

Pada komputer Anda, unduh sampel DLR untuk Raspberry Pi dari Sampel machine learning.

-

Unzip yang diunduh

dlr-py3-armv7l.tar.gzFile.cdpath-to-downloaded-sampletar -xvzf dlr-py3-armv7l.tar.gzDirektori

examplesdalam paket contoh yang diekstrak berisi kode fungsi dan dependensi.-

inference.pyadalah kode inference yang digunakan dalam tutorial ini. Anda dapat menggunakan kode ini sebagai templat untuk membuat fungsi inferensi Anda sendiri. -

greengrasssdkadalah versi 1.5.0 dari AWS IoT Greengrass Core SDK for Python.catatan

Jika versi baru tersedia, Anda dapat mengunduh dan membarui versi SDK dalam paket deployment Anda. Untuk informasi selengkapnya, lihat AWS IoT Greengrass Core SDK for GitHub Python

.

-

-

Kompres isi

exampleske dalam sebuah file bernamaoptimizedImageClassification.zip. Ini paket deployment Anda.cdpath-to-downloaded-sample/dlr-py3-armv7l/examples zip -r optimizedImageClassification.zip .Paket deployment berisi dependensi dan kode fungsi Lambda Anda. Ini termasuk kode yang memanggil Neo deep learning runtime Python APIs untuk melakukan inferensi dengan model kompiler deep learning Neo.

catatan

Pastikan

.pyfile dan dependensi berada di root direktori. -

Sekarang, tambahkan fungsi Lambda ke grup Greengrass Anda.

Dari halaman konsol Lambda, pilih Fungsi dan pilih Buat fungsi.

-

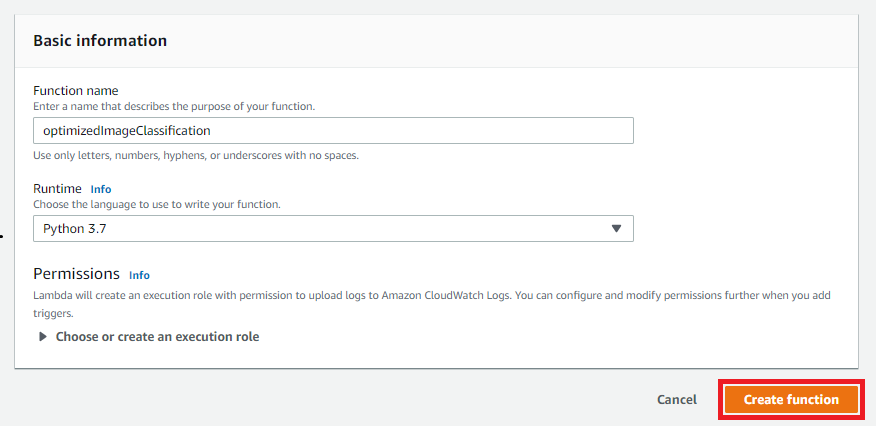

Pilih Tulis dari awal dan gunakan nilaiinilai berikut untuk membuat fungsi Anda:

-

Untuk Nama fungsi, masukkan

optimizedImageClassification. -

Untuk Waktu pengoperasian, pilih Python 3.7.

Untuk Izin, pertahankan pengaturan default. Hal ini menciptakan peran eksekusi yang memberikan izin Lambda basic. Peran ini tidak digunakan oleh AWS IoT Greengrass.

-

-

Pilih Buat fungsi.

Sekarang, unggah paket deployment fungsi Lambda Anda dan daftarkan handler.

-

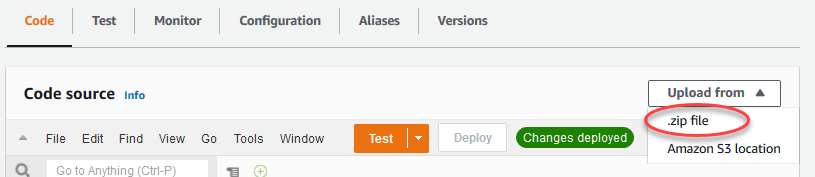

Pada tab Kode ini, di bawah Sumber kode, pilih Unggah dari. Dari dropdown, pilih file .zip.

-

Pilih paket deployment

optimizedImageClassification.zipAnda, dan kemudian pilih Simpan. -

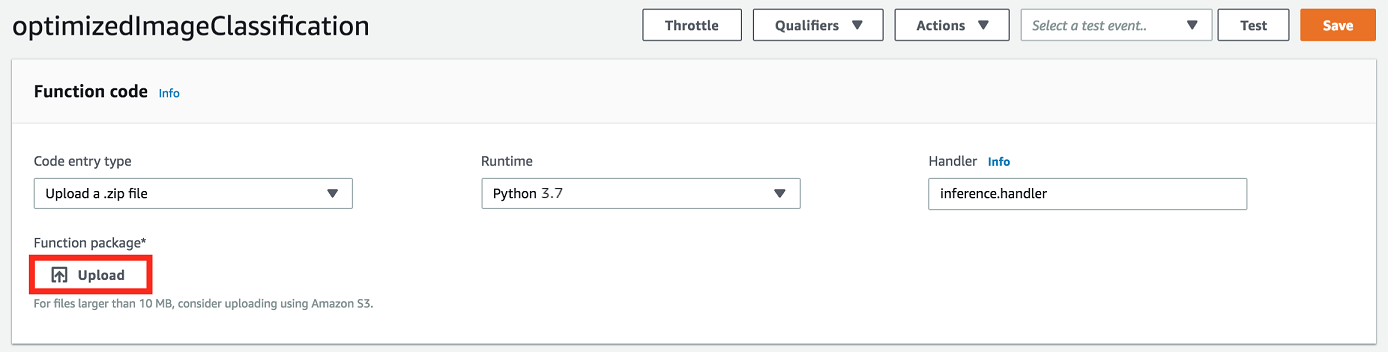

Pada tab Kode fungsi, di bawah Pengaturan waktu aktif, pilih Edit, dan kemudian masukkan nilai-nilai berikut.

-

Untuk waktu aktif, pilih Python 3.7.

-

Untuk Handler, masukkan

inference.handler.

Pilih Simpan.

-

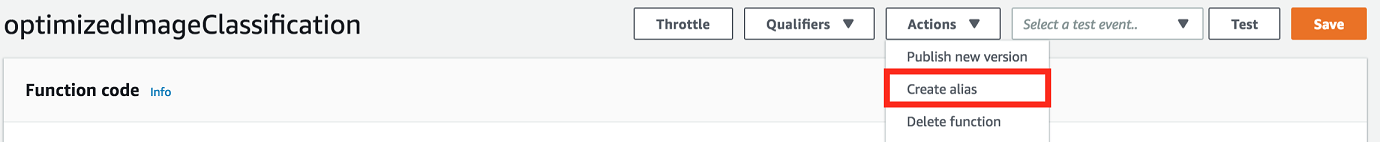

Selanjutnya, terbitkan versi pertama fungsi Lambda Anda. Kemudian, buat alias untuk versi.

catatan

Grup Greengrass dapat mereferensi fungsi Lambda dengan alias (direkomendasikan) atau dengan versi. Menggunakan alias membuatnya lebih mudah untuk mengelola pembaruan kode karena Anda tidak perlu mengubah tabel langganan atau definisi grup ketika kode fungsi diperbarui. Sebaliknya, Anda hanya mengarahkan alias ke versi fungsi baru.

-

Dari menu Tindakan tersebut, pilih Publikasikan versi baru.

-

Untuk Versi Deskripsi, masukkan

First version, lalu pilih Publikasikan. -

Pada halaman konfigurasi optimizedImageClassification: 1, dari menu Tindakan, pilih Buat alias.

-

Pada halaman Buat alias baru tersebut, gunakan nilai-nilai berikut:

-

Untuk Nama, masukkan

mlTestOpt. -

Untuk UID, masukkan

1.

catatan

AWS IoT Greengrass tidak mendukung alias Lambda untuk versi $LATEST.

-

-

Pilih Buat.

Sekarang, tambahkan fungsi Lambda ke grup Greengrass Anda.

Langkah 4: Tambahkan fungsi Lambda ke grup Greengrass

Pada langkah ini, tambahkan fungsi Lambda ke grup, dan kemudian mengonfigurasi siklus hidupnya.

Pertama, tambahkan fungsi Lambda ke grup Greengrass Anda.

Di panel navigasi AWS IoT konsol, di bawah Kelola, perluas perangkat Greengrass, lalu pilih Grup (V1).

-

Pada halaman konfigurasi grup, pilih tab fungsi Lambda, dan pilih Tambah.

-

Pilih fungsi Lambda dan pilih. optimizedImageClassification

-

Pada versi fungsi Lambda, pilih alias ke versi yang Anda terbitkan.

Selanjutnya, konfigurasikan siklus hidup fungsi Lambda.

-

Di bagian konfigurasi fungsi Lambda, buat pembaruan berikut.

catatan

Kami merekomendasikan Anda menjalankan fungsi Lambda Anda tanpa kontainerisasi kecuali kasus bisnis Anda memerlukannya. Hal ini membantu mengaktifkan akses ke perangkat GPU dan kamera Anda tanpa mengonfigurasi sumber daya perangkat. Jika Anda menjalankan tanpa containerization, Anda juga harus memberikan akses root ke fungsi Lambda AWS IoT Greengrass Anda.

-

Untuk berjalan tanpa kontainerisasi:

-

Untuk pengguna dan grup Sistem, pilih

Another user ID/group ID. Untuk ID pengguna Sistem, masukkan0. Untuk ID grup Sistem, masukkan0.Hal ini memungkinkan fungsi Lambda Anda untuk berjalan sebagai root. Untuk informasi lebih lanjut untuk menjalankan sebagai root, lihat Mengatur identitas akses default untuk fungsi Lambda dalam grup.

Tip

Anda juga harus memperbarui file

config.jsonuntuk memberikan akses root ke fungsi Lambda Anda. Untuk prosedur ini, lihat Menjalankan fungsi Lambda sebagai root. -

Untuk kontainerisasi fungsi Lambda, pilih No container.

Untuk informasi lebih lanjut untuk berjalan tanpa konainerisasi, lihat Pertimbangan ketika memilih fungsi Lambda kontainerisasi.

-

Untuk Timeout, masukkan

10 seconds. -

Untuk Pinned, pilih True.

Untuk informasi selengkapnya, lihat Konfigurasi siklus hidup untuk fungsi Greengrass Lambda.

-

Di bawah Parameter Tambahan, untuk akses Baca ke direktori /sys, pilih Diaktifkan.

-

-

Untuk menjalankan dalam mode kontainer sebagai gantinya:

catatan

Kami tidak merekomendasikan untuk dijalankan dalam mode kontainer kecuali jika kasus bisnis Anda memerlukannya.

-

Untuk pengguna dan grup Sistem, pilih Gunakan grup default.

-

Untuk kontainerisasi fungsi Lambda, pilih Gunakan default grup.

-

Untuk Batas memori, masukkan

1024 MB. -

Untuk Timeout, masukkan

10 seconds. -

Untuk Pinned, pilih True.

Untuk informasi selengkapnya, lihat Konfigurasi siklus hidup untuk fungsi Greengrass Lambda.

-

Di bawah Parameter Tambahan, untuk akses Baca ke direktori /sys, pilih Diaktifkan.

-

-

-

Pilih Tambahkan fungsi Lambda.

Langkah 5: Tambahkan sumber daya model SageMaker AI NEO yang dioptimalkan ke grup Greengrass

Pada langkah ini, buat sumber daya untuk model inferensi ML dioptimalkan dan unggah ke bucket Amazon S3. Kemudian, cari model yang diunggah Amazon S3 di AWS IoT Greengrass konsol dan afiliasi sumber daya yang baru dibuat dengan fungsi Lambda. Hal ini memungkinkan fungsi untuk mengakses sumber dayanya pada perangkat core.

-

Pada komputer Anda, navigasikan ke direktori

resnet50dalam paket contoh yang Anda unzip di Langkah 3: Buat fungsi Lambda inferensi.catatan

Jika menggunakan contoh NVIDIA Jetson, Anda harus menggunakan

resnet18dalam paket contoh sebagai gantinya. Untuk informasi selengkapnya, lihat Mengkonfigurasi NVIDIA Jetson TX2.cdpath-to-downloaded-sample/dlr-py3-armv7l/models/resnet50Direktori ini berisi artefak model precompiled untuk model klasifikasi citra dilatih dengan Resnet-50.

-

Kompres file di dalam direktori

resnet50ke dalam sebuah file bernamaresnet50.zip.zip -r resnet50.zip . -

Pada halaman konfigurasi grup untuk AWS IoT Greengrass grup Anda, pilih tab Sumber Daya. Navigasikan ke Machine Learning bagian dan pilih Tambah sumber daya machine learning. Pada halaman Buat sumber daya machine learning ini, untuk Nama sumber daya, masukkan

resnet50_model. -

Untuk sumber Model, pilih Gunakan model yang disimpan di S3, seperti model yang dioptimalkan melalui Deep Learning Compiler.

-

Di bawah S3 URI, pilih Browse S3.

catatan

Saat ini, model SageMaker AI yang dioptimalkan disimpan secara otomatis di Amazon S3. Anda dapat menemukan model yang dioptimalkan di bucket Amazon S3 Anda menggunakan opsi ini. Untuk informasi lebih lanjut tentang pengoptimalan model di SageMaker AI, lihat dokumentasi SageMaker AI Neo.

-

Pilih Uunggah model.

-

Pada tab konsol Amazon S3, unggah file zip Anda ke bucket Amazon S3. Untuk selengkapnya, lihat Bagaimana cara mengunggah file dan folder ke bucket S3? di Panduan Pengguna Layanan Penyimpanan Sederhana Amazon.

catatan

Nama bucket Anda harus berisi string

greengrass. Pilih nama yang unik (sepertigreengrass-dlr-bucket-). Jangan gunakan periode (user-id-epoch-time.) dalam nama bucket. -

Di tab AWS IoT Greengrass konsol, cari dan pilih bucket Amazon S3 Anda. Tempatkan file

resnet50.zipyang Anda unggah, dan pilih Pilihan. Anda mungkin perlu me-refresh halaman untuk memperbarui daftar bucket dan file yang tersedia. -

Di jalur Tujuan, masukkan

/ml_model.

Hal ini adalah tujuan untuk model lokal di Lambda waktu aktif namespace. Saat Anda menyebarkan grup, AWS IoT Greengrass mengambil paket model sumber dan kemudian mengekstrak konten ke direktori yang ditentukan.

catatan

Kami sangat merekomendasikan Anda menggunakan jalur yang tepat yang disediakan untuk jalur lokal Anda. Menggunakan jalur tujuan model lokal yang berbeda dalam langkah ini menyebabkan beberapa perintah pemecahan masalah yang disediakan dalam tutorial ini menjadi tidak akurat. Jika Anda menggunakan jalur yang berbeda, Anda harus mengatur

MODEL_PATHlingkungan yang menggunakan jalur yang tepat yang Anda berikan di sini. Untuk informasi lebih lanjut tentang variabel lingkungan, lihat AWS Lambda variabel lingkungan. -

Jika berjalan dalam mode kontainer:

-

Di bawah Pemilik grup sistem dan izin akses file, pilih Tentukan grup sistem dan izin.

-

Pilih Akses hanya-baca dan kemudian pilih Tambah sumber daya.

-

Langkah 6: Tambahkan sumber daya perangkat kamera Anda ke grup Greengrass

Pada langkah ini, buat sumber daya untuk modul kamera dan mengafiliasikannya dengan fungsi Lambda. Hal ini memungkinkan fungsi Lambda untuk mengakses sumber daya pada perangkat core.

catatan

Jika Anda menjalankan dalam mode non-kontainer, AWS IoT Greengrass dapat mengakses GPU dan kamera perangkat Anda tanpa mengonfigurasi sumber daya perangkat ini.

-

Pada halaman konfigurasi grup, pilih tab Sumber Daya.

-

Pada tab Sumber daya lokal, pilih Tambahkan sumber daya lokal.

-

Pada halaman Tambahkan sumber daya lokal, gunakan nilai berikut:

-

Untuk Nama sumber daya, masukkan

videoCoreSharedMemory. -

Untuk Jenis sumber daya, pilih Perangkat.

-

Untuk jalur perangkat lokal, masukkan

/dev/vcsm.Jalur perangkat adalah jalur absolut lokal sumber daya perangkat. Path ini hanya dapat merujuk ke perangkat karakter atau perangkat blok di bawah

/dev. -

Untuk pemilik grup sistem dan izin akses file, pilih Secara otomatis menambahkan izin sistem file dari grup sistem yang memiliki sumber daya.

Opsi Izin akses file pemilik grup memungkinkan Anda memberikan izin akses file tambahan untuk proses Lambda. Untuk informasi selengkapnya, lihat Izin akses file pemilik grup.

-

-

Di bagian bawah halaman, pilih Tambahkan sumber daya.

-

Dari tab Sumber Daya, buat sumber daya lokal lain dengan memilih Tambah dan gunakan nilai berikut:

-

Untuk Nama sumber daya, masukkan

videoCoreInterface. -

Untuk Jenis sumber daya, pilih Perangkat.

-

Untuk jalur perangkat lokal, masukkan

/dev/vchiq. -

Untuk pemilik grup sistem dan izin akses file, pilih Secara otomatis menambahkan izin sistem file dari grup sistem yang memiliki sumber daya.

-

-

Pilih Tambahkan sumber daya.

Langkah 7: Menambahkan langganan ke grup Greengrass

Pada langkah ini, tambahkan langganan ke grup. Langganan ini memungkinkan fungsi Lambda untuk mengirim hasil prediksi dengan memublikasikan AWS IoT ke topik MQTT.

-

Pada halaman konfigurasi grup, pilih tab Langganan, lalu pilih Tambahkan langganan.

-

Pada halaman Buat langganan, konfigurasikan sumber dan target, sebagai berikut:

-

Di tipe Sumber, pilih fungsi Lambda, lalu pilih. optimizedImageClassification

-

Di Jenis target, pilih Layanan, lalu pilih IoT Cloud.

-

Di filter Topik, masukkan

/resnet-50/predictions, lalu pilih Buat langganan.

-

-

Tambahkan langganan kedua. Pilih tab Langganan, pilih Tambahkan langganan, dan konfigurasikan sumber dan target, sebagai berikut:

-

Di tipe Sumber, pilih Layanan, lalu pilih IoT Cloud.

-

Di Jenis target, pilih fungsi Lambda, lalu pilih. optimizedImageClassification

-

Di filter Topik, masukkan

/resnet-50/test, lalu pilih Buat langganan.

-

Langkah 8: Men-deploy grup Greengrass

Pada langkah ini, men-deploy versi definisi grup untuk perangkat core Greengrass. Definisi berisi fungsi Lambda, sumber daya, dan konfigurasi langganan yang ditambahkan.

-

Pastikan AWS IoT Greengrass inti sedang berjalan. Jalankan perintah berikut di terminal Raspberry Pi Anda, sesuai kebutuhan.

-

Untuk memeriksa apakah daemon sedang berjalan:

ps aux | grep -E 'greengrass.*daemon'Jika output berisi

rootentri untuk/greengrass/ggc/packages/, maka daemon sedang berjalan.latest-core-version/bin/daemon Mulai daemon:

cd /greengrass/ggc/core/ sudo ./greengrassd start

-

-

Pada halaman konfigurasi grup, pilih Deploy.

-

Pada tab Fungsi Lambda, pilih detektor IP dan pilih Edit.

-

Dari kotak dialog Edit pengaturan detektor IP, pilih Secara otomatis mendeteksi dan mengganti titik akhir broker MQTT dan pilih Simpan.

Hal ini mengaktifkan perangkat untuk secara otomatis memperoleh informasi konektivitas untuk core, seperti alamat IP, DNS, dan nomor port. Deteksi otomatis direkomendasikan, tetapi AWS IoT Greengrass juga mendukung titik akhir yang ditentukan secara manual. Anda hanya diminta untuk metode penemuan pertama kalinya bahwa grup di-deploy.

catatan

Jika diminta, berikan izin untuk membuat peran layanan Greengrass dan kaitkan dengan peran layanan Anda saat ini. Akun AWS Wilayah AWS Peran ini memungkinkan AWS IoT Greengrass untuk mengakses sumber daya Anda dalam AWS layanan.

Halaman Deployment menampilkan timestamp deployment, ID versi, dan status. Setelah selesai, status yang ditampilkan untuk penerapan harus Selesai.

Untuk informasi lebih lanjut tentang deployment, lihat Menyebarkan AWS IoT Greengrass grup ke inti AWS IoT Greengrass. Untuk bantuan pemecahan masalah, lihat Pemecahan masalah AWS IoT Greengrass.

Uji contoh inferensi

Sekarang Anda dapat memverifikasi apakah deployment dikonfigurasi dengan benar. Untuk menguji, Anda berlangganan topik /resnet-50/predictions dan menerbitkan pesan apa pun ke topik /resnet-50/test ini. Ini memicu fungsi Lambda untuk mengambil foto dengan Raspberry Pi Anda dan melakukan inferensi pada gambar yang ditangkap.

catatan

Jika menggunakan contoh NVIDIA Jetson, pastikan untuk menggunakan resnet-18/predictions dan resnet-18/test topik sebagai gantinya.

catatan

Jika monitor terpasang ke Raspberry Pi, umpan kamera langsung ditampilkan di jendela pratinjau.

-

Di halaman beranda AWS IoT konsol, di bawah Uji, pilih klien pengujian MQTT.

-

Untuk Langganan, pilih Berlangganan Topik. Gunakan nilai-nilai berikut. Tinggalkan opsi yang tersisa pada defaultnya.

-

Untuk Topik langganan, masukkan

/resnet-50/predictions. -

Di bawah Konfigurasi tambahan, untuk tampilan payload MQTT, pilih Display payloads sebagai string.

-

-

Pilih Langganan.

-

Pilih Publikasikan ke topik, masukkan

/resnet-50/testsebagai nama Topik, dan pilih Publikasikan. -

Jika uji berhasil, pesan diterbitkan menyebabkan kamera Raspberry Pi untuk menangkap citra. Sebuah pesan dari fungsi Lambda muncul di bagian bawah halaman. Pesan ini berisi hasil prediksi citra, menggunakan format: diprediksi nama kelas, probabilitas, dan penggunaan memori puncak.

Mengkonfigurasi Atom Intel

Untuk menjalankan tutorial ini pada perangkat Intel Atom, Anda harus memberikan citra sumber, Mengonfigurasi fungsi Lambda, dan menambahkan sumber daya perangkat lokal lain. Untuk menggunakan GPU sebagai inferensi, pastikan perangkat lunak berikut diinstal pada perangkat Anda:

-

OpenCL versi 1.0 atau yang lebih baru

-

Python 3.7 dan pip

-

Unduh citra PNG atau JPG statis untuk fungsi Lambda yang akan digunakan untuk klasifikasi citra. Contoh tersebut bekerja paling baik dengan file citra kecil.

Simpan file citra Anda di direktori yang memuat file

inference.py(atau dalam subdirektori dari direktori ini). Hal ini ada dalam paket deployment fungsi Lambda yang Anda unggah di Langkah 3: Buat fungsi Lambda inferensi.catatan

Jika Anda menggunakan AWS DeepLens, Anda dapat menggunakan kamera onboard atau memasang kamera Anda sendiri untuk melakukan inferensi pada gambar yang diambil, bukan gambar statis. Namun, kami sangat merekomendasikan Anda mulai dengan citra statis terlebih dahulu.

Jika Anda menggunakan kamera, pastikan bahwa paket

awscamAPT diinstal dan diperbarui. Untuk informasi lebih lanjut, lihat Perbarui Perangkat AWS DeepLens Anda dalam AWS DeepLens Panduan Developer. -

Edit konfigurasi fungsi Lambda. Ikuti prosedur di Langkah 4: Tambahkan fungsi Lambda ke grup Greengrass.

catatan

Kami merekomendasikan Anda menjalankan fungsi Lambda Anda tanpa kontainerisasi kecuali kasus bisnis Anda memerlukannya. Hal ini membantu mengaktifkan akses ke perangkat GPU dan kamera Anda tanpa mengonfigurasi sumber daya perangkat. Jika Anda menjalankan tanpa containerization, Anda juga harus memberikan akses root ke fungsi Lambda AWS IoT Greengrass Anda.

-

Untuk berjalan tanpa kontainerisasi:

-

Untuk pengguna dan grup Sistem, pilih

Another user ID/group ID. Untuk ID pengguna Sistem, masukkan0. Untuk ID grup Sistem, masukkan0.Hal ini memungkinkan fungsi Lambda Anda untuk berjalan sebagai root. Untuk informasi lebih lanjut untuk menjalankan sebagai root, lihat Mengatur identitas akses default untuk fungsi Lambda dalam grup.

Tip

Anda juga harus memperbarui file

config.jsonuntuk memberikan akses root ke fungsi Lambda Anda. Untuk prosedur ini, lihat Menjalankan fungsi Lambda sebagai root. -

Untuk kontainerisasi fungsi Lambda, pilih No container.

Untuk informasi lebih lanjut tentang berjalan tanpa kontainerisasi, lihat Pertimbangan ketika memilih fungsi Lambda kontainerisasi.

-

Tingkatkan nilai Timeout untuk 2 menit. Ini memastikan bahwa permintaan batas waktu tidak terlalu pendek. Dibutuhkan beberapa menit setelah pengaturan untuk menjalankan inferensi.

-

Untuk Pinned, pilih True.

-

Di bawah Parameter Tambahan, untuk akses Baca ke direktori /sys, pilih Diaktifkan.

-

-

Untuk menjalankan dalam mode kontainer sebagai gantinya:

catatan

Kami tidak merekomendasikan untuk menjalankan dalam mode kontainerisasi kecuali jika kasus bisnis Anda memerlukannya.

-

Tingkatkan nilai Batas memori hingga 3000 MB.

-

Tingkatkan nilai Timeout untuk 2 menit. Ini memastikan bahwa permintaan batas waktu tidak terlalu pendek. Dibutuhkan beberapa menit setelah pengaturan untuk menjalankan inferensi.

-

Untuk Pinned, pilih True.

-

Di bawah Parameter Tambahan, untuk akses Baca ke direktori /sys, pilih Diaktifkan.

-

-

-

Tambahkan sumber daya model Neo-dioptimalisasi Anda ke grup. Unggah model sumber daya di direktori

resnet50dari paket sampel yang Anda unzipped di Langkah 3: Buat fungsi Lambda inferensi. Direktori ini berisi artefak model precompiled untuk model klasifikasi citra dilatih dengan Resnet-50. Ikuti prosedur di Langkah 5: Tambahkan sumber daya model SageMaker AI NEO yang dioptimalkan ke grup Greengrass dengan pembaruan berikut.-

Kompres file di dalam direktori

resnet50ke dalam sebuah file bernamaresnet50.zip. -

Pada halaman Buat sumber daya machine learning ini, untuk Nama sumber daya, masukkan

resnet50_model. -

Unggah

resnet50.zipfile.

-

-

Jika berjalan dalam mode containerized, tambahkan sumber daya perangkat lokal yang diperlukan untuk memberikan akses ke GPU perangkat Anda.

catatan

Jika Anda menjalankan dalam mode non-kontainer, AWS IoT Greengrass dapat mengakses GPU perangkat Anda tanpa mengonfigurasi sumber daya perangkat.

-

Pada halaman konfigurasi grup, pilih tab Sumber Daya.

-

Di bagian Sumber daya lokal, pilih Tambahkan sumber daya lokal.

-

Mendefinisikan sumber daya:

-

Untuk Nama sumber daya, masukkan

renderD128. -

Untuk Jenis sumber daya, pilih Perangkat.

-

Untuk jalur perangkat lokal, masukkan

/dev/dri/renderD128. -

Untuk pemilik grup sistem dan izin akses file, pilih Secara otomatis menambahkan izin sistem file dari grup sistem yang memiliki sumber daya.

-

-

Mengkonfigurasi NVIDIA Jetson TX2

Untuk menjalankan tutorial ini pada NVIDIA Jetson TX2, berikan gambar sumber, konfigurasikan fungsi Lambda, dan tambahkan lebih banyak sumber daya perangkat lokal.

-

Pastikan perangkat Jetson Anda dikonfigurasi sehingga Anda dapat menginstal perangkat lunak AWS IoT Greengrass Core dan menggunakan GPU untuk inferensi. Untuk informasi lebih lanjut tentang konfigurasi perangkat Anda, lihat Mengatur perangkat lain. Untuk menggunakan GPU untuk inferensi pada NVIDIA Jetson TX2, Anda harus menginstal CUDA 10.0 dan cuDNN 7.0 pada perangkat Anda ketika Anda gambar papan Anda dengan Jetpack 4.3.

-

Unduh citra PNG atau JPG statis untuk fungsi Lambda yang akan digunakan untuk klasifikasi citra. Contohnya bekerja paling baik dengan file citra kecil.

Simpan file citra Anda di direktori yang memuat

inference.pyfile. Anda juga dapat menyimpannya dalam subdirektori di direktori ini. Direktori ini adalah dalam paket deployment fungsi Lambda yang Anda unggah di Langkah 3: Buat fungsi Lambda inferensi.catatan

Anda dapat memilih untuk instrumen kamera di papan Jetson untuk menangkap citra sumber. Namun, kami sangat merekomendasikan Anda mulai dengan citra statis terlebih dahulu.

-

Edit konfigurasi fungsi Lambda. Ikuti prosedur di Langkah 4: Tambahkan fungsi Lambda ke grup Greengrass.

catatan

Kami merekomendasikan Anda menjalankan fungsi Lambda Anda tanpa kontainerisasi kecuali kasus bisnis Anda memerlukannya. Hal ini membantu mengaktifkan akses ke perangkat GPU dan kamera Anda tanpa mengonfigurasi sumber daya perangkat. Jika Anda menjalankan tanpa containerization, Anda juga harus memberikan akses root ke fungsi Lambda AWS IoT Greengrass Anda.

-

Untuk berjalan tanpa kontainerisasi:

-

Untuk Jalankan sebagai, pilih

Another user ID/group ID. Untuk UID, masukkan0. Untuk GUID, masukkan0.Hal ini memungkinkan fungsi Lambda Anda untuk berjalan sebagai root. Untuk informasi lebih lanjut untuk menjalankan sebagai root, lihat Mengatur identitas akses default untuk fungsi Lambda dalam grup.

Tip

Anda juga harus memperbarui file

config.jsonuntuk memberikan akses root ke fungsi Lambda Anda. Untuk prosedur ini, lihat Menjalankan fungsi Lambda sebagai root. -

Untuk kontainerisasi fungsi Lambda, pilih No container.

Untuk informasi lebih lanjut tentang berjalan tanpa kontainerisasi, lihat Pertimbangan ketika memilih fungsi Lambda kontainerisasi.

-

Tingkatkan nilai Timeout untuk 5 menit. Ini memastikan bahwa permintaan batas waktu tidak terlalu pendek. Dibutuhkan beberapa menit setelah pengaturan untuk menjalankan inferensi.

-

Untuk Pinned, pilih True.

-

Di bawah Parameter Tambahan, untuk akses Baca ke direktori /sys, pilih Diaktifkan.

-

-

Untuk menjalankan dalam mode kontainer sebagai gantinya:

catatan

Kami tidak merekomendasikan untuk dijalankan dalam mode kontainer kecuali jika kasus bisnis Anda memerlukannya.

-

Tingkatkan nilai batas memori ini. Untuk menggunakan model yang disediakan dalam mode GPU, gunakan setidaknya 2000 MB.

-

Tingkatkan nilai Timeout untuk 5 menit. Ini memastikan bahwa permintaan batas waktu tidak terlalu pendek. Dibutuhkan beberapa menit setelah pengaturan untuk menjalankan inferensi.

-

Untuk Pinned, pilih True.

-

Di bawah Parameter Tambahan, untuk akses Baca ke direktori /sys, pilih Diaktifkan.

-

-

-

Tambahkan sumber daya model Neo-dioptimalisasi Anda ke grup. Unggah model sumber daya di direktori

resnet18dari paket sampel yang Anda unzipped di Langkah 3: Buat fungsi Lambda inferensi. Direktori ini berisi artefak model precompiled untuk model klasifikasi citra terlatih dengan Resnet-18. Ikuti prosedur di Langkah 5: Tambahkan sumber daya model SageMaker AI NEO yang dioptimalkan ke grup Greengrass dengan pembaruan berikut.-

Kompres file di dalam direktori

resnet18ke dalam sebuah file bernamaresnet18.zip. -

Pada halaman Buat sumber daya machine learning ini, untuk Nama sumber daya, masukkan

resnet18_model. -

Unggah

resnet18.zipfile.

-

-

Jika berjalan dalam mode containerized, tambahkan sumber daya perangkat lokal yang diperlukan untuk memberikan akses ke GPU perangkat Anda.

catatan

Jika Anda menjalankan dalam mode non-kontainer, AWS IoT Greengrass dapat mengakses GPU perangkat Anda tanpa mengonfigurasi sumber daya perangkat.

-

Pada halaman konfigurasi grup, pilih tab Sumber Daya.

-

Di bagian Sumber daya lokal, pilih Tambahkan sumber daya lokal.

-

Tentukan setiap sumber daya:

-

Untuk Nama sumber daya dan Jalur perangkat, gunakan nilai-nilai dalam tabel berikut. Buat satu sumber daya perangkat untuk setiap baris dalam tabel.

-

Untuk Jenis sumber daya, pilih Perangkat.

-

Untuk pemilik grup sistem dan izin akses file, pilih Secara otomatis menambahkan izin sistem file dari grup sistem yang memiliki sumber daya.

Nama

Jalur perangkat

nvhost-ctrl

/dev/nvhost-ctrl

nvhost-gpu

/dev/nvhost-gpu

nvhost-ctrl-gpu

/dev/ nvhost-ctrl-gpu

nvhost-dbg-gpu

/dev/ nvhost-dbg-gpu

nvhost-prof-gpu

/dev/ nvhost-prof-gpu

nvmap

/dev/nvmap

nvhost-vic

/dev/nvhost-vic

tegra_dc_ctrl

/dev/tegra_dc_ctrl

-

-

-

Jika berjalan dalam mode kontainerisasi, tambahkan sumber daya volume lokal berikut untuk memberikan akses ke kamera perangkat Anda. Ikuti prosedur di Langkah 5: Tambahkan sumber daya model SageMaker AI NEO yang dioptimalkan ke grup Greengrass.

catatan

Jika Anda menjalankan dalam mode non-kontainer, AWS IoT Greengrass dapat mengakses kamera perangkat Anda tanpa mengonfigurasi sumber daya perangkat.

-

Untuk Jenis sumber daya, pilih Volume.

-

Untuk pemilik grup sistem dan izin akses file, pilih Secara otomatis menambahkan izin sistem file dari grup sistem yang memiliki sumber daya.

Nama

Jalur sumber

Jalur tujuan

shm

/dev/shm

/dev/shm

tmp

/tmp

/tmp

-

-

Memperbarui langganan grup Anda untuk menggunakan direktori yang benar. Ikuti prosedur di Langkah 7: Menambahkan langganan ke grup Greengrass dengan pembaruan berikut.

-

Untuk filter topik pertama Anda, masukkan

/resnet-18/predictions. -

Untuk filter topik kedua Anda, masukkan

/resnet-18/test.

-

-

Memperbarui langganan pengujian Anda untuk menggunakan direktori yang benar. Ikuti prosedur di Uji contoh inferensi dengan pembaruan berikut.

-

Untuk Langganan, pilih Berlangganan topik. Untuk Topik langganan, masukkan

/resnet-18/predictions. -

Pada

/resnet-18/predictionshalaman, tentukan/resnet-18/testtopik untuk diterbitkan ke.

-

Memecahkan masalah inferensi AWS IoT Greengrass ML

Jika tes tidak berhasil, Anda dapat mencoba langkah-langkah penyelesaian masalah berikut. Jalankan perintah di terminal Raspberry Pi Anda.

Periksa catatan error

-

Beralih ke pengguna root dan arahkan ke direktori

logtersebut. Akses ke AWS IoT Greengrass log memerlukan izin root.sudo su cd /greengrass/ggc/var/log -

Periksa

runtime.loguntuk kesalahan apa pun.cat system/runtime.log | grep 'ERROR'Anda juga dapat melihat di log fungsi Lambda ditetapkan pengguna Anda untuk setiap kesalahan:

cat user/your-region/your-account-id/lambda-function-name.log | grep 'ERROR'Untuk informasi selengkapnya, lihat Pemecahan masalah dengan catatan.

Verifikasi fungsi Lambda berhasil di-deploy

-

Daftar isi dari Lambda yang di-deploy di

/lambdadirektori. Mengganti nilai placeholder sebelum Anda menjalankan perintah.cd /greengrass/ggc/deployment/lambda/arn:aws:lambda:region:account:function:function-name:function-versionls -la -

Verifikasi bahwa direktori berisi konten yang sama sebagai paket deployment

optimizedImageClassification.zipyang Anda unggah di Langkah 3: Buat fungsi Lambda inferensi.Pastikan bahwa

.pyfile dan dependensi berada di root direktori.

Verifikasi model inferensi berhasil di-deploy

-

Temukan process identification number (PID) proses waktu aktif Lambda:

ps aux | greplambda-function-namePada output, PID muncul di kolom kedua baris untuk proses waktu aktif Lambda.

-

Masukkan namespace waktu aktif Lambda. Pastikan untuk mengganti

pidnilai placeholder sebelum Anda menjalankan perintah.catatan

Direktori ini dan isinya berada di namespace waktu aktif Lambda, sehingga mereka tidak terlihat dalam namespace Linux biasa.

sudo nsenter -tpid-m /bin/bash -

Daftar isi dari direktori lokal yang Anda tentukan untuk sumber daya ML.

catatan

Jika jalur sumber daya ML Anda adalah sesuatu selain

ml_model, Anda harus mengganti yang di sini.cd /ml_model ls -lsAnda harus melihat file berikut:

56 -rw-r--r-- 1 ggc_user ggc_group 56703 Oct 29 20:07 model.json 196152 -rw-r--r-- 1 ggc_user ggc_group 200855043 Oct 29 20:08 model.params 256 -rw-r--r-- 1 ggc_user ggc_group 261848 Oct 29 20:07 model.so 32 -rw-r--r-- 1 ggc_user ggc_group 30564 Oct 29 20:08 synset.txt

Fungsi Lambda /dev/dri/renderD128

Hal ini dapat terjadi jika OpenCL tidak dapat terhubung ke perangkat GPU yang dibutuhkannya. Anda harus membuat sumber daya perangkat untuk perangkat yang diperlukan untuk fungsi Lambda Anda.

Langkah selanjutnya

Selanjutnya, jelajahi model lain yang dioptimalkan. Untuk informasi, lihat dokumentasi SageMaker AI Neo.