AWS IoT Greengrass Version 1 memasuki fase umur panjang pada 30 Juni 2023. Untuk informasi selengkapnya, lihat kebijakan AWS IoT Greengrass V1 pemeliharaan. Setelah tanggal ini, tidak AWS IoT Greengrass V1 akan merilis pembaruan yang menyediakan fitur, penyempurnaan, perbaikan bug, atau patch keamanan. Perangkat yang berjalan AWS IoT Greengrass V1 tidak akan terganggu dan akan terus beroperasi dan terhubung ke cloud. Kami sangat menyarankan Anda bermigrasi ke AWS IoT Greengrass Version 2, yang menambahkan fitur baru yang signifikan dan dukungan untuk platform tambahan.

Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Lakukan inferensi machine learning

Fitur ini tersedia untuk AWS IoT Greengrass Core v1.6 atau yang lebih baru.

Dengan AWS IoT Greengrass, Anda dapat melakukan inferensi pembelajaran mesin (ML) di edge pada data yang dihasilkan secara lokal menggunakan model terlatih cloud. Anda mendapatkan keuntungan dari latensi rendah dan penghematan biaya untuk menjalankan inferensi lokal, namun masih memanfaatkan daya komputasi cloud untuk model pelatihan dan pemrosesan yang rumit.

Untuk memulai melakukan inferensi lokal, lihat Cara mengonfigurasi inferensi machine learning menggunakan AWS Management Console.

Cara kerja inferensi AWS IoT Greengrass ML

Anda dapat melatih model inferensi Anda di mana saja, men-deploy secara lokal sebagai sumber daya machine learning di grup Greengrass, dan kemudian mengaksesnya dari fungsi Greengrass Lambda. Misalnya, Anda dapat membangun dan melatih model pembelajaran mendalam di SageMaker AI

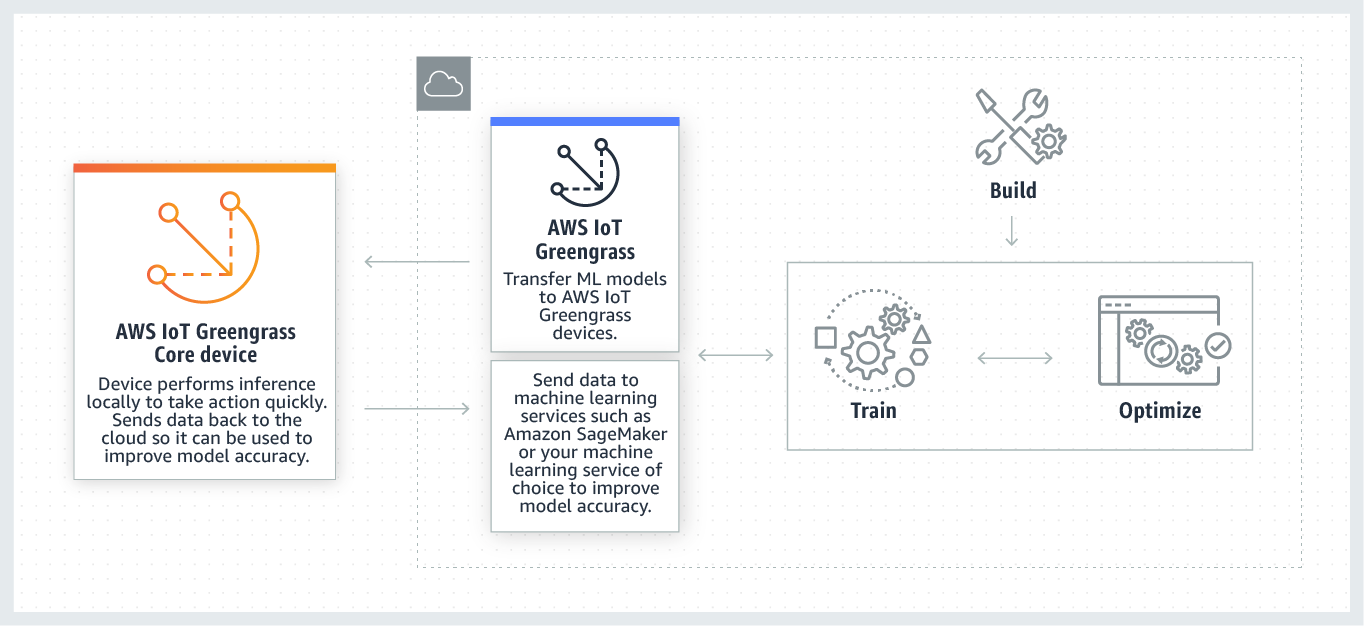

Diagram berikut menunjukkan alur kerja inferensi AWS IoT Greengrass ML.

AWS IoT Greengrass Inferensi ML menyederhanakan setiap langkah alur kerja ML, termasuk:

-

Membangun dan deploying prototipe kerangka ML.

-

Mengakses model cloud-trained dan deploying mereka ke perangkat Greengrass core.

-

Membuat aplikasi inferensi yang dapat mengakses akselerator perangkat keras (seperti GPUs dan FPGAs) sebagai sumber daya lokal.

Sumber daya machine learning

Sumber daya pembelajaran mesin mewakili model inferensi terlatih cloud yang digunakan ke inti. AWS IoT Greengrass Untuk men-deploy sumber daya machine learning, pertama Anda tambahkan sumber daya ke grup Greengrass, dan kemudian Anda tentukan bagaimana fungsi Lambda dalam grup dapat mengaksesnya. Selama penyebaran grup, AWS IoT Greengrass mengambil paket model sumber dari cloud dan mengekstraknya ke direktori di dalam namespace runtime Lambda. Kemudian, fungsi Greengrass Lambda menggunakan model lokal di-deploy untuk melakukan inferensi.

Untuk memperbarui model lokal yang di-deploy, pertama perbarui model sumber (di cloud) yang sesuai dengan sumber daya machine learning, dan kemudian men-deploy grup. Selama deployment, AWS IoT Greengrass memeriksa sumber untuk perubahan. Jika perubahan terdeteksi, maka AWS IoT Greengrass perbarui model lokal.

Sumber model yang didukung

AWS IoT Greengrass mendukung sumber model SageMaker AI dan Amazon S3 untuk sumber daya pembelajaran mesin.

Persyaratan berikut berlaku untuk sumber model:

-

Bucket S3 yang menyimpan sumber model SageMaker AI dan Amazon S3 Anda tidak boleh dienkripsi menggunakan SSE-C. Untuk bucket yang menggunakan enkripsi sisi server, inferensi AWS IoT Greengrass ML saat ini hanya mendukung opsi enkripsi SSE-S3 atau SSE-KMS. Untuk informasi selengkapnya tentang opsi enkripsi sisi server, lihat Melindungi data menggunakan enkripsi sisi server di Panduan Pengguna Layanan Penyimpanan Sederhana Amazon.

-

Nama-nama bucket S3 yang menyimpan sumber model SageMaker AI dan Amazon S3 Anda tidak boleh menyertakan period ().

.Untuk informasi selengkapnya, lihat aturan tentang penggunaan bucket gaya hosted virtual dengan SSL di Aturan untuk penamaan bucket di Panduan Pengguna Layanan Penyimpanan Sederhana Amazon. -

Wilayah AWS Dukungan tingkat layanan harus tersedia untuk keduanya AWS IoT Greengrassdan SageMaker AI. Saat ini, AWS IoT Greengrass mendukung model SageMaker AI di Wilayah berikut:

-

AS Timur (Ohio)

-

AS Timur (Virginia Utara)

-

US West (Oregon)

-

Asia Pasifik (Mumbai)

-

Asia Pasifik (Seoul)

-

Asia Pasifik (Singapura)

-

Asia Pasifik (Sydney)

-

Asia Pasifik (Tokyo)

-

Eropa (Frankfurt)

-

Eropa (Irlandia)

-

Eropa (London)

-

-

AWS IoT Greengrass harus memiliki

readizin ke sumber model, seperti yang dijelaskan di bagian berikut.

- SageMaker AI

-

AWS IoT Greengrass mendukung model yang disimpan sebagai pekerjaan pelatihan SageMaker AI. SageMaker AI adalah layanan ML yang dikelola sepenuhnya yang dapat Anda gunakan untuk membangun dan melatih model menggunakan algoritme bawaan atau kustom. Untuk informasi lebih lanjut, lihat Apa itu SageMaker AI? di Panduan Pengembang SageMaker AI.

Jika Anda mengonfigurasi lingkungan SageMaker AI Anda dengan membuat bucket yang namanya berisi

sagemaker, maka AWS IoT Greengrass memiliki izin yang cukup untuk mengakses pekerjaan pelatihan SageMaker AI Anda. Kebijakan terkelolaAWSGreengrassResourceAccessRolePolicymengizinkan akses ke bucket yang namanya berisi stringsagemaker. Kebijakan ini terlampir pada peran layanan Greengrass.Jika tidak, Anda harus memberikan AWS IoT Greengrass

readizin ke ember tempat pekerjaan pelatihan Anda disimpan. Untuk melakukannya, menanamkan kebijakan inline berikut di peran layanan. Anda dapat membuat daftar beberapa ember ARNs.{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:GetObject" ], "Resource": [ "arn:aws:s3:::amzn-s3-demo-bucket" ] } ] } - Amazon S3

-

AWS IoT Greengrass mendukung model yang disimpan di Amazon S3 sebagai

tar.gzatau.zipfile.AWS IoT Greengrass Untuk mengaktifkan mengakses model yang disimpan di bucket Amazon S3, Anda harus memberikan AWS IoT Greengrass

readizin untuk mengakses bucket dengan melakukan salah satu hal berikut:-

Simpan model Anda dalam bucket yang namanya berisi

greengrass.Kebijakan terkelola

AWSGreengrassResourceAccessRolePolicymengizinkan akses ke bucket yang namanya berisi stringgreengrass. Kebijakan ini terlampir pada peran layanan Greengrass. -

Menanam kebijakan inline di peran layanan Greengrass.

Jika nama bucket Anda tidak berisi

greengrass, tambahkan kebijakan inline berikut untuk peran layanan. Anda dapat membuat daftar beberapa ember ARNs.{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:GetObject" ], "Resource": [ "arn:aws:s3:::amzn-s3-demo-bucket" ] } ] }Untuk informasi lebih lanjut, lihat. Menanamkan kebijakan inline dalam Panduan Pengguna IAM.

-

Persyaratan

Persyaratan berikut berlaku untuk membuat dan menggunakan sumber daya machine learning:

-

Anda harus menggunakan AWS IoT Greengrass Core v1.6 atau yang lebih baru.

-

Fungsi Lambda yang ditetapkan pengguna dapat melakukan operasi

readatauread and writepada sumber daya. Izin untuk operasi lain tidak tersedia. Mode kontainerisasi fungsi Lambda berafiliasi menentukan bagaimana Anda mengatur izin akses. Untuk informasi selengkapnya, lihat Mengakses sumber daya machine learning dari fungsi Lambda. -

Anda harus menyediakan jalur penuh sumber daya pada sistem operasi perangkat core.

-

Nama sumber daya atau ID memiliki panjang maksimum 128 karakter dan harus menggunakan pola

[a-zA-Z0-9:_-]+.

Waktu aktif dan perpustakaan untuk inferensi ML

Anda dapat menggunakan runtime dan pustaka HTML berikut dengan. AWS IoT Greengrass

-

Apache MXNet

-

TensorFlow

Runtime dan pustaka ini dapat diinstal pada platform NVIDIA Jetson TX2, Intel Atom, dan Raspberry Pi. Untuk informasi unduhan, lihat Waktu aktif dan perpustakaan machine learning yang didukung. Anda dapat menginstalnya langsung di perangkat core Anda.

Pastikan untuk membaca informasi berikut tentang kompatibilitas dan keterbatasan.

SageMaker Runtime pembelajaran mendalam AI Neo

Anda dapat menggunakan runtime pembelajaran mendalam SageMaker AI Neo untuk melakukan inferensi dengan model pembelajaran mesin yang dioptimalkan di perangkat Anda AWS IoT Greengrass . Model-model ini dioptimalkan menggunakan kompiler pembelajaran mendalam SageMaker AI Neo untuk meningkatkan kecepatan prediksi inferensi pembelajaran mesin. Untuk informasi lebih lanjut tentang pengoptimalan model di SageMaker AI, lihat dokumentasi SageMaker AI Neo.

catatan

Saat ini, Anda dapat mengoptimalkan model machine learning menggunakan kompilator Neo deep learning di Amazon Web Services Region tertentu saja. Namun, Anda dapat menggunakan runtime pembelajaran mendalam Neo dengan model yang dioptimalkan di masing-masing Wilayah AWS tempat AWS IoT Greengrass inti didukung. Untuk informasi lebih lanjut, lihat Cara Mengonfigurasi Inferensi Machine Learning yang Dioptimalkan.

MXNet pembuatan versi

Apache saat ini MXNet tidak memastikan kompatibilitas ke depan, jadi model yang Anda latih menggunakan versi kerangka kerja yang lebih baru mungkin tidak berfungsi dengan baik di versi kerangka kerja yang lebih lama. Untuk menghindari konflik antara tahapan pelatihan model dan penyajian model, dan untuk memberikan end-to-end pengalaman yang konsisten, gunakan versi MXNet kerangka kerja yang sama di kedua tahap.

MXNet pada Raspberry Pi

Fungsi Greengrass Lambda yang mengakses model MXNet lokal harus mengatur variabel lingkungan berikut:

MXNET_ENGINE_TYPE=NativeEngine

Anda dapat mengatur variabel lingkungan dalam kode fungsi atau menambahkannya ke konfigurasi grup spesifik fungsi ini. Untuk contoh yang menambahkannya sebagai pengaturan konfigurasi, lihat langkah.

catatan

Untuk penggunaan umum MXNet kerangka kerja, seperti menjalankan contoh kode pihak ketiga, variabel lingkungan harus dikonfigurasi pada Raspberry Pi.

TensorFlow batasan penyajian model pada Raspberry Pi

Rekomendasi berikut untuk meningkatkan hasil inferensi didasarkan pada pengujian kami dengan pustaka Arm TensorFlow 32-bit pada platform Raspberry Pi. Rekomendasi ini ditujukan untuk pengguna tingkat lanjut untuk referensi saja, tanpa jaminan apa pun.

-

Model yang dilatih menggunakan Titik pemeriksaan

format harus "dibekukan" ke format penyangga protokol sebelum disajikan. Sebagai contoh, lihat perpustakaan model klasifikasi gambar TensorFlow -Slim . -

Jangan gunakan TF-estimator dan perpustakaan TF-slim baik pelatihan atau kode inferensi. Sebagai gantinya, gunakan

.pbpola pemuatan model file yang ditunjukkan dalam contoh berikut.graph = tf.Graph() graph_def = tf.GraphDef() graph_def.ParseFromString(pb_file.read()) with graph.as_default(): tf.import_graph_def(graph_def)

catatan

Untuk informasi selengkapnya tentang platform yang didukung TensorFlow, lihat Menginstal TensorFlow