Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Archivia automaticamente gli elementi su Amazon S3 utilizzando DynamoDB TTL

Creato da Tabby Ward (AWS)

Riepilogo

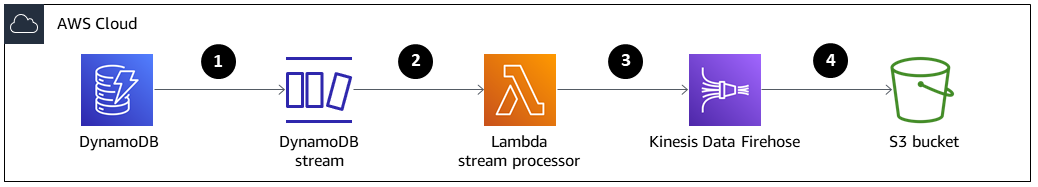

Questo modello fornisce i passaggi per rimuovere i dati più vecchi da una tabella Amazon DynamoDB e archiviarli in un bucket Amazon Simple Storage Service (Amazon S3) su Amazon Web Services (AWS) senza dover gestire una flotta di server.

Questo modello utilizza Amazon DynamoDB Time to Live (TTL) per eliminare automaticamente i vecchi elementi e Amazon DynamoDB Streams per acquisire gli elementi TTL scaduti. Quindi collega DynamoDB Streams ad AWS Lambda, che esegue il codice senza effettuare il provisioning o gestire alcun server.

Quando vengono aggiunti nuovi elementi al flusso DynamoDB, viene avviata la funzione Lambda e scrive i dati in un flusso di distribuzione Amazon Data Firehose. Firehose offre una soluzione semplice e completamente gestita per caricare i dati come archivio in Amazon S3.

DynamoDB viene spesso utilizzato per archiviare dati di serie temporali, come dati click-stream di pagine Web o dati Internet of Things (IoT) provenienti da sensori e dispositivi connessi. Invece di eliminare gli elementi a cui si accede meno frequentemente, molti clienti desiderano archiviarli per scopi di controllo. TTL semplifica questa archiviazione eliminando automaticamente gli elementi in base all'attributo timestamp.

Gli elementi eliminati tramite TTL possono essere identificati in DynamoDB Streams, che acquisisce una sequenza di modifiche a livello di elemento ordinata nel tempo e archivia la sequenza in un registro per un massimo di 24 ore. Questi dati possono essere utilizzati da una funzione Lambda e archiviati in un bucket Amazon S3 per ridurre i costi di storage. Per ridurre ulteriormente i costi, è possibile creare regole del ciclo di vita di Amazon S3 per trasferire automaticamente i dati (non appena vengono creati) a classi di storage

Prerequisiti e limitazioni

Prerequisiti

Un account AWS attivo.

AWS Command Line Interface (AWS CLI) 1.7 o versione successiva, installata e configurata su macOS, Linux o Windows.

Python 3.7

o successivo. Boto3

, installato e configurato. Se Boto3 non è già installato, esegui il python -m pip install boto3comando per installarlo.

Architettura

Stack tecnologico

Amazon DynamoDB

Amazon DynamoDB Streams

Amazon Data Firehose

AWS Lambda

Amazon S3

Gli elementi vengono eliminati tramite TTL.

Il trigger di flusso DynamoDB richiama la funzione del processore di flusso Lambda.

La funzione Lambda inserisce i record nel flusso di distribuzione di Firehose in formato batch.

I record di dati vengono archiviati nel bucket S3.

Strumenti

AWS CLI: l'AWS Command Line Interface (AWS CLI) è uno strumento unificato per gestire i servizi AWS.

Amazon DynamoDB: Amazon DynamoDB è un database di chiave-valore e documenti che offre prestazioni a una cifra in millisecondi su qualsiasi scala.

Amazon DynamoDB Time to Live (TTL): Amazon DynamoDB TTL ti aiuta a definire un timestamp per articolo per determinare quando un articolo non è più necessario.

Amazon DynamoDB Streams — Amazon DynamoDB Streams acquisisce una sequenza ordinata nel tempo di modifiche a livello di elemento in qualsiasi tabella DynamoDB e archivia queste informazioni in un registro per un massimo di 24 ore.

Amazon Data Firehose — Amazon Data Firehose è il modo più semplice per caricare in modo affidabile lo streaming di dati in data lake, data store e servizi di analisi.

AWS Lambda: AWS Lambda esegue codice senza la necessità di effettuare il provisioning o gestire server. I costi saranno calcolati in base al tempo di elaborazione effettivo.

Amazon S3 — Amazon Simple Storage Service (Amazon S3) è un servizio di storage di oggetti che offre scalabilità, disponibilità dei dati, sicurezza e prestazioni leader del settore.

Codice

Il codice per questo modello è disponibile nel repository GitHub Archive items to S3 using DynamoDB TTL

Epiche

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Creazione di una tabella DynamoDB | Utilizza l'AWS CLI per creare una tabella in DynamoDB chiamata.

| Architetto del cloud, sviluppatore di app |

Attiva DynamoDB TTL. | Utilizza l'AWS CLI per attivare DynamoDB TTL per l'attributo.

| Architetto del cloud, sviluppatore di app |

Attiva uno stream DynamoDB. | Utilizza l'AWS CLI per attivare un flusso DynamoDB per la

Questo flusso conterrà i record relativi a nuovi elementi, elementi aggiornati, elementi eliminati e elementi eliminati tramite TTL. I record relativi agli elementi eliminati tramite TTL contengono un attributo di metadati aggiuntivo per distinguerli dagli elementi eliminati manualmente. Il In questo modello, vengono archiviati solo gli elementi eliminati da TTL, ma è possibile archiviare solo i record in cui | Architetto del cloud, sviluppatore di app |

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Crea un bucket S3. | Utilizza l'AWS CLI per creare un bucket S3 di destinazione nella tua regione AWS, sostituendolo

Assicurati che il nome del tuo bucket S3 sia unico a livello globale, poiché lo spazio dei nomi è condiviso da tutti gli account AWS. | Architetto del cloud, sviluppatore di app |

Crea una politica del ciclo di vita di 30 giorni per il bucket S3. |

| Architetto del cloud, sviluppatore di app |

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Crea e configura un flusso di distribuzione Firehose. | Scarica e modifica l'esempio di Questo codice è scritto in Python e mostra come creare un flusso di distribuzione Firehose e un ruolo AWS Identity and Access Management (IAM). Il ruolo IAM avrà una policy che può essere utilizzata da Firehose per scrivere nel bucket S3 di destinazione. Per eseguire lo script, utilizzate i seguenti argomenti di comando e riga di comando. Argomento 1= Argomento 2= Il nome del tuo Firehose (questo pilota lo sta Argomento 3= Il nome del ruolo IAM (questo programma pilota lo utilizza).

Se il ruolo IAM specificato non esiste, lo script creerà un ruolo di assunzione con una politica di relazione affidabile, nonché una politica che concede autorizzazioni Amazon S3 sufficienti. Per esempi di queste politiche, consulta la sezione Informazioni aggiuntive. | Architetto del cloud, sviluppatore di app |

Verifica il flusso di distribuzione di Firehose. | Descrivi il flusso di distribuzione di Firehose utilizzando la CLI di AWS per verificare che il flusso di distribuzione sia stato creato correttamente.

| Architetto del cloud, sviluppatore di app |

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Crea una politica di fiducia per la funzione Lambda. | Crea un file di criteri di fiducia con le seguenti informazioni.

Ciò consente alla funzione di accedere alle risorse AWS. | Architetto del cloud, sviluppatore di app |

Crea un ruolo di esecuzione per la funzione Lambda. | Per creare il ruolo di esecuzione, esegui il codice seguente.

| Architetto del cloud, sviluppatore di app |

Aggiungi l'autorizzazione al ruolo. | Per aggiungere l'autorizzazione al ruolo, usa il

| Architetto del cloud, sviluppatore di app |

Creazione di una funzione Lambda. | Comprimi il

Quando crei la funzione Lambda, avrai bisogno del ruolo di esecuzione Lambda ARN. Per ottenere l'ARN, esegui il codice seguente.

Per creare la funzione Lambda, esegui il codice seguente.

| Architetto del cloud, sviluppatore di app |

Configura il trigger della funzione Lambda. | Utilizza l'AWS CLI per configurare il trigger (DynamoDB Streams), che richiama la funzione Lambda. La dimensione del batch di 400 serve per evitare problemi di concorrenza Lambda.

| Architetto del cloud, sviluppatore di app |

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Aggiungi articoli con timestamp scaduti alla tabella delle prenotazioni. | Per testare la funzionalità, aggiungi alla tabella elementi con timestamp d'epoca scaduti. La funzione Lambda viene avviata sulle attività di DynamoDB Stream e filtra l'evento per identificare l'attività o gli elementi eliminati. Il flusso di distribuzione Firehose trasferisce gli articoli a un bucket S3 di destinazione con il prefisso. ImportantePer ottimizzare il recupero dei dati, configura Amazon S3 con | Architetto del cloud |

| Attività | Descrizione | Competenze richieste |

|---|---|---|

Eliminare tutte le risorse. | Elimina tutte le risorse per assicurarti che non ti vengano addebitati costi per i servizi che non utilizzi. | Architetto del cloud, sviluppatore di app |

Risorse correlate

Informazioni aggiuntive

Creare e configurare un flusso di distribuzione Firehose — Esempi di policy

Documento di esempio sulla politica delle relazioni di fiducia di Firehose

firehose_assume_role = { 'Version': '2012-10-17', 'Statement': [ { 'Sid': '', 'Effect': 'Allow', 'Principal': { 'Service': 'firehose.amazonaws.com' }, 'Action': 'sts:AssumeRole' } ] }

Esempio di politica di autorizzazione S3

s3_access = { "Version": "2012-10-17", "Statement": [ { "Sid": "", "Effect": "Allow", "Action": [ "s3:AbortMultipartUpload", "s3:GetBucketLocation", "s3:GetObject", "s3:ListBucket", "s3:ListBucketMultipartUploads", "s3:PutObject" ], "Resource": [ "{your s3_bucket ARN}/*", "{Your s3 bucket ARN}" ] } ] }

Verifica la funzionalità: configurazione Amazon S3

La configurazione Amazon S3 con la seguente Prefix e ErrorOutputPrefix viene scelta per ottimizzare il recupero dei dati.

prefisso

firehosetos3example/year=! {timestamp: yyyy}/month=! {timestamp:MM}/day=! {timestamp:dd}/hour=!{timestamp:HH}/

Firehose crea innanzitutto una cartella di base chiamata firehosetos3example direttamente sotto il bucket S3. Quindi valuta le espressioni e l'anno !{timestamp:yyyy}!{timestamp:MM}, il mese!{timestamp:dd}, !{timestamp:HH} il giorno e l'ora utilizzando il formato Java. DateTimeFormatter

Ad esempio, un timestamp di arrivo approssimativo di 1604683577 in Unix epoch Time restituisce,, e. year=2020 month=11 day=06 hour=05 Pertanto, viene valutata la posizione in Amazon S3, in cui vengono distribuiti i record di dati. firehosetos3example/year=2020/month=11/day=06/hour=05/

ErrorOutputPrefix

firehosetos3erroroutputbase/!{firehose:random-string}/!{firehose:error-output-type}/!{timestamp:yyyy/MM/dd}/

I ErrorOutputPrefix risultati sono in una cartella di base richiamata firehosetos3erroroutputbase direttamente sotto il bucket S3. L'espressione !{firehose:random-string} restituisce una stringa casuale di 11 caratteri come. ztWxkdg3Thg Potrebbe essere valutata la posizione di un oggetto Amazon S3 in cui vengono consegnati i record non riusciti. firehosetos3erroroutputbase/ztWxkdg3Thg/processing-failed/2020/11/06/