이 페이지 개선에 도움 주기

이 사용자 가이드에 기여하려면 모든 페이지의 오른쪽 창에 있는 GitHub에서 이 페이지 편집 링크를 선택합니다.

사용자 지정 네트워킹을 통해 대체 서브넷에 포드 배포

적용 대상: Linux IPv4 Fargate 노드, Amazon EC2 인스턴스가 있는 Linux 노드

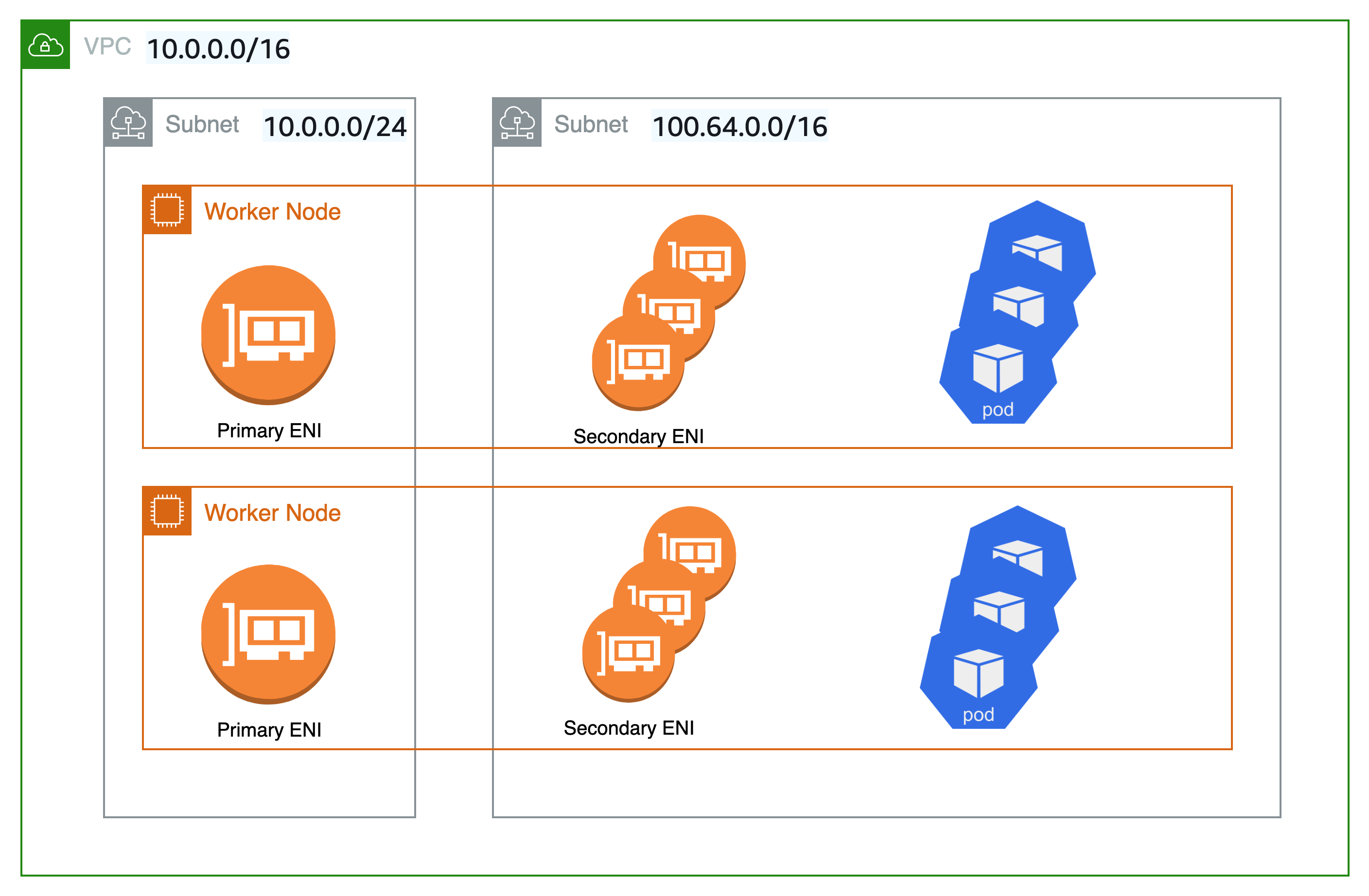

기본적으로 Kubernetes용 Amazon VPC CNI 플러그인은 Amazon EC2 노드의 보조 Elastic 네트워크 인터페이스(네트워크 인터페이스)를 생성하는 경우 노드의 기본 네트워크 인터페이스와 동일한 서브넷에서 생성합니다. 또한 기본 네트워크 인터페이스에 연결된 보조 네트워크 인터페이스에 동일한 보안 그룹을 연결합니다. 다음 중 하나 이상의 이유로 플러그 인이 다른 서브넷에서 보조 네트워크 인터페이스를 생성하거나 다른 보안 그룹을 보조 네트워크 인터페이스에 연결하거나, 둘 다 하려고 할 수 있습니다.

-

기본 네트워크 인터페이스가 있는 서브넷에서 사용할 수 있는

IPv4주소의 수는 제한되어 있습니다. 이렇게 하면 서브넷에서 생성할 수 있는 포드 수가 제한될 수 있습니다. 보조 네트워크 인터페이스에 다른 서브넷을 사용하면 포드에 사용 가능한IPv4주소 수를 늘릴 수 있습니다. -

보안상의 이유로 포드는 노드의 기본 네트워크 인터페이스와 다른 서브넷 또는 보안 그룹을 사용해야 할 수 있습니다.

-

노드는 퍼블릭 서브넷에서 구성되며, 포드를 프라이빗 서브넷에 배치할 수 있습니다. 퍼블릭 서브넷과 연결된 라우팅 테이블에는 인터넷 게이트웨이로 가는 경로가 포함됩니다. 프라이빗 서브넷과 연결된 라우팅 테이블에는 인터넷 게이트웨이로 가는 경로가 포함되지 않습니다.

작은 정보

사용자 지정 네트워킹을 사용하지 않고 Amazon EKS 클러스터에 직접 새 서브넷 또는 기존 서브넷을 추가할 수도 있습니다. 자세한 내용은 관리 콘솔에서 Amazon EKS 클러스터에 기존 VPC 서브넷 추가 단원을 참조하십시오.

고려 사항

다음은 기능 사용 시 고려 사항입니다.

-

사용자 지정 네트워킹을 사용 설정하면 기본 네트워크 인터페이스에 할당된 IP 주소가 포드에 할당되지 않습니다. 보조 네트워크 인터페이스의 IP 주소만 포드에 할당됩니다.

-

클러스터에서

IPv6패밀리를 사용하는 경우 사용자 지정 네트워킹을 사용할 수 없습니다. -

사용자 지정 네트워킹을 사용하여

IPv4주소 소모를 완화하려는 경우 대신IPv6패밀리를 사용하여 클러스터를 생성할 수 있습니다. 자세한 내용은 클러스터, 포드 및 서비스에 대한 IPv6 주소에 대해 알아보기 단원을 참조하십시오. -

보조 네트워크 인터페이스에 지정된 서브넷에 배포된 포드는 노드의 기본 네트워크 인터페이스와 다른 서브넷 및 보안 그룹을 사용할 수 있다고 해도 서브넷과 보안 그룹은 노드와 동일한 VPC에 있어야 합니다.

-

Fargate의 경우 서브넷은 Fargate 프로필을 통해 제어됩니다. 자세한 내용은 시작 시 AWS Fargate를 사용하는 포드 정의 섹션을 참조하세요.