AWS IoT Greengrass Version 1 於 2023 年 6 月 30 日進入延長生命週期階段。如需詳細資訊,請參閱 AWS IoT Greengrass V1 維護政策。在此日期之後, AWS IoT Greengrass V1 不會發佈提供功能、增強功能、錯誤修正或安全性修補程式的更新。在 上執行的裝置 AWS IoT Greengrass V1 不會中斷,且會繼續運作並連線至雲端。我們強烈建議您遷移至 AWS IoT Greengrass Version 2 ,這會新增重要的新功能,並支援其他平台。

本文為英文版的機器翻譯版本,如內容有任何歧義或不一致之處,概以英文版為準。

執行機器學習推論

此功能適用於 AWS IoT Greengrass Core v1.6 或更新版本。

使用 AWS IoT Greengrass,您可以使用雲端訓練模型,在本機產生的資料上執行邊緣機器學習 (ML) 推論。您可以從低延遲時間和節省執行本機推論成本中獲益,但仍同時充分利用雲端運算能力進行訓練模型和處理複雜地處理。

若要取得已執行的本機推論,請參閱 如何設定使用 AWS Management Console機器學習推論。

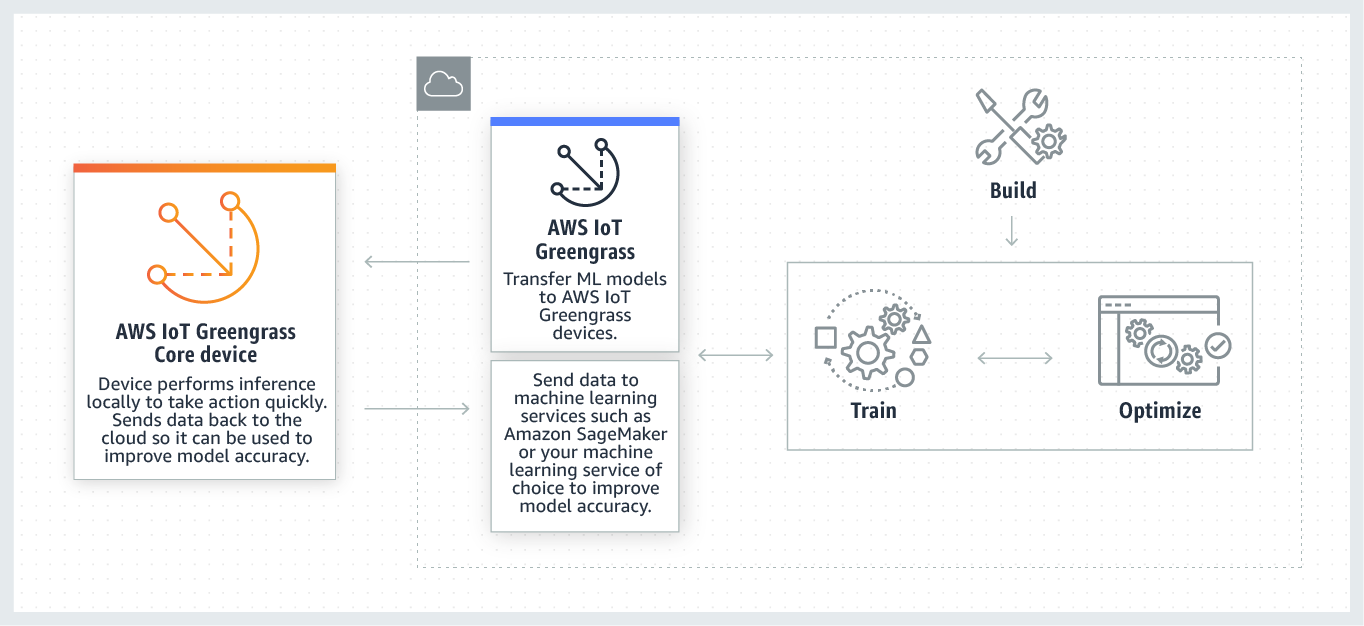

AWS IoT Greengrass ML 推論的運作方式

您可以在任何位置訓練推論模型,將其部署為 Greengrass 群組中的機器學習資源,然後從 Greengrass Lambda 函數存取。例如,您可以在 SageMaker AI

下圖顯示 AWS IoT Greengrass ML 推論工作流程。

AWS IoT Greengrass ML 推論可簡化 ML 工作流程的每個步驟,包括:

-

建立和部署 Machine Learning 架構的原型。

-

存取雲端訓練模型和將其部署到 Greengrass 核心裝置。

-

建立可以存取硬體 Accelerator (例如 GPU 和 FPGA) 做為本機資源的推論應用程式。

機器學習資源

機器學習資源代表部署到 AWS IoT Greengrass 核心的雲端訓練推論模型。若要部署機器學習資源,請先將資源新增至 Greengrass 群組,然後定義群組中的 Lambda 函數如何存取這些資源。在群組部署期間, 從雲端 AWS IoT Greengrass 擷取來源模型套件,並將其擷取至 Lambda 執行時間命名空間內的目錄。然後,Greengrass Lambda 函數會使用本機部署的模型來執行推論。

若要更新本機部署模型,首先,請更新對應到 machine learning 資源的來源模型 (在雲端中),然後部署群組。在部署期間, AWS IoT Greengrass 會檢查來源是否有變更。如果偵測到變更,則 會 AWS IoT Greengrass 更新本機模型。

支援的模型來源

AWS IoT Greengrass 支援機器學習資源的 SageMaker AI 和 Amazon S3 模型來源。

以下要求適用於模型來源:

-

存放 SageMaker AI 和 Amazon S3 模型來源的 S3 儲存貯體不得使用 SSE-C 加密。 Amazon S3 對於使用伺服器端加密的儲存貯體, AWS IoT Greengrass ML 推論目前僅支援 SSE-S3 或 SSE-KMS 加密選項。如需伺服器端加密選項的詳細資訊,請參閱《Amazon Simple Storage Service 使用者指南》中的使用伺服器端加密保護資料。

-

存放 SageMaker AI 和 Amazon S3 模型來源的 S3 儲存貯體名稱不得包含句點 (

.)。 Amazon S3 如需詳細資訊,請參閱《Amazon Simple Storage Service 使用者指南》中的將虛擬託管式儲存貯體與 SSL 搭配使用的規則。 -

AWS IoT Greengrass 和 SageMaker AI 都必須提供服務層級 AWS 區域 支援。目前, AWS IoT Greengrass 在下列區域中支援 SageMaker AI 模型:

-

美國東部 (俄亥俄)

-

美國東部 (維吉尼亞北部)

-

美國西部 (奧勒岡)

-

亞太區域 (孟買)

-

亞太區域 (首爾)

-

亞太區域 (新加坡)

-

亞太區域 (雪梨)

-

亞太區域 (東京)

-

歐洲 (法蘭克福)

-

歐洲 (愛爾蘭)

-

歐洲 (倫敦)

-

-

AWS IoT Greengrass 必須具有模型來源的

read許可,如以下各節所述。

- SageMaker AI

-

AWS IoT Greengrass 支援儲存為 SageMaker AI 訓練任務的模型。SageMaker AI 是一種全受管 ML 服務,您可以使用內建或自訂演算法來建置和訓練模型。如需詳細資訊,請參閱《SageMaker AI 開發人員指南》中的什麼是 SageMaker AI?。 SageMaker

如果您透過建立名稱包含 的儲存貯體來設定 SageMaker AI 環境

sagemaker,則 AWS IoT Greengrass 具有足夠的許可來存取 SageMaker AI 訓練任務。由政策受管的AWSGreengrassResourceAccessRolePolicy允許存取名稱含有sagemaker字串的儲存貯體。此政策附屬於 Greengrass 服務角色。否則,您必須授予 AWS IoT Greengrass

read儲存貯體許可,以存放訓練任務。若要這樣做,請在服務角色中內嵌下列政策。您可以列出多個儲存貯體 ARN。{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:GetObject" ], "Resource": [ "arn:aws:s3:::amzn-s3-demo-bucket" ] } ] } - Amazon Simple Storage Service (Amazon S3)

-

AWS IoT Greengrass 支援以

tar.gz或.zip檔案儲存在 Amazon S3 中的模型。若要讓 AWS IoT Greengrass 存取存放在 Amazon S3 儲存貯體中的模型,您必須執行下列其中一項動作,授予存取儲存貯體的 AWS IoT Greengrass

read許可:-

存放模型於名稱含有

greengrass的儲存貯體中。由政策受管的

AWSGreengrassResourceAccessRolePolicy允許存取名稱含有greengrass字串的儲存貯體。此政策附屬於 Greengrass 服務角色。 -

在 Greengrass 服務角色中內嵌政策。

如果您的儲存貯體名稱不包含

greengrass,請將以下內嵌政策新增到服務角色中。您可以列出多個儲存貯體 ARN。{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:GetObject" ], "Resource": [ "arn:aws:s3:::amzn-s3-demo-bucket" ] } ] }如需詳細資訊,請參閱《IAM 使用者指南》中的內嵌內嵌政策。

-

要求

以下要求適用於建立和使用 machine learning 資源:

-

您必須使用 AWS IoT Greengrass Core v1.6 或更新版本。

-

使用者定義的 Lambda 函數可以對資源執行

read或read and write操作。不提供其他操作的權限。附屬 Lambda 函數的容器化模式會決定您如何設定存取許可。如需詳細資訊,請參閱從 Lambda 函數存取機器學習資源。 -

在 Greengrass 核心裝置的作業系統中,您必須提供完整的資源路徑。

-

資源名稱或 ID 字元達最大限制 128 個字元時,必須使用模式

[a-zA-Z0-9:_-]+。

適用於 ML 推論的執行時間和程式庫

您可以使用下列 ML 執行時間和程式庫 AWS IoT Greengrass。

-

Apache MXNet

-

TensorFlow

這些執行時間和程式庫可以安裝在 NVIDIA Jetson TX2、Intel Atom 和 Raspberry Pi 平台上。如需下載資訊,請參閱 支援的 Machine Learning 執行時間和程式庫。您可以將其直接安裝在核心裝置上。

請務必閱讀以下相容性和限制的內容。

SageMaker AI Neo 深度學習執行期

您可以使用 SageMaker AI Neo 深度學習執行期,在 AWS IoT Greengrass 裝置上透過最佳化的機器學習模型執行推論。這些模型是使用 SageMaker AI Neo 深度學習編譯器進行最佳化,以改善機器學習推論預測速度。如需 SageMaker AI 中模型最佳化的詳細資訊,請參閱 SageMaker AI Neo 文件。

注意

目前,您只能在特定 Amazon Web Services 區域中使用 Neo 深度學習編譯器來最佳化機器學習模型。不過,您可以在支援 AWS IoT Greengrass 核心的每個 AWS 區域 中使用 Neo 深度學習執行時間搭配最佳化模型。如需詳細資訊,請參閱如何設定最佳化的機器學習推論。

MXNet 版本控制

Apache MXNet 目前不保證支援正向相容性,因此您使用較新的架構版本訓練模型時,可能會比使用舊版不順。為了避免模型訓練與模型服務階段兩者間的衝突,以及提供一致的端對端體驗,請在這兩者階段使用相同的 MXNet 架構版本。

在 Raspberry Pi 中的 MXNet

存取本機 MXNet 模型的 Greengrass Lambda 函數必須設定下列環境變數:

MXNET_ENGINE_TYPE=NativeEngine

您可以在函數程式碼中設定環境變數,或將其新增至特定群組函數的組態中。如需將其新增為組態設定的範例,請參閱步驟。

注意

對於一般使用 MXNet 架構來說,如執行第三方程式碼範例,其環境變數必須設定在 Raspberry Pi 中。

在 Raspberry Pi 上的 TensorFlow 模型服務限制

以下是根據我們在 Raspberry Pi 平台上測試 TensorFlow 32 位元 Arm 程式庫所得結果而推論出來的改善建議。這些建議僅供進階使用者參考,不具任何保證。

-

使用 檢查點

格式訓練的模型應在服務之前「凍結」為協定緩衝區格式。如需範例,請參閱 TensorFlow-Slim 映像分類模型程式庫 。 -

請勿在訓練或推論程式碼中使用 TF-Estimator 和 TF-Slim 程式庫。反之,請使用

.pb檔案模型載入模式,如下列範例所示。graph = tf.Graph() graph_def = tf.GraphDef() graph_def.ParseFromString(pb_file.read()) with graph.as_default(): tf.import_graph_def(graph_def)

注意

如需 TensorFlow 支援平台的詳細資訊,請參閱 TensorFlow 文件中的安裝 TensorFlow