AWS IoT Greengrass Version 1 trat am 30. Juni 2023 in die erweiterte Lebensphase ein. Weitere Informationen finden Sie in der AWS IoT Greengrass V1 Wartungsrichtlinie. Nach diesem Datum AWS IoT Greengrass V1 werden keine Updates mehr veröffentlicht, die Funktionen, Verbesserungen, Bugfixes oder Sicherheitspatches bieten. Geräte, die auf laufen, werden AWS IoT Greengrass V1 nicht gestört und funktionieren weiterhin und stellen eine Verbindung zur Cloud her. Wir empfehlen Ihnen dringend, zu migrieren AWS IoT Greengrass Version 2, da dies wichtige neue Funktionen und Unterstützung für zusätzliche Plattformen bietet.

Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

So konfigurieren Sie optimierte Machine Learning-Inferenz mit der AWS Management Console

Um die Schritte in diesem Tutorial ausführen zu können, müssen Sie AWS IoT Greengrass Core v1.10 oder höher verwenden.

Sie können den SageMaker AI Neo Deep Learning-Compiler verwenden, um die Prognoseeffizienz nativer Inferenzmodelle für maschinelles Lernen in Tensorflow, Apache MXNet PyTorch, ONNX und XGBoost Frameworks zu optimieren und so einen geringeren Platzbedarf und eine schnellere Leistung zu erzielen. Anschließend können Sie das optimierte Modell herunterladen, die SageMaker AI Neo Deep Learning-Runtime installieren und sie für schnellere Inferenzen auf Ihren AWS IoT Greengrass Geräten bereitstellen.

In diesem Tutorial wird beschrieben, wie Sie eine Greengrass-Gruppe für die AWS Management Console Ausführung eines Lambda-Inferenzbeispiels verwenden, das Bilder von einer Kamera lokal erkennt, ohne Daten an die Cloud zu senden. Das Inferenzbeispiel greift auf das Kameramodul auf einem Raspberry Pi zu. In diesem Tutorial laden Sie ein vorgefertigtes Modell herunter, das von Resnet-50 trainiert und im Neo Deep Learning-Compiler optimiert wurde. Anschließend verwenden Sie das Modell, um eine lokale Bildklassifizierung auf Ihrem Gerät durchzuführen. AWS IoT Greengrass

Das Tutorial enthält die folgenden allgemeinen Schritte:

Voraussetzungen

Zum Durchführen dieses Tutorials benötigen Sie Folgendes:

-

Raspberry Pi 4 Modell B oder Raspberry Pi 3 Modell B/B+, eingerichtet und konfiguriert für die Verwendung mit. AWS IoT Greengrass Um Ihren Raspberry Pi mit AWS IoT Greengrass einzurichten, führen Sie das Greengrass Device Setup-Skript aus oder stellen Sie sicher, dass Sie Modul 1 und Modul 2 von Erste Schritte mit AWS IoT Greengrass abgeschlossen haben.

Anmerkung

Der Raspberry Pi benötigt möglicherweise eine 2,5-A-Stromversorgung

, um die Deep-Learning-Frameworks auszuführen, die normalerweise für die Bildklassifizierung verwendet werden. Ein Netzteil mit einer niedrigeren Nennleistung kann dazu führen, dass das Gerät neu gestartet wird. -

Raspberry Pi Kameramodul V2 – 8 Megapixel, 1080p

. Weitere Informationen zum Einrichten der Kamera finden Sie unter Verbinden der Kamera in der Raspberry Pi-Dokumentation. -

Eine Greengrass-Gruppe und ein Greengrass Core. Weitere Informationen zum Erstellen einer Greengrass-Gruppe oder eines Greengrass-Cores finden Sie unter Erste Schritte mit AWS IoT Greengrass.

Anmerkung

Dieses Tutorial verwendet einen Raspberry Pi, AWS IoT Greengrass unterstützt aber auch andere Plattformen wie Intel Atom und NVIDIA Jetson TX2. Wenn Sie das Intel Atom-Beispiel verwenden, müssen Sie möglicherweise Python 3.6 anstelle von Python 3.7 installieren. Informationen zur Konfiguration Ihres Geräts für die Installation der AWS IoT Greengrass Core-Software finden Sie unterEinrichten anderer Geräte.

Für Plattformen von Drittanbietern, die AWS IoT Greengrass dies nicht unterstützen, müssen Sie Ihre Lambda-Funktion im Modus ohne Container ausführen. Um im Modus ohne Container ausgeführt zu werden, müssen Sie Ihre Lambda-Funktion als Root ausführen. Weitere Informationen erhalten Sie unter Überlegungen bei der Wahl der Containerisierung von Lambda-Funktionen und Einstellung der Standardzugriffsidentität für Lambda-Funktionen in einer Gruppe.

Schritt 1: Konfigurieren des Raspberry Pi

In diesem Schritt installieren Sie Updates für das Raspbian-Betriebssystem, installieren die Kameramodulsoftware und Python-Abhängigkeiten und aktivieren die Kameraschnittstelle.

Führen Sie im Raspberry Pi-Terminal die folgenden Befehle aus.

-

Installieren von Updates für Raspbian.

sudo apt-get update sudo apt-get dist-upgrade -

Installieren Sie die

picamera-Schnittstelle für das Kameramodul und andere Python-Bibliotheken, die für dieses Tutorial erforderlich sind.sudo apt-get install -y python3-dev python3-setuptools python3-pip python3-picameraÜberprüfen Sie die Installation:

-

Stellen Sie sicher, dass Ihre Python 3.7-Installation pip enthält.

python3 -m pipWenn pip nicht installiert ist, laden Sie es von der pip-Website

herunter und führen Sie dann den folgenden Befehl aus. python3 get-pip.py -

Stellen Sie sicher, dass Ihre Python-Version 3.7 oder höher ist.

python3 --versionWenn in der Ausgabe eine frühere Version aufgelistet ist, führen Sie den folgenden Befehl aus.

sudo apt-get install -y python3.7-dev -

Stellen Sie sicher, dass Setuptools und Picamera erfolgreich installiert wurden.

sudo -u ggc_user bash -c 'python3 -c "import setuptools"' sudo -u ggc_user bash -c 'python3 -c "import picamera"'Wenn die Ausgabe keine Fehler enthält, ist die Überprüfung erfolgreich.

Anmerkung

Wenn die auf Ihrem Gerät installierte ausführbare Python-Datei

python3.7ist, verwenden Siepython3.7anstelle vonpython3für die Befehle in diesem Tutorial. Stellen Sie sicher, dass Ihre pip-Installation der richtigenpython3.7- oderpython3-Version zugeordnet ist, um Abhängigkeitsfehler zu vermeiden. -

-

Starten Sie den Raspberry Pi neu.

sudo reboot -

Öffnen Sie das Raspberry Pi-Konfigurations-Tool.

sudo raspi-config -

Verwenden Sie die Pfeiltasten zum Öffnen von Interfacing Options (Verbindungsoptionen) und aktivieren Sie die Kameraschnittstelle. Wenn Sie dazu aufgefordert werden, lassen Sie den Neustart des Geräts zu.

-

Geben Sie den folgenden Befehl ein, um die Einrichtung der Kamera zu testen.

raspistill -v -o test.jpgSo werden ein Vorschaufenster im Raspberry Pi geöffnet, ein Bild mit dem Namen

test.jpgin Ihrem aktuellen Verzeichnis gespeichert und Informationen über die Kamera im Raspberry Pi-Terminal angezeigt.

Schritt 2: Installieren Sie die Amazon SageMaker Neo Deep Learning-Laufzeit

Installieren Sie in diesem Schritt die Neo Deep Learning Runtime (DLR) auf Ihrem Raspberry Pi.

Anmerkung

Wir empfehlen, Version 1.1.0 für dieses Tutorial zu installieren.

-

Melden Sie sich per Fernzugriff bei Ihrem Raspberry Pi an.

ssh pi@your-device-ip-address -

Öffnen Sie die DLR-Dokumentation, öffnen Sie Installing DLR

und suchen Sie die Wheel-URL für Raspberry Pi-Geräte. Folgen Sie dann den Anweisungen, um die DLR auf Ihrem Gerät zu installieren. Sie können beispielsweise pip verwenden: pip3 installrasp3b-wheel-url -

Überprüfen Sie nach der Installation der DLR die folgende Konfiguration:

-

Stellen Sie sicher, dass das

ggc_user-Systemkonto die DLR-Bibliothek verwenden kann.sudo -u ggc_user bash -c 'python3 -c "import dlr"' -

Stellen Sie sicher, dass sie installiert NumPy ist.

sudo -u ggc_user bash -c 'python3 -c "import numpy"'

-

Schritt 3: Erstellen Sie eine Inferenz-Lambda-Funktion

In diesem Schritt erstellen Sie ein Lambda-Funktions-Bereitstellungspaket und eine Lambda-Funktion. Veröffentlichen Sie anschließend eine Funktionsversion und erstellen einen Alias.

-

Laden Sie auf Ihrem Computer das DLR-Beispiel für Raspberry Pi von Beispiele für Machine Learning herunter.

-

Entpacken Sie die heruntergeladene

dlr-py3-armv7l.tar.gz-Datei.cdpath-to-downloaded-sampletar -xvzf dlr-py3-armv7l.tar.gzDas

examples-Verzeichnis im extrahierten Beispielpaket enthält Funktionscode und Abhängigkeiten.-

inference.pyist der in diesem Tutorial verwendete Inferenzcode. Sie können diesen Code als Vorlage verwenden, um eine eigene Inferenzfunktion zu erstellen. -

greengrasssdkist Version 1.5.0 des AWS IoT Greengrass Core SDK für Python.Anmerkung

Wenn eine neue Version verfügbar ist, können Sie sie herunterladen und die SDK-Version in Ihrem Bereitstellungspaket aktualisieren. Weitere Informationen finden Sie unter AWS IoT Greengrass Core SDK for Python

on GitHub.

-

-

Komprimieren Sie den Inhalt des

examples-Verzeichnisses in eine Datei namensoptimizedImageClassification.zip. Dies ist Ihr Bereitstellungspaket.cdpath-to-downloaded-sample/dlr-py3-armv7l/examples zip -r optimizedImageClassification.zip .Das Bereitstellungspaket enthält den Funktionscode und die Abhängigkeiten. Dazu gehört der Code, der die Neo-Deep-Learning-Laufzeit Python aufruft, APIs um Inferenzen mit den Neo-Deep-Learning-Compilermodellen durchzuführen.

Anmerkung

Stellen Sie sicher, dass sich die

.py-Dateien und -Abhängigkeiten im Stammverzeichnis befinden. -

Fügen Sie nun die Lambda-Funktion zu Ihrer Greengrass-Gruppe hinzu.

Wählen Sie auf der Lambda-Konsolenseite Functions und anschließend Create function aus.

-

Wählen Sie Author von Grund auf neu und verwenden Sie die folgenden Werte, um Ihre Funktion zu erstellen:

-

Geben Sie für Function name (Funktionsname)

optimizedImageClassificationein. -

Wählen Sie für Runtime (Laufzeit) die Option Python 3.7 aus.

Behalten Sie für Berechtigungen die Standardeinstellung bei. Dadurch wird eine Ausführungsrolle erstellt, die grundlegende Lambda-Berechtigungen gewährt. Diese Rolle wird nicht verwendet von AWS IoT Greengrass.

-

-

Wählen Sie Funktion erstellen aus.

Laden Sie jetzt Ihr Lambda-Funktionsbereitstellungspaket hoch und registrieren Sie den Handler.

-

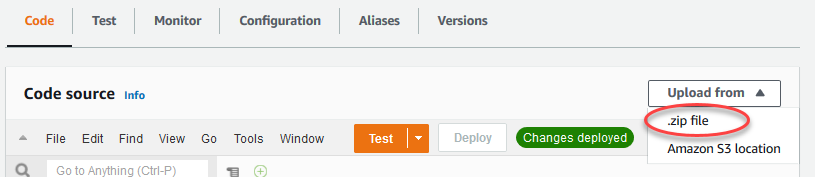

Wählen Sie auf der Registerkarte Code unter Codequelle die Option Hochladen von aus. Wählen Sie in der Dropdownliste die ZIP-Datei aus.

-

Wählen Sie Ihr

optimizedImageClassification.zipBereitstellungspaket und dann Speichern aus. -

Wählen Sie auf der Registerkarte Code für die Funktion unter Laufzeiteinstellungen die Option Bearbeiten aus, und geben Sie dann die folgenden Werte ein.

-

Wählen Sie für Runtime (Laufzeit) die Option Python 3.7 aus.

-

Geben Sie unter Handler

inference.handlerein.

Wählen Sie Save (Speichern) aus.

-

Veröffentlichen Sie als Nächstes die erste Version Ihrer Lambda-Funktion. Anschließend erstellen Sie einen Alias für die Version.

Anmerkung

Greengrass-Gruppen können eine Lambda-Funktion nach Alias (empfohlen) oder nach Version referenzieren. Die Verwendung eines Alias erleichtert die Verwaltung von Codeaktualisierungen, da Sie Ihre Abonnementtabelle oder Gruppendefinition nicht ändern müssen, wenn der Funktionscode aktualisiert wird. Stattdessen verweisen Sie einfach mit dem Alias auf die neue Funktionsversion.

-

Wählen Sie im Menü Actions die Option Publish new version aus.

-

Geben Sie unter Version description (Versionsbeschreibung) den Wert

First versionein und wählen Sie dann Publish (Veröffentlichen) aus. -

Wählen Sie auf der Konfigurationsseite optimizedImageClassification: 1 im Menü Aktionen die Option Alias erstellen aus.

-

Geben Sie auf der Seite Create a new alias folgende Werte an:

-

Geben Sie unter Name

mlTestOptein. -

Geben Sie in Version (Version)

1ein.

Anmerkung

AWS IoT Greengrass unterstützt keine Lambda-Aliase für $LATEST-Versionen.

-

-

Wählen Sie Create (Erstellen) aus.

Fügen Sie nun die Lambda-Funktion zu Ihrer Greengrass-Gruppe hinzu.

Schritt 4: Fügen Sie die Lambda-Funktion zur Greengrass-Gruppe hinzu

Fügen Sie in diesem Schritt die Lambda-Funktion zur Gruppe hinzu und konfigurieren Sie dann ihren Lebenszyklus.

Fügen Sie zunächst die Lambda-Funktion zu Ihrer Greengrass-Gruppe hinzu.

Erweitern Sie im Navigationsbereich der AWS IoT Konsole unter Verwalten die Option Greengrass-Geräte und wählen Sie dann Gruppen (V1) aus.

-

Wählen Sie auf der Gruppenkonfigurationsseite die Registerkarte Lambda-Funktionen und dann Hinzufügen aus.

-

Wählen Sie die Lambda-Funktion und wählen Sie optimizedImageClassification.

-

Wählen Sie in der Lambda-Funktionsversion den Alias für die Version aus, die Sie veröffentlicht haben.

Als Nächstes konfigurieren Sie den Lebenszyklus der Lambda-Funktion.

-

Nehmen Sie im Abschnitt Lambda-Funktionskonfiguration die folgenden Aktualisierungen vor.

Anmerkung

Wir empfehlen, dass Sie Ihre Lambda-Funktion ohne Containerisierung ausführen, sofern Ihr Geschäftsszenario dies nicht erfordert. Auf diese Weise können Sie auf die GPU und Kamera Ihres Geräts zugreifen, ohne die Geräteressourcen konfigurieren zu müssen. Wenn Sie ohne Containerisierung arbeiten, müssen Sie auch Root-Zugriff auf Ihre AWS IoT Greengrass Lambda-Funktionen gewähren.

-

Um ohne Containerisierung zu laufen:

-

Wählen Sie für Systembenutzer und Gruppe die Option.

Another user ID/group IDGeben Sie als Systembenutzer-ID ein0. Geben Sie als Systemgruppen-ID ein0.Dadurch kann Ihre Lambda-Funktion als Root ausgeführt werden. Weitere Hinweise zur Ausführung als Root finden Sie unterEinstellung der Standardzugriffsidentität für Lambda-Funktionen in einer Gruppe.

Tipp

Sie müssen Ihre

config.jsonDatei auch aktualisieren, um Root-Zugriff auf Ihre Lambda-Funktion zu gewähren. Informationen zum Verfahren finden Sie unterEine Lambda-Funktion als Root ausführen. -

Wählen Sie für die Containerisierung von Lambda-Funktionen die Option Kein Container aus.

Weitere Hinweise zur Ausführung ohne Containerisierung finden Sie unter. Überlegungen bei der Wahl der Containerisierung von Lambda-Funktionen

-

Geben Sie in Timeout (Zeitüberschreitung)

10 secondsein. -

Wählen Sie für Pinned die Option True aus.

Weitere Informationen finden Sie unter Lebenszykluskonfiguration für Greengrass Lambda-Funktionen.

-

Wählen Sie unter Zusätzliche Parameter für Lesezugriff auf das Verzeichnis /sys die Option Aktiviert aus.

-

-

Um stattdessen im containerisierten Modus zu starten:

Anmerkung

Wir empfehlen nicht, im containerisierten Modus zu arbeiten, es sei denn, Ihr Geschäftsszenario erfordert dies.

-

Wählen Sie für Systembenutzer und Gruppe die Option Gruppenstandard verwenden aus.

-

Wählen Sie für die Containerisierung von Lambda-Funktionen die Option Gruppenstandard verwenden aus.

-

Geben Sie in Memory Limit (Speicherlimit)

1024 MBein. -

Geben Sie in Timeout (Zeitüberschreitung)

10 secondsein. -

Wählen Sie für Pinned die Option True aus.

Weitere Informationen finden Sie unter Lebenszykluskonfiguration für Greengrass Lambda-Funktionen.

-

Wählen Sie unter Zusätzliche Parameter für Lesezugriff auf das Verzeichnis /sys die Option Aktiviert aus.

-

-

-

Wählen Sie Lambda-Funktion hinzufügen.

Schritt 5: Fügen Sie der SageMaker Greengrass-Gruppe eine KI-NEO-optimierte Modellressource hinzu

In diesem Schritt erstellen Sie eine Ressource für das optimierte ML-Inferenzmodell und laden Sie sie in einen Amazon S3 S3-Bucket hoch. Suchen Sie dann das hochgeladene Amazon S3 S3-Modell in der AWS IoT Greengrass Konsole und verknüpfen Sie die neu erstellte Ressource mit der Lambda-Funktion. Dies ermöglicht es der Funktion, auf ihre Ressourcen auf dem Core-Gerät zuzugreifen.

-

Navigieren Sie auf Ihrem Computer zum

resnet50-Verzeichnis im Beispielpaket, das Sie in Schritt 3: Erstellen Sie eine Inferenz-Lambda-Funktion entpackt haben.Anmerkung

Wenn Sie das NVIDIA Jetson-Beispiel verwenden, müssen Sie stattdessen das

resnet18-Verzeichnis im Beispielpaket verwenden. Weitere Informationen finden Sie unter Konfiguration eines NVIDIA Jetson TX2.cdpath-to-downloaded-sample/dlr-py3-armv7l/models/resnet50Dieses Verzeichnis enthält vorkompilierte Modellartefakte für ein mit Resnet-50 trainiertes Bildklassifikationsmodell.

-

Komprimieren Sie die Dateien innerhalb des

resnet50-Verzeichnisses in eine Datei namensresnet50.zip.zip -r resnet50.zip . -

Wählen Sie auf der Gruppenkonfigurationsseite für Ihre AWS IoT Greengrass Gruppe den Tab Ressourcen aus. Navigieren Sie zum Abschnitt Machine Learning und wählen Sie Add machine learning resource (Maschinelle Lernressource hinzufügen) aus. Geben Sie auf der Seite Eine maschinelle Lernressource erstellen für Ressourcenname

resnet50_modelein. -

Wählen Sie als Modellquelle die Option Ein in S3 gespeichertes Modell verwenden aus, z. B. ein mit dem Deep Learning Compiler optimiertes Modell.

-

Wählen Sie unter S3-URI die Option Browse S3 aus.

Anmerkung

Derzeit werden optimierte SageMaker KI-Modelle automatisch in Amazon S3 gespeichert. Mit dieser Option können Sie Ihr optimiertes Modell in Ihrem Amazon S3 S3-Bucket finden. Weitere Informationen zur Modelloptimierung in SageMaker KI finden Sie in der SageMaker AI Neo-Dokumentation.

-

Wählen Sie Upload a model (Ein Modell hochladen).

-

Laden Sie auf der Registerkarte Amazon S3 S3-Konsole Ihre ZIP-Datei in einen Amazon S3 S3-Bucket hoch. Weitere Informationen finden Sie unter Wie lade ich Dateien und Ordner in einen S3-Bucket hoch? im Amazon Simple Storage Service-Benutzerhandbuch.

Anmerkung

Ihr Bucket-Name muss die Zeichenfolge

greengrassenthalten. Wählen Sie einen eindeutigen Namen (wie z. B.:greengrass-dlr-bucket-). Verwenden Sie keinen Punkt (user-id-epoch-time.) im Bucket-Namen. -

Suchen Sie auf der Registerkarte „ AWS IoT Greengrass Konsole“ Ihren Amazon S3 S3-Bucket und wählen Sie ihn aus. Suchen Sie Ihre hochgeladene Datei

resnet50.zipund wählen Sie Select (Auswählen). Möglicherweise müssen Sie die Seite aktualisieren, um die Liste der verfügbaren Buckets und Dateien zu aktualisieren. -

Geben Sie im Feld Zielpfad den Wert ein

/ml_model.

Dies ist das Ziel für das lokale Modell im Lambda-Laufzeit-Namespace. Wenn Sie die Gruppe bereitstellen, AWS IoT Greengrass ruft das Quellmodellpaket ab und extrahiert dann den Inhalt in das angegebene Verzeichnis.

Anmerkung

Wir empfehlen Ihnen dringend, den genauen Pfad für Ihren lokalen Pfad zu verwenden. Die Verwendung eines anderen lokalen Modellzielverzeichnisses in diesem Schritt führt dazu, dass einige in diesem Tutorial enthaltene Befehle zur Fehlerbehebung ungenau sind. Wenn Sie einen anderen Pfad verwenden, müssen Sie eine

MODEL_PATH-Umgebungsvariable einrichten, die genau den von Ihnen hier angegebenen Pfad verwendet. Weitere Informationen zu Umgebungsvariablen finden Sie unter AWS Lambda -Umgebungsvariablen. -

Bei Ausführung im containerisierten Modus:

-

Wählen Sie unter Systemgruppenbesitzer- und Dateizugriffsberechtigungen die Option Systemgruppe und Berechtigungen angeben aus.

-

Wählen Sie Nur-Lese-Zugriff und anschließend Ressource hinzufügen aus.

-

Schritt 6: Hinzufügen einer Kamerageräte-Ressource zur Greengrass-Gruppe

Erstellen Sie in diesem Schritt eine Ressource für das Kameramodul und verknüpfen Sie sie mit der Lambda-Funktion. Dadurch kann die Lambda-Funktion auf die Ressource auf dem Core-Gerät zugreifen.

Anmerkung

Wenn Sie im Modus ohne Container arbeiten, AWS IoT Greengrass können Sie auf die GPU und Kamera Ihres Geräts zugreifen, ohne diese Geräteressource zu konfigurieren.

-

Wählen Sie auf der Gruppenkonfigurationsseite die Registerkarte Ressourcen aus.

-

Wählen Sie auf der Registerkarte Lokale Ressourcen die Option Lokale Ressource hinzufügen aus.

-

Verwenden Sie auf der Seite Lokale Ressource hinzufügen die folgenden Werte:

-

Geben Sie für Resource name (Ressourcenname)

videoCoreSharedMemoryein. -

Wählen Sie in Resource type (Ressourcentyp) die Option Device (Gerät) aus.

-

Geben Sie für Lokaler Gerätepfad den Wert ein

/dev/vcsm.Der Gerätepfad ist der lokale absolute Pfad der Geräteressource. Dieser Pfad kann nur auf ein zeichenorientiertes Gerät oder Blockgerät unter

/devverweisen. -

Wählen Sie für Systemgruppenbesitzer und Dateizugriffsberechtigungen die Option Dateisystemberechtigungen der Systemgruppe, der die Ressource gehört, automatisch hinzufügen aus.

Mit der Option Group owner file access permission (Dateizugriffsberechtigung des Gruppenbesitzers) können Sie zusätzliche Dateizugriffsberechtigungen für den Lambda-Prozess erteilen. Weitere Informationen finden Sie unter Dateizugriffsberechtigung des Gruppenbesitzers.

-

-

Wählen Sie unten auf der Seite die Option Ressource hinzufügen aus.

-

Erstellen Sie auf der Registerkarte Ressourcen eine weitere lokale Ressource, indem Sie Hinzufügen wählen und die folgenden Werte verwenden:

-

Geben Sie für Resource name (Ressourcenname)

videoCoreInterfaceein. -

Wählen Sie in Resource type (Ressourcentyp) die Option Device (Gerät) aus.

-

Geben Sie für Lokaler Gerätepfad den Wert ein

/dev/vchiq. -

Wählen Sie für Systemgruppenbesitzer und Dateizugriffsberechtigungen die Option Dateisystemberechtigungen der Systemgruppe, der die Ressource gehört, automatisch hinzufügen aus.

-

-

Wählen Sie Add resource (Ressource hinzufügen) aus.

Schritt 7: Hinzufügen von Abonnements zur Greengrass-Gruppe

In diesem Schritt fügen Sie der Gruppe Abonnements hinzu. Diese Abonnements ermöglichen es der Lambda-Funktion, Vorhersageergebnisse zu senden, AWS IoT indem sie sie in einem MQTT-Thema veröffentlichen.

-

Wählen Sie auf der Gruppenkonfigurationsseite die Registerkarte Abonnements und dann Abonnement hinzufügen aus.

-

Konfigurieren Sie auf der Seite Abonnement erstellen die Quelle und das Ziel wie folgt:

-

Wählen Sie unter Quelltyp die Option Lambda-Funktion und dann aus optimizedImageClassification.

-

Wählen Sie unter Zieltyp die Option Service und dann IoT Cloud aus.

-

Geben Sie im Themenfilter Folgendes ein

/resnet-50/predictionsund wählen Sie dann Abonnement erstellen aus.

-

-

Hinzufügen eines zweiten Abonnements. Wählen Sie die Registerkarte Abonnements, wählen Sie Abonnement hinzufügen und konfigurieren Sie Quelle und Ziel wie folgt:

-

Wählen Sie unter Quelltyp die Option Dienste und dann IoT Cloud aus.

-

Wählen Sie unter Zieltyp die Option Lambda-Funktion und dann aus optimizedImageClassification.

-

Geben Sie

/resnet-50/testim Themenfilter Folgendes ein und wählen Sie dann Create subscription aus.

-

Schritt 8: Bereitstellen der Greengrass-Gruppe

In diesem Schritt stellen Sie die aktuelle Version der Gruppendefinition für das Greengrass Core-Gerät bereit. Die Definition enthält die Lambda-Funktion, die Ressourcen und die Abonnementkonfigurationen, die Sie hinzugefügt haben.

-

Stellen Sie sicher, dass der AWS IoT Greengrass Core läuft. Führen Sie im Raspberry Pi-Terminal die folgenden Befehle aus, falls nötig.

-

So prüfen Sie, ob der Daemon ausgeführt wird:

ps aux | grep -E 'greengrass.*daemon'Wenn die Ausgabe einen

root-Eintrag für/greengrass/ggc/packages/enthält, dann wird der Daemon ausgeführt.latest-core-version/bin/daemon Um den Daemon zu starten:

cd /greengrass/ggc/core/ sudo ./greengrassd start

-

-

Wählen Sie auf der Seite mit der Gruppenkonfiguration die Option Deploy aus.

-

Wählen Sie auf der Registerkarte Lambda-Funktionen die Option IP-Detektor und dann Bearbeiten aus.

-

Wählen Sie im Dialogfeld IP-Detektoreinstellungen bearbeiten die Option MQTT-Broker-Endpunkte automatisch erkennen und überschreiben aus und wählen Sie Speichern aus.

Damit können Geräte automatisch Core-Verbindungsinformationen abrufen, z. B. die IP-Adresse, DNS und die Portnummer. Eine automatische Erkennung wird empfohlen, unterstützt aber AWS IoT Greengrass auch manuell angegebene Endpunkte. Sie werden nur bei der ersten Bereitstellung der Gruppe zur Angabe der Ermittlungsmethode aufgefordert.

Anmerkung

Wenn Sie dazu aufgefordert werden, erteilen Sie die Erlaubnis, die Greengrass-Servicerolle zu erstellen und sie Ihrer AWS-Konto aktuellen AWS-Region Rolle zuzuordnen. Diese Rolle ermöglicht AWS IoT Greengrass den Zugriff auf Ihre Ressourcen in AWS Diensten.

Auf der Seite Deployments werden der Zeitstempel, die Versions-ID und der Status der Bereitstellung angegeben. Nach Abschluss sollte der für die Bereitstellung angezeigte Status Abgeschlossen lauten.

Weitere Informationen über Bereitstellungen finden Sie unter AWS IoT Greengrass Gruppen für einen AWS IoT Greengrass Kern bereitstellen. Hilfe zur Problembehebung finden Sie unter Problembehebung AWS IoT Greengrass.

Testen des Inferenzbeispiels

Nun können Sie prüfen, ob die Bereitstellung korrekt konfiguriert ist. Um zu testen, abonnieren Sie das Thema /resnet-50/predictions und veröffentlichen Sie jede Nachricht zum /resnet-50/test-Thema. Dadurch wird die Lambda-Funktion ausgelöst, um ein Foto mit Ihrem Raspberry Pi aufzunehmen und Rückschlüsse auf das aufgenommene Bild zu ziehen.

Anmerkung

Wenn Sie das NVIDIA Jetson-Beispiel verwenden, stellen Sie sicher, dass Sie stattdessen die Themen resnet-18/predictions und resnet-18/test verwenden.

Anmerkung

Wenn ein Bildschirm mit dem Raspberry Pi verbunden ist, wird das Livebild der Kamera in einem Vorschaufenster angezeigt.

-

Wählen Sie auf der Startseite der AWS IoT Konsole unter Test die Option MQTT-Testclient aus.

-

Wählen Sie für Abonnements die Option Thema abonnieren aus. Verwenden Sie die folgenden Werte. Übernehmen Sie für die verbleibenden Optionen die Standardwerte.

-

Geben Sie für Abonnementthema

/resnet-50/predictionsein. -

Wählen Sie unter Zusätzliche Konfiguration für die Anzeige von MQTT-Payloads die Option Payloads als Zeichenketten anzeigen aus.

-

-

Wählen Sie Subscribe (Abonnieren) aus.

-

Wählen Sie In einem Thema veröffentlichen, geben Sie es

/resnet-50/testals Themennamen ein und wählen Sie Veröffentlichen. -

Wenn der Test erfolgreich ist, veranlasst die veröffentlichte Nachricht die Raspberry Pi-Kamera, ein Bild aufzunehmen. Eine Meldung der Lambda-Funktion wird unten auf der Seite angezeigt. Diese Meldung enthält das Vorhersageergebnis des Bildes im Format: vorhergesagter Klassenname, Wahrscheinlichkeit und maximaler Speicherverbrauch.

Konfigurieren eines Intel Atom

Um dieses Tutorial auf einem Intel Atom-Gerät auszuführen, müssen Sie Quellbilder bereitstellen, die Lambda-Funktion konfigurieren und eine weitere lokale Geräteressource hinzufügen. Um die GPU für die Inferenz zu verwenden, stellen Sie sicher, dass die folgende Software auf Ihrem Gerät installiert ist:

-

OpenCL Version 1.0 oder höher

-

Python 3.7 und pip

-

Laden Sie statische PNG- oder JPG-Bilder für die Lambda-Funktion herunter, um sie für die Bildklassifizierung zu verwenden. Das Beispiel funktioniert am besten mit kleinen Bilddateien.

Speichern Sie Ihre Bilddateien in dem Verzeichnis mit der

inference.py-Datei (oder in einem Unterverzeichnis dieses Verzeichnisses). Dies ist im Lambda-Funktionsbereitstellungspaket enthalten, in Schritt 3: Erstellen Sie eine Inferenz-Lambda-Funktion das Sie hochladen.Anmerkung

Wenn Sie die Kamera verwenden AWS DeepLens, können Sie die integrierte Kamera verwenden oder Ihre eigene Kamera montieren, um Rückschlüsse auf aufgenommene Bilder statt auf statische Bilder zu ziehen. Wir empfehlen jedoch nachdrücklich, zunächst mit statischen Bildern zu beginnen.

Wenn Sie eine Kamera verwenden, stellen Sie sicher, dass das

awscam-APT-Paket installiert und auf dem neuesten Stand ist. Weitere Informationen finden Sie im AWS DeepLens Entwicklerhandbuch unter Ihr AWS DeepLens Gerät aktualisieren. -

Bearbeiten Sie die Konfiguration der Lambda-Funktion. Folgen Sie dem Verfahren unter Schritt 4: Fügen Sie die Lambda-Funktion zur Greengrass-Gruppe hinzu.

Anmerkung

Wir empfehlen, dass Sie Ihre Lambda-Funktion ohne Containerisierung ausführen, sofern Ihr Geschäftsszenario dies nicht erfordert. Auf diese Weise können Sie auf die GPU und Kamera Ihres Geräts zugreifen, ohne die Geräteressourcen konfigurieren zu müssen. Wenn Sie ohne Containerisierung arbeiten, müssen Sie auch Root-Zugriff auf Ihre AWS IoT Greengrass Lambda-Funktionen gewähren.

-

Um ohne Containerisierung zu laufen:

-

Wählen Sie für Systembenutzer und Gruppe die Option.

Another user ID/group IDGeben Sie als Systembenutzer-ID ein0. Geben Sie als Systemgruppen-ID ein0.Dadurch kann Ihre Lambda-Funktion als Root ausgeführt werden. Weitere Hinweise zur Ausführung als Root finden Sie unterEinstellung der Standardzugriffsidentität für Lambda-Funktionen in einer Gruppe.

Tipp

Sie müssen Ihre

config.jsonDatei auch aktualisieren, um Root-Zugriff auf Ihre Lambda-Funktion zu gewähren. Informationen zum Verfahren finden Sie unterEine Lambda-Funktion als Root ausführen. -

Wählen Sie für die Containerisierung von Lambda-Funktionen die Option Kein Container aus.

Weitere Hinweise zur Ausführung ohne Containerisierung finden Sie unter. Überlegungen bei der Wahl der Containerisierung von Lambda-Funktionen

-

Erhöhen Sie den Wert für Timeout auf 2 Minuten. Dies stellt sicher, dass die Zeit für die Anforderung nicht zu schnell überschritten wird. Nach der Einrichtung dauert es einige Minuten, bis die Inferenz ausgeführt wird.

-

Wählen Sie für Pinned die Option True aus.

-

Wählen Sie unter Zusätzliche Parameter für Lesezugriff auf das Verzeichnis /sys die Option Aktiviert aus.

-

-

Um stattdessen im containerisierten Modus zu starten:

Anmerkung

Wir empfehlen nicht, im containerisierten Modus zu arbeiten, es sei denn, Ihr Geschäftsszenario erfordert dies.

-

Erhöhen Sie den Wert für Speicherlimit auf 3000 MB.

-

Erhöhen Sie den Wert für Timeout auf 2 Minuten. Dies stellt sicher, dass die Zeit für die Anforderung nicht zu schnell überschritten wird. Nach der Einrichtung dauert es einige Minuten, bis die Inferenz ausgeführt wird.

-

Wählen Sie für Pinned die Option True aus.

-

Wählen Sie unter Zusätzliche Parameter für Lesezugriff auf das Verzeichnis /sys die Option Aktiviert aus.

-

-

-

Fügen Sie Ihrer Neo-optimierten Modellressource der Gruppe hinzu. Laden Sie die Modellressourcen in das

resnet50-Verzeichnis des Beispielpakets hoch, das Sie in Schritt 3: Erstellen Sie eine Inferenz-Lambda-Funktion entpackt haben. Dieses Verzeichnis enthält vorkompilierte Modellartefakte für ein mit Resnet-50 trainiertes Bildklassifikationsmodell. Folgen Sie dem Verfahren unter Schritt 5: Fügen Sie der SageMaker Greengrass-Gruppe eine KI-NEO-optimierte Modellressource hinzu mit den folgenden Updates:-

Komprimieren Sie die Dateien innerhalb des

resnet50-Verzeichnisses in eine Datei namensresnet50.zip. -

Geben Sie auf der Seite Eine maschinelle Lernressource erstellen für Ressourcenname

resnet50_modelein. -

Hochladen der

resnet50.zip-Datei

-

-

Wenn es im containerisierten Modus ausgeführt wird, fügen Sie die erforderliche lokale Geräteressource hinzu, um Zugriff auf die GPU Ihres Geräts zu gewähren.

Anmerkung

Wenn Sie im Modus ohne Container arbeiten, AWS IoT Greengrass können Sie auf die GPU Ihres Geräts zugreifen, ohne die Geräteressourcen konfigurieren zu müssen.

-

Wählen Sie auf der Gruppenkonfigurationsseite die Registerkarte Ressourcen aus.

-

Wählen Sie im Abschnitt Lokale Ressourcen die Option Lokale Ressource hinzufügen aus.

-

Definieren Sie die Ressource:

-

Geben Sie für Resource name (Ressourcenname)

renderD128ein. -

Wählen Sie in Resource type (Ressourcentyp) die Option Device (Gerät) aus.

-

Geben Sie für Lokaler Gerätepfad den Wert ein

/dev/dri/renderD128. -

Wählen Sie für Systemgruppenbesitzer und Dateizugriffsberechtigungen die Option Dateisystemberechtigungen der Systemgruppe, der die Ressource gehört, automatisch hinzufügen aus.

-

-

Konfiguration eines NVIDIA Jetson TX2

Um dieses Tutorial auf einem NVIDIA Jetson auszuführen TX2, stellen Sie Quellimages bereit, konfigurieren Sie die Lambda-Funktion und fügen Sie weitere lokale Geräteressourcen hinzu.

-

Stellen Sie sicher, dass Ihr Jetson-Gerät so konfiguriert ist, dass Sie die AWS IoT Greengrass Core-Software installieren und die GPU als Inferenz verwenden können. Weitere Informationen zur Konfiguration des Geräts finden Sie unter Einrichten anderer Geräte. Um die GPU für Inferenz auf einem NVIDIA Jetson zu verwenden TX2, müssen Sie CUDA 10.0 und cuDNN 7.0 auf Ihrem Gerät installieren, wenn Sie Ihr Board mit Jetpack 4.3 abbilden.

-

Laden Sie statische PNG- oder JPG-Bilder für die Lambda-Funktion herunter, um sie für die Bildklassifizierung zu verwenden. Das Beispiel funktioniert am besten mit kleinen Bilddateien.

Speichern Sie Ihre Abbilddateien in dem Verzeichnis, das die

inference.py-Datei enthält. Sie können sie auch in einem Unterverzeichnis dieses Verzeichnisses speichern. Dieses Verzeichnis befindet sich im Lambda-Funktionsbereitstellungspaket, in Schritt 3: Erstellen Sie eine Inferenz-Lambda-Funktion das Sie hochladen.Anmerkung

Sie können auf Wunsch stattdessen eine Kamera auf der Jetson-Karte instrumentieren, um die Quellbilder zu erfassen. Wir empfehlen jedoch nachdrücklich, zunächst mit statischen Bildern zu beginnen.

-

Bearbeiten Sie die Konfiguration der Lambda-Funktion. Folgen Sie dem Verfahren unter Schritt 4: Fügen Sie die Lambda-Funktion zur Greengrass-Gruppe hinzu.

Anmerkung

Wir empfehlen, dass Sie Ihre Lambda-Funktion ohne Containerisierung ausführen, sofern Ihr Geschäftsszenario dies nicht erfordert. Auf diese Weise können Sie auf die GPU und Kamera Ihres Geräts zugreifen, ohne die Geräteressourcen konfigurieren zu müssen. Wenn Sie ohne Containerisierung arbeiten, müssen Sie auch Root-Zugriff auf Ihre AWS IoT Greengrass Lambda-Funktionen gewähren.

-

Um ohne Containerisierung zu laufen:

-

Wählen Sie für Ausführen als die Option.

Another user ID/group IDGeben Sie0für UID ein. Geben Sie für GUID ein.0Dadurch kann Ihre Lambda-Funktion als Root ausgeführt werden. Weitere Hinweise zur Ausführung als Root finden Sie unterEinstellung der Standardzugriffsidentität für Lambda-Funktionen in einer Gruppe.

Tipp

Sie müssen Ihre

config.jsonDatei auch aktualisieren, um Root-Zugriff auf Ihre Lambda-Funktion zu gewähren. Informationen zum Verfahren finden Sie unterEine Lambda-Funktion als Root ausführen. -

Wählen Sie für die Containerisierung von Lambda-Funktionen die Option Kein Container aus.

Weitere Hinweise zur Ausführung ohne Containerisierung finden Sie unter. Überlegungen bei der Wahl der Containerisierung von Lambda-Funktionen

-

Erhöhen Sie den Wert für Timeout auf 5 Minuten. Dies stellt sicher, dass die Zeit für die Anforderung nicht zu schnell überschritten wird. Nach der Einrichtung dauert es einige Minuten, bis die Inferenz ausgeführt wird.

-

Wählen Sie für Pinned die Option True aus.

-

Wählen Sie unter Zusätzliche Parameter für Lesezugriff auf das Verzeichnis /sys die Option Aktiviert aus.

-

-

Um stattdessen im containerisierten Modus zu starten:

Anmerkung

Wir empfehlen nicht, im containerisierten Modus zu arbeiten, es sei denn, Ihr Geschäftsszenario erfordert dies.

-

Erhöhen Sie den Wert für Speicherlimit. Für die Verwendung des bereitgestellten Modells im GPU-Modus verwenden Sie mindestens 2000 MB.

-

Erhöhen Sie den Wert für Timeout auf 5 Minuten. Dies stellt sicher, dass die Zeit für die Anforderung nicht zu schnell überschritten wird. Nach der Einrichtung dauert es einige Minuten, bis die Inferenz ausgeführt wird.

-

Wählen Sie für Pinned die Option True aus.

-

Wählen Sie unter Zusätzliche Parameter für Lesezugriff auf das Verzeichnis /sys die Option Aktiviert aus.

-

-

-

Fügen Sie Ihrer Neo-optimierten Modellressource der Gruppe hinzu. Laden Sie die Modellressourcen in das

resnet18-Verzeichnis des Beispielpakets hoch, das Sie in Schritt 3: Erstellen Sie eine Inferenz-Lambda-Funktion entpackt haben. Dieses Verzeichnis enthält vorkompilierte Modellartefakte für ein mit Resnet-18 geschultes Bildklassifikationsmodell. Folgen Sie dem Verfahren unter Schritt 5: Fügen Sie der SageMaker Greengrass-Gruppe eine KI-NEO-optimierte Modellressource hinzu mit den folgenden Updates:-

Komprimieren Sie die Dateien innerhalb des

resnet18-Verzeichnisses in eine Datei namensresnet18.zip. -

Geben Sie auf der Seite Eine maschinelle Lernressource erstellen für Ressourcenname

resnet18_modelein. -

Hochladen der

resnet18.zip-Datei

-

-

Wenn das Gerät im Containermodus ausgeführt wird, fügen Sie die erforderlichen lokalen Geräteressourcen hinzu, um Zugriff auf die GPU Ihres Geräts zu gewähren.

Anmerkung

Wenn Sie im Modus ohne Container arbeiten, AWS IoT Greengrass können Sie auf die GPU Ihres Geräts zugreifen, ohne die Geräteressourcen konfigurieren zu müssen.

-

Wählen Sie auf der Gruppenkonfigurationsseite die Registerkarte Ressourcen aus.

-

Wählen Sie im Abschnitt Lokale Ressourcen die Option Lokale Ressource hinzufügen aus.

-

Definieren Sie die einzelnen Ressourcen:

-

Verwenden Sie für Resource name (Ressourcenname) und Device path (Gerätepfad) die Werte in der folgenden Tabelle. Erstellen Sie für jede Zeile in der Tabelle genau eine Geräteressource.

-

Wählen Sie in Resource type (Ressourcentyp) die Option Device (Gerät) aus.

-

Wählen Sie für Systemgruppenbesitzer- und Dateizugriffsberechtigungen die Option Dateisystemberechtigungen der Systemgruppe automatisch hinzufügen aus, der die Ressource gehört.

Name

Gerätepfad

nvhost-strg

/dev/nvhost-strg

nvhost-gpu

/dev/nvhost-gpu

nvhost-ctrl-gpu

/dev/ nvhost-ctrl-gpu

nvhost-dbg-gpu

/entwicklung/ nvhost-dbg-gpu

nvhost-prof-gpu

/entwicklung/ nvhost-prof-gpu

nvmap

/dev/nvmap

nvhost-vic

/dev/nvhost-vic

tegra_dc_ctrl

/dev/tegra_dc_ctrl

-

-

-

Wenn es im containerisierten Modus läuft, fügen Sie die folgende lokale Volume-Ressource hinzu, um Zugriff auf Ihre Gerätekamera zu gewähren. Folgen Sie dem Verfahren unter Schritt 5: Fügen Sie der SageMaker Greengrass-Gruppe eine KI-NEO-optimierte Modellressource hinzu.

Anmerkung

Wenn Sie im Modus ohne Container arbeiten, AWS IoT Greengrass können Sie auf die Kamera Ihres Geräts zugreifen, ohne die Geräteressourcen konfigurieren zu müssen.

-

Wählen Sie für Resource type (Ressourcentyp) die Option Volume aus.

-

Wählen Sie für Systemgruppenbesitzer und Dateizugriffsberechtigungen die Option Dateisystemberechtigungen der Systemgruppe automatisch hinzufügen aus, der die Ressource gehört.

Name

Quellpfad

Zielpfad

shm

/dev/shm

/dev/shm

tmp

/tmp

/tmp

-

-

Aktualisieren Sie Ihre Gruppenabonnements, um das richtige Verzeichnis zu verwenden. Folgen Sie dem Verfahren unter Schritt 7: Hinzufügen von Abonnements zur Greengrass-Gruppe mit den folgenden Updates:

-

Geben Sie für den ersten Themenfilter

/resnet-18/predictionsein. -

Geben Sie für den zweiten Themenfilter

/resnet-18/testein.

-

-

Aktualisieren Sie Ihre Testabonnements, um das richtige Verzeichnis zu verwenden. Folgen Sie dem Verfahren unter Testen des Inferenzbeispiels mit den folgenden Updates:

-

Wählen Sie für Abonnements die Option Thema abonnieren aus. Geben Sie für Abonnementthema

/resnet-18/predictionsein. -

Geben Sie auf der Seite

/resnet-18/predictionsdas/resnet-18/test-Thema an, zu dem veröffentlicht werden soll.

-

Problembehandlung bei AWS IoT Greengrass ML-Inferenz

Wenn der Test nicht erfolgreich ist, können Sie folgende Schritte ausführen, um den Fehler zu beheben. Führen Sie im Raspberry Pi-Terminal die Befehle aus.

Fehlerprotokolle prüfen

-

Wechseln Sie zum Root-Benutzer und navigieren Sie zum Verzeichnis

log. Für den Zugriff auf AWS IoT Greengrass Protokolle sind Root-Rechte erforderlich.sudo su cd /greengrass/ggc/var/log -

Prüfen Sie

runtime.log, ob Fehler vorliegen.cat system/runtime.log | grep 'ERROR'Sie können auch in Ihrem benutzerdefinierten Lambda-Funktionsprotokoll nach Fehlern suchen:

cat user/your-region/your-account-id/lambda-function-name.log | grep 'ERROR'Weitere Informationen finden Sie unter Fehlerbehebung mit Protokollen.

Stellen Sie sicher, dass die Lambda-Funktion erfolgreich bereitgestellt wurde

-

Listet den Inhalt des bereitgestellten Lambda im

/lambdaVerzeichnis auf. Ersetzen Sie die Platzhalterwerte, bevor Sie den Befehl ausführen.cd /greengrass/ggc/deployment/lambda/arn:aws:lambda:region:account:function:function-name:function-versionls -la -

Überprüfen Sie, ob das Verzeichnis denselben Inhalt wie das

optimizedImageClassification.zip-Bereitstellungspaket enthält, das Sie in Schritt 3: Erstellen Sie eine Inferenz-Lambda-Funktion hochgeladen haben.Stellen Sie sicher, dass sich die

.py-Dateien und -Abhängigkeiten im Stammverzeichnis befinden.

Stellen Sie sicher, dass das Inferenzmodell erfolgreich bereitgestellt wird

-

Finden Sie die Prozessidentifikationsnummer (PID) des Lambda-Laufzeitprozesses:

ps aux | greplambda-function-nameIn der Ausgabe erscheint die PID in der zweiten Spalte der Zeile für den Lambda-Laufzeitprozess.

-

Geben Sie den Lambda-Runtime-Namespace ein. Achten Sie darauf, den

pidPlatzhalterwert zu ersetzen, bevor Sie den Befehl ausführen.Anmerkung

Dieses Verzeichnis und sein Inhalt befinden sich im Lambda-Runtime-Namespace, sodass sie in einem regulären Linux-Namespace nicht sichtbar sind.

sudo nsenter -tpid-m /bin/bash -

Listen Sie den Inhalt des lokalen Verzeichnisses, das Sie für die ML-Ressource angegeben haben, auf.

Anmerkung

Wenn Ihr ML-Ressourcenpfad anders als

ml_modellautet, müssen Sie ihn hier ersetzen.cd /ml_model ls -lsDie Dateien sollten folgendermaßen aussehen:

56 -rw-r--r-- 1 ggc_user ggc_group 56703 Oct 29 20:07 model.json 196152 -rw-r--r-- 1 ggc_user ggc_group 200855043 Oct 29 20:08 model.params 256 -rw-r--r-- 1 ggc_user ggc_group 261848 Oct 29 20:07 model.so 32 -rw-r--r-- 1 ggc_user ggc_group 30564 Oct 29 20:08 synset.txt

Die Lambda-Funktion kann /dev/dri/renderD128 nicht finden.

Dies kann passieren, wenn OpenCL keine Verbindung zu den benötigten GPU-Geräten herstellen kann. Sie müssen Geräteressourcen für die erforderlichen Geräte für Ihre Lambda-Funktion erstellen.

Nächste Schritte

Betrachten Sie als Nächstes weitere optimierte Modelle. Informationen finden Sie in der SageMaker AI Neo-Dokumentation.