Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Lösungsarchitektur für die Ausführung modernisierter Blu Age-Workloads auf AWS

Die Lösung führt die modernisierte Anwendung in einem Docker-Container

Der Java-Anwendungscode im Container fällt außerhalb des Geltungsbereichs dieses Handbuchs. Auf einer höheren Ebene fungiert das Wrapper-Shell-Skript als Einstiegspunkt in den Container und orchestriert verschiedene Aufgaben. Zur Laufzeit stellt die ECS-Aufgabendefinition die Umgebungsmetadaten wie Amazon Simple Storage Service (Amazon S3) -Buckets bereit, indem sie native Integrationen mit AWS Secrets Managerund Parameter Store verwendet, eine Funktion von. AWS Systems Manager

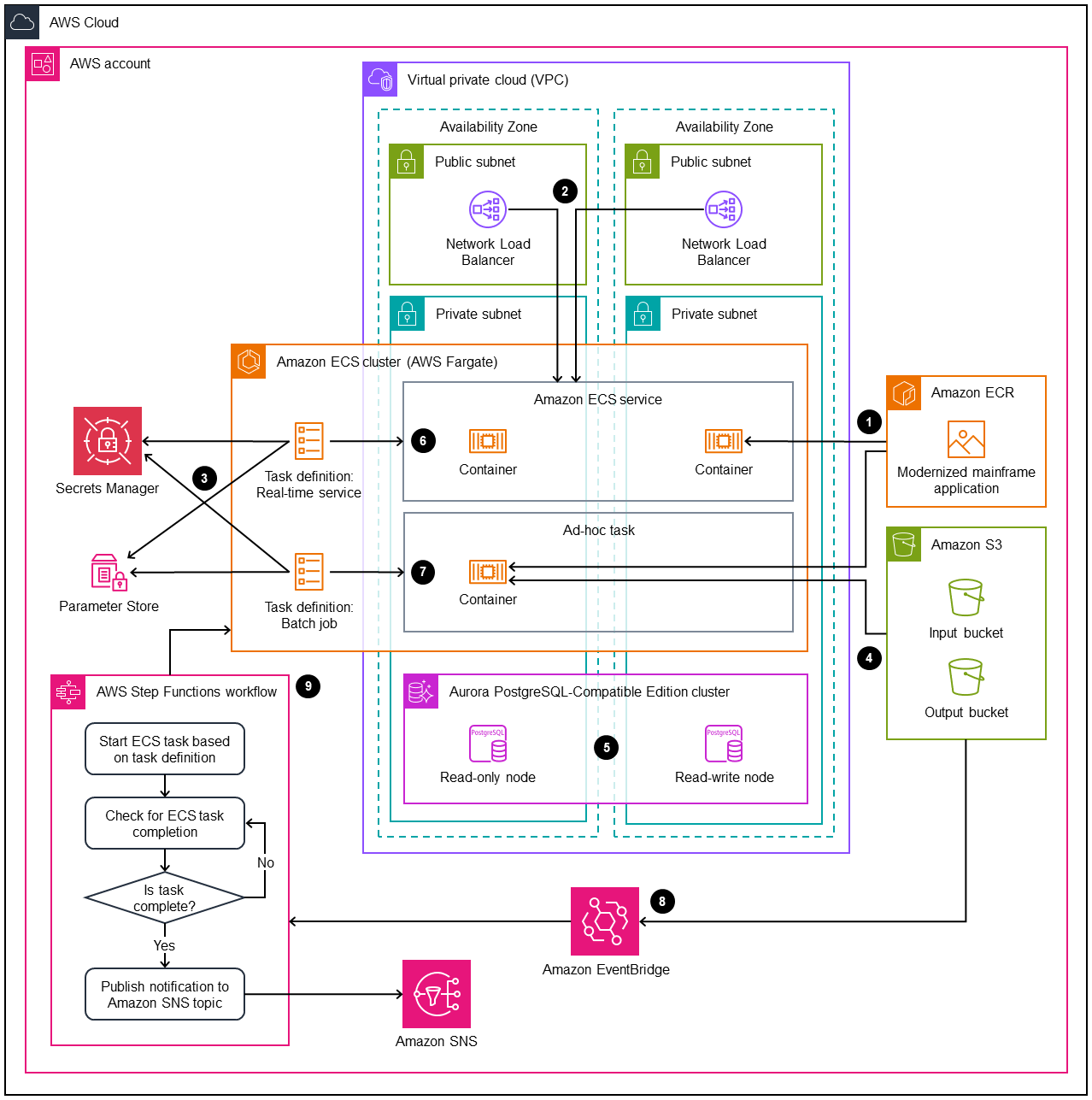

Die folgende Architektur ist darauf ausgelegt, modernisierte Mainframe-Workloads serverlos auszuführen AWS-Services, sodass keine lokale Infrastruktur verwaltet und gewartet werden muss.

Das Diagramm zeigt den folgenden Prozess:

-

Erstellen und speichern Sie das Container-Image in Amazon Elastic Container Registry (Amazon ECR). Die Amazon ECS-Aufgabendefinition referenziert das Bild mithilfe des Image-Tags.

-

Verwenden Sie eine der folgenden Arten von Elastic Load Balancing Balancing-Ressourcen, um einen Einstiegspunkt für Anfragen bereitzustellen:

-

Verwenden Sie für HTTP-basierte Dienste einen Application Load Balancer. Dies ermöglicht die Verwendung von TLS-Zertifikaten zur Verschlüsselung bei der Übertragung und zur Überprüfung des Anwendungszustands.

-

Verwenden Sie für andere Dienste, wie IBM CICS, einen Network Load Balancer. Dadurch werden auf transparente Weise Proxy-TCP-Verbindungen (Layer 4) zu den Containern im Amazon ECS-Cluster erstellt.

Anmerkung

Bei Network Load Balancers erfordern die Integritätsprüfungen von Containern den Aufbau einer TCP-Verbindung.

-

-

Speichern Sie Umgebungskonfigurationen wie Datenbank-Endpunkte und Anmeldeinformationen in Secrets Manager oder Parameter Store. Mit Secrets Manager zahlen Sie auf der Grundlage der Anzahl der gespeicherten Geheimnisse und der getätigten API-Aufrufe. Dieser Service eignet sich am besten für sensible Daten wie Datenbankanmeldedaten. Bei Parameter Store fallen keine zusätzlichen Gebühren für Standardparameter und Standarddurchsatz von API-Interaktionen an. Dieser Service eignet sich am besten für andere, nicht sensible Daten wie Java-Logging-Parameter.

-

Verwenden Sie Amazon S3, um Aufgabeneingaben und -ausgaben zu speichern. Das AWS Command Line Interface (AWS CLI) im Bash-Wrapper kümmert sich um die Integration des Containers mit Amazon S3. Amazon S3 S3-Ereignisse, wie

PutObjectAnfragen, können verwendet werden, um Workflows auszulösen, z. B. um die Amazon ECS-Aufgabe für einen Batch-Job auszuführen oder Ausgaben an nachgeschaltete Verbraucher zu liefern. -

Verwenden Sie Amazon Aurora PostgreSQL-Compatible Edition als Ersatz für die Mainframe-Datenbank-Engine wie IBM Db2 oder IBM IMS. Verbindungsdetails, wie Endpunkte und Anmeldeinformationen, werden zur Laufzeit der Aufgabe bereitgestellt. Einer der schwierigsten Aspekte bei der Modernisierung von Mainframe-Workloads besteht darin, sicherzustellen, dass die Eingaben zwischen dem Mainframe und den modernisierten Versionen der Anwendung übereinstimmen. Es gibt nur wenige CDC-Lösungen (Change Data Capture) in Echtzeit, mit denen Daten von einem Mainframe auf eine moderne Datenbank-Engine wie PostgreSQL repliziert werden können. Stellen Sie sicher, dass Sie genau wissen, welche Daten die modernisierte Anwendung benötigt und wie sie zur Verfügung gestellt werden.

-

Die Aufgabendefinition für Echtzeitdienste umfasst Details zum Container-Image, zu den TCP/IP-Ports, die den Load-Balancing-Ressourcen zur Verfügung gestellt werden sollen, und zur Anzahl der Container, die zu einem bestimmten Zeitpunkt benötigt werden. Der integrierte Amazon ECS Deployment Circuit Breaker

(AWS Blogbeitrag) bietet einen verwalteten Mechanismus zur Bereitstellung fortlaufender Updates, der den betrieblichen Aufwand für die Verwaltung von Servicebereitstellungen überflüssig macht. -

Die Aufgabendefinition für Batch-Jobs enthält Details zum Container-Image und zu allen Umgebungsvariablen, die für die Konfiguration erforderlich sind. Dazu können die verfügbaren Ressourcen (wie CPU, RAM oder kurzlebiger Speicher), Eingaben, Ausgaben und andere Einstellungen gehören.

-

Verwenden Sie Amazon S3 Event Notifications oder Amazon EventBridge, um Workflows zu initiieren. Diese Services können einen AWS Step Functions Workflow starten oder Objekte auf der Grundlage von Ereignissen in Amazon S3 verarbeiten, z. B. wenn ein Job ein Ausgabeobjekt in einen Bucket schreibt.

-

Wird verwendet AWS Step Functions, um den Vorgang von Batch-Jobs in Amazon ECS abzuwickeln. Der Workflow kann eine Batch-Aufgabe starten, ihren Fortschritt überwachen und etwaige Fehler beheben.

Bei Mainframe-Workloads ist es wahrscheinlich, dass ein gewisses Maß an Anpassung erforderlich ist. Diese Architektur soll mit gängigen Anwendungsfällen kompatibel sein, und Sie können sie erweitern, um viele Anforderungen zu unterstützen.