Amazon Forecast n'est plus disponible pour les nouveaux clients. Les clients existants d'Amazon Forecast peuvent continuer à utiliser le service normalement. En savoir plus »

Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Évaluation de la précision des prédicteurs

Amazon Forecast produit des mesures de précision pour évaluer les prédicteurs et vous aider à choisir ceux à utiliser pour générer des prévisions. Forecast évalue les prédicteurs à l'aide des métriques Root Mean Square Error (RMSE), Weighted Quantile Loss (wQL), Mean Absolute Pourcentage Error (MAPE), Mean Absolute Scaled Error (MASE) et Weighted Absolute Pourcentage Error (WAPE).

Amazon Forecast utilise le backtesting pour ajuster les paramètres et produire des indicateurs de précision. Lors du backtesting, Forecast divise automatiquement les données de vos séries chronologiques en deux ensembles : un ensemble d'entraînement et un ensemble de test. L'ensemble d'apprentissage est utilisé pour entraîner un modèle et générer des prévisions pour les points de données du jeu de test. Forecast évalue la précision du modèle en comparant les valeurs prévisionnelles aux valeurs observées dans le kit de test.

Forecast vous permet d'évaluer des prédicteurs à l'aide de différents types de prévisions, qui peuvent être un ensemble de prévisions quantiles et la prévision moyenne. La prévision moyenne fournit une estimation ponctuelle, tandis que les prévisions quantiles fournissent généralement une gamme de résultats possibles.

Carnets en Python

Pour un step-by-step guide sur l'évaluation des indicateurs prédictifs, voir Calcul des métriques à l'aide de backtests au niveau des éléments

Rubriques

Interprétation des mesures de précision

Amazon Forecast fournit des mesures d'erreur quadratique moyenne (RMSE), de perte quantile pondérée (wQL), de perte quantile pondérée moyenne (wQL), d'erreur graduelle absolue moyenne (MASE), d'erreur absolue moyenne en pourcentage (MAPE) et d'erreur absolue pondérée en pourcentage (WAPE) pour évaluer vos prédicteurs. Outre les mesures du prédicteur global, Forecast calcule les mesures pour chaque fenêtre de backtest.

Vous pouvez consulter les mesures de précision de vos prédicteurs à l'aide du kit de développement logiciel (SDK) Amazon Forecast et de la console Amazon Forecast.

Note

Pour les métriques WQL, wQL, RMSE, MASE, MAPE et WAPE moyennes, une valeur inférieure indique un modèle supérieur.

Rubriques

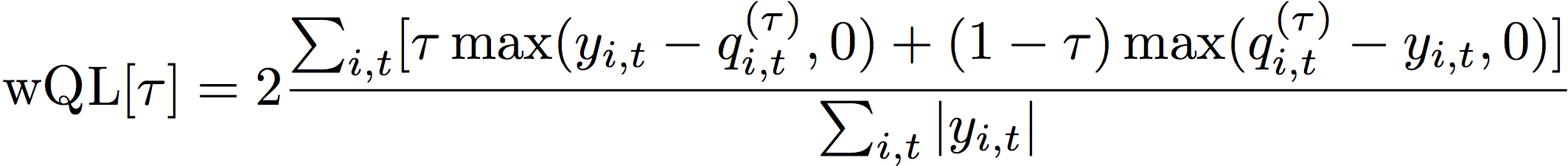

Perte quantile pondérée (qQL)

La métrique de perte quantile pondérée (wQL) mesure la précision d'un modèle à un quantile spécifié. C'est particulièrement utile lorsque les coûts liés à la sous-estimation et à la surestimation sont différents. En définissant le poids (t1) de la fonction wQL, vous pouvez automatiquement intégrer différentes pénalités en cas de sous-estimation ou de surestimation.

La fonction de perte est calculée comme suit.

- Où :

-

t1 - un quantile dans l'ensemble {0,01, 0,02,..., 0,99}

q i,t (995) - le quantile de τ-quantile prédit par le modèle.

y i,t - la valeur observée au point (i, t)

Les quantiles (t1) pour WQl peuvent être compris entre 0,01 (P1) et 0,99 (P99). La métrique WQL ne peut pas être calculée pour la prévision moyenne.

Par défaut, Forecast calcule le SQL aux adresses 0.1 (P10), 0.5 (P50) et 0.9 (P90).

-

P10 (0,1) - La valeur réelle devrait être inférieure à la valeur prévue 10 % du temps.

-

P50 (0,5) - La valeur réelle devrait être inférieure à la valeur prévue 50 % du temps. Cette prévision est également connue sous le nom de prévision médiane.

-

P90 (0,9) - La valeur réelle devrait être inférieure à la valeur prévue 90 % du temps.

Dans le commerce de détail, le coût d'un sous-stock est souvent plus élevé que le coût d'un surstock. Les prévisions à P75 (t1 = 0,75) peuvent donc être plus informatives que les prévisions au quantile médian (P50). Dans ces cas, wQL [0,75] attribue une pondération de pénalité plus élevée à la sous-estimation (0,75) et une pondération de pénalité plus faible à la surestimation (0,25).

La figure ci-dessus montre les différentes prévisions de demande pour wQL [0,50] et wQL [0,75]. La valeur prévue à P75 est nettement supérieure à la valeur prévue à P50, car la prévision P75 devrait répondre à la demande 75 % du temps, alors que la prévision P50 ne devrait répondre à la demande que 50 % du temps.

Lorsque la somme des valeurs observées sur tous les éléments et points temporels est approximativement nulle dans une fenêtre de backtest donnée, l'expression de perte quantile pondérée n'est pas définie. Dans ces cas, Forecast génère la perte quantile non pondérée, qui est le numérateur de l'expression wQL.

Forecast calcule également le wQL moyen, qui est la valeur moyenne des pertes quantiles pondérées sur tous les quantiles spécifiés. Par défaut, il s'agira de la moyenne de wQL [0,10], wQL [0,50] et wQL [0,90].

Pourcentage d'erreur absolu pondéré (WAPE)

L'erreur absolue pondérée en pourcentage (WAPE) mesure l'écart global entre les valeurs prévues et les valeurs observées. Le WAPE est calculé en prenant la somme des valeurs observées et de la somme des valeurs prédites, et en calculant l'erreur entre ces deux valeurs. Une valeur faible indique un modèle plus précis.

Lorsque la somme des valeurs observées pour tous les points temporels et tous les éléments est approximativement nulle dans une fenêtre de backtest donnée, l'expression du pourcentage d'erreur absolu pondéré n'est pas définie. Dans ces cas, Forecast génère la somme des erreurs absolues non pondérées, qui est le numérateur de l'expression WAPE.

- Où :

-

y i,t - la valeur observée au point (i, t)

i,t

Forecast utilise la moyenne des prévisions comme valeur préditei,t,

Le WAPE est plus résistant aux valeurs aberrantes que l'erreur quadratique moyenne (RMSE) car il utilise l'erreur absolue au lieu de l'erreur quadratique.

Amazon Forecast désignait auparavant la métrique WAPE sous le nom de Mean Absolute Pourcentage Error (MAPE) et utilisait la prévision médiane (P50) comme valeur prédite. Forecast utilise désormais la prévision moyenne pour calculer le WAPE. La métrique wQL [0,5] est équivalente à la métrique WAPE [médiane], comme indiqué ci-dessous :

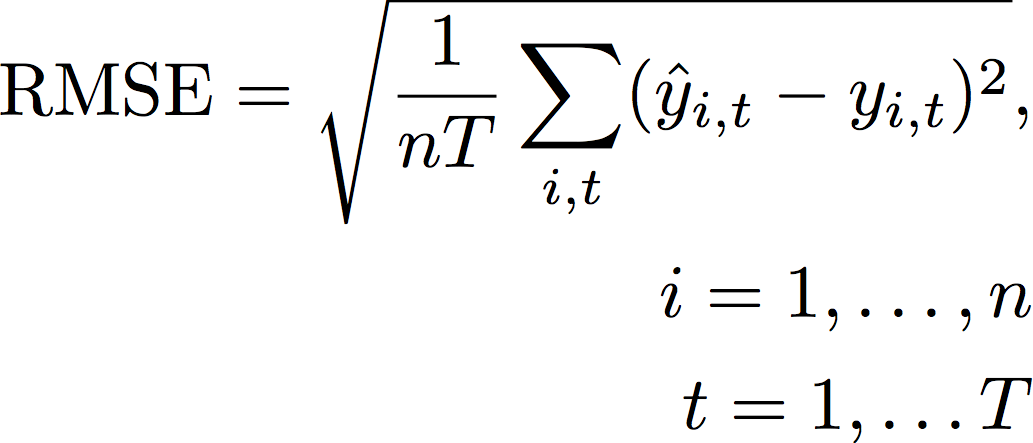

Erreur quadratique moyenne (RMSE)

L'erreur quadratique moyenne (RMSE) est la racine carrée de la moyenne des erreurs quadratiques et est donc plus sensible aux valeurs aberrantes que les autres indicateurs de précision. Une valeur faible indique un modèle plus précis.

- Où :

-

y i,t - la valeur observée au point (i, t)

i,t

nT - le nombre de points de données dans un ensemble de test

Forecast utilise la moyenne des prévisions comme valeur préditei,t, Lors du calcul des métriques prédictives, nT est le nombre de points de données dans une fenêtre de backtest.

Le RMSE utilise la valeur quadratique des valeurs résiduelles, ce qui amplifie l'impact des valeurs aberrantes. Dans les cas d'utilisation où seules quelques grandes erreurs de prédiction peuvent être très coûteuses, le RMSE est l'indicateur le plus pertinent.

Les prédicteurs créés avant le 11 novembre 2020 ont calculé le RMSE en utilisant le quantile de 0,5 (P50) par défaut. Forecast utilise désormais la prévision moyenne.

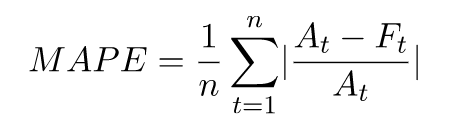

Pourcentage d'erreur absolu moyen (MAPE)

L'erreur moyenne absolue en pourcentage (MAPE) prend la valeur absolue du pourcentage d'erreur entre les valeurs observées et prévues pour chaque unité de temps, puis fait la moyenne de ces valeurs. Une valeur faible indique un modèle plus précis.

- Où :

-

A t - la valeur observée au point t

F t - la valeur prédite au point t

n - le nombre de points de données dans la série chronologique

Forecast utilise la prévision moyenne comme valeur prédite, t F.

Le MAPE est utile dans les cas où les valeurs diffèrent de manière significative entre les points temporels et où les valeurs aberrantes ont un impact significatif.

Erreur d'échelle absolue moyenne (MASE)

L'erreur d'échelle absolue moyenne (MASE) est calculée en divisant l'erreur moyenne par un facteur d'échelle. Ce facteur d'échelle dépend de la valeur de saisonnalité, m, qui est sélectionnée en fonction de la fréquence des prévisions. Une valeur faible indique un modèle plus précis.

- Où :

-

Y t - la valeur observée au point t

Y t-m - la valeur observée au point t-m

e j - l'erreur au point j (valeur observée - valeur prédite)

m - la valeur de saisonnalité

Forecast utilise la prévision moyenne comme valeur prédite.

MASE est idéal pour les ensembles de données de nature cyclique ou dotés de propriétés saisonnières. Par exemple, la prise en compte de l'impact saisonnier peut être utile pour prévoir les articles très demandés en été et en faible demande en hiver.

Exportation de mesures de précision

Note

Les fichiers d'exportation peuvent renvoyer directement les informations issues de l'importation du jeu de données. Cela rend les fichiers vulnérables aux injections CSV si les données importées contiennent des formules ou des commandes. Pour cette raison, les fichiers exportés peuvent provoquer des avertissements de sécurité. Pour éviter toute activité malveillante, désactivez les liens et les macros lors de la lecture des fichiers exportés.

Forecast vous permet d'exporter les valeurs prévisionnelles et les mesures de précision générées lors du backtesting.

Vous pouvez utiliser ces exportations pour évaluer des éléments spécifiques à des moments et à des quantiles spécifiques, afin de mieux comprendre votre prédicteur. Les exportations du backtest sont envoyées vers un emplacement S3 spécifié et contiennent deux dossiers :

-

valeurs prévisionnelles : contient des fichiers CSV ou Parquet avec des valeurs prévisionnelles pour chaque type de prévision pour chaque backtest.

-

accuracy-metrics-values: contient des fichiers CSV ou Parquet contenant les statistiques de chaque backtest, ainsi que la moyenne de tous les backtests. Ces métriques incluent le wQL pour chaque quantile, le wQL moyen, le RMSE, le MASE, le MAPE et le WAPE.

Le forecasted-values dossier contient des valeurs prévisionnelles pour chaque type de prévision pour chaque fenêtre de backtest. Il inclut également des informations sur l'article IDs, les dimensions, les horodatages, les valeurs cibles et les heures de début et de fin de la fenêtre de backtest.

Le accuracy-metrics-values dossier contient les mesures de précision pour chaque fenêtre de backtest, ainsi que les mesures moyennes pour toutes les fenêtres de backtest. Il contient des métriques wQL pour chaque quantile spécifié, ainsi que des métriques wQL, RMSE, MASE, MAPE et WAPE moyennes.

Les fichiers des deux dossiers suivent la convention de dénomination :<ExportJobName>_<ExportTimestamp>_<PartNumber>.csv.

Vous pouvez exporter des mesures de précision à l'aide du kit de développement logiciel (SDK) Amazon Forecast et de la console Amazon Forecast.

Choix des types de prévisions

Amazon Forecast utilise des types de prévisions pour créer des prévisions et évaluer des prédicteurs. Les types de prévisions se présentent sous deux formes :

-

Type de prévision moyenne : prévision utilisant la moyenne comme valeur attendue. Généralement utilisées comme prévisions ponctuelles pour un moment donné.

-

Type de prévision quantile : prévision à un quantile spécifié. Généralement utilisé pour fournir un intervalle de prévision, qui est une plage de valeurs possibles pour tenir compte de l'incertitude des prévisions. Par exemple, une prévision au

0.65quantile estimera une valeur inférieure à la valeur observée dans 65 % des cas.

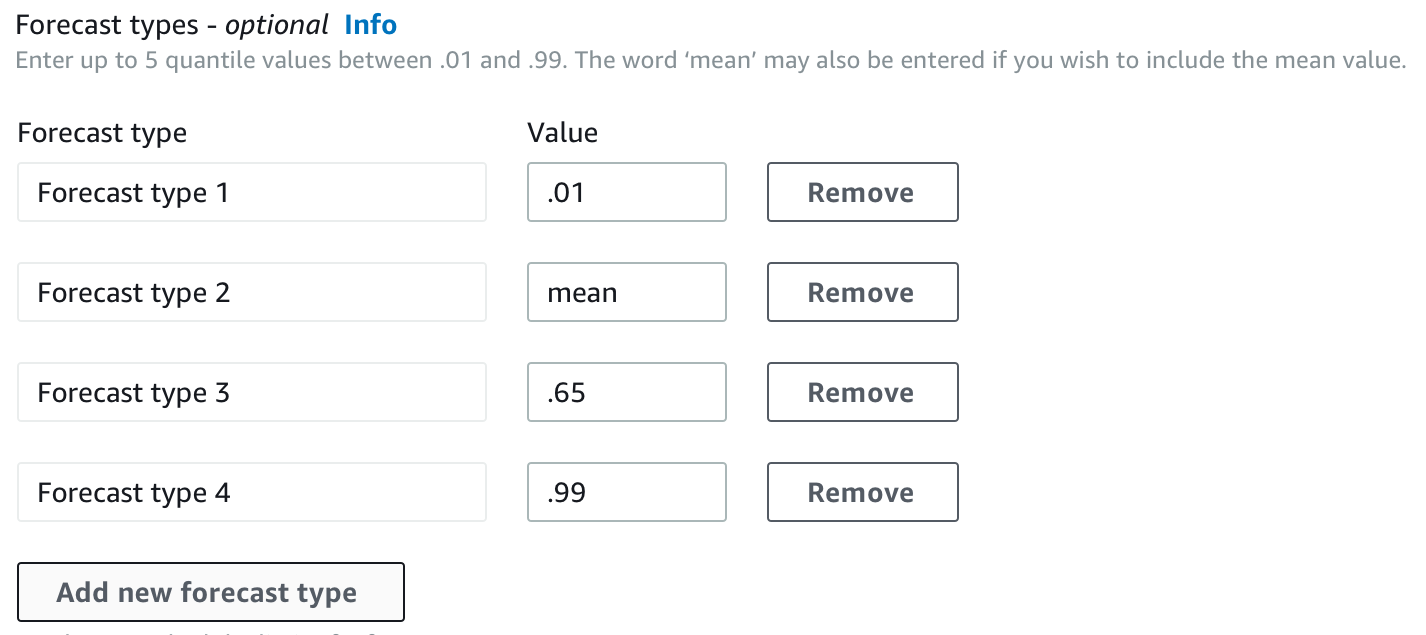

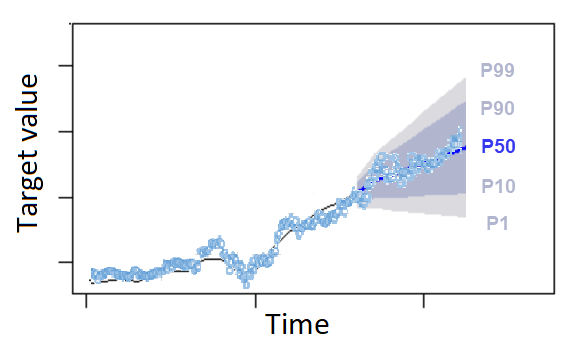

Par défaut, Forecast utilise les valeurs suivantes pour les types de prévisions des prédicteurs : 0.1 (P10), 0.5 (P50) et 0.9 (P90). Vous pouvez choisir jusqu'à cinq types de prévisions personnalisés, y compris mean des quantiles compris entre 0.01 (P1) et 0.99 (P99).

Les quantiles peuvent fournir une limite supérieure et inférieure pour les prévisions. Par exemple, l'utilisation des types de prévisions 0.1 (P10) et 0.9 (P90) fournit une plage de valeurs connue sous le nom d'intervalle de confiance à 80 %. La valeur observée devrait être inférieure à la valeur P10 10 % du temps, et la valeur P90 devrait être supérieure à la valeur observée 90 % du temps. En générant des prévisions à p10 et P90, vous pouvez vous attendre à ce que la valeur réelle se situe entre ces limites 80 % du temps. Cette plage de valeurs est illustrée par la zone ombrée entre P10 et P90 dans la figure ci-dessous.

Vous pouvez également utiliser une prévision quantile comme prévision ponctuelle lorsque le coût d'une sous-estimation est différent du coût d'une surestimation. Par exemple, dans certains cas de vente au détail, le coût d'un sous-stock est plus élevé que le coût d'un surstockage. Dans ces cas, la prévision à 0,65 (P65) est plus informative que la médiane (P50) ou la prévision moyenne.

Lorsque vous entraînez un prédicteur, vous pouvez choisir des types de prévisions personnalisés à l'aide du kit de développement logiciel (SDK) Amazon Forecast et de la console Amazon Forecast.

Utilisation des anciens prédicteurs

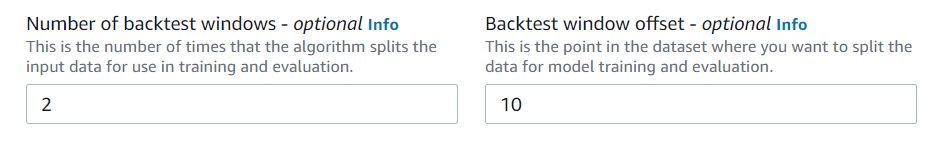

Configuration des paramètres de backtesting

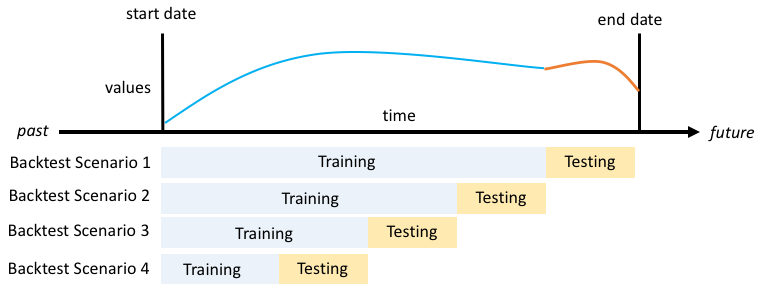

Forecast utilise le backtesting pour calculer les mesures de précision. Si vous effectuez plusieurs backtests, Forecast fait la moyenne de chaque métrique sur toutes les fenêtres de backtest. Par défaut, Forecast calcule un backtest, la taille de la fenêtre de backtest (ensemble de tests) étant égale à la longueur de l'horizon de prévision (fenêtre de prédiction). Vous pouvez définir à la fois la longueur de la fenêtre de backtest et le nombre de scénarios de backtest lors de l'entraînement d'un prédicteur.

Forecast omet les valeurs remplies du processus de backtest, et tout élément contenant des valeurs remplies dans une fenêtre de backtest donnée sera exclu de ce backtest. Cela est dû au fait que Forecast compare uniquement les valeurs prévues aux valeurs observées lors du backtesting, et les valeurs remplies ne sont pas des valeurs observées.

La fenêtre de backtest doit être au moins aussi grande que l'horizon de prévision et inférieure à la moitié de la longueur de l'ensemble de données chronologiques cible. Vous pouvez choisir entre 1 et 5 backtests.

En général, l'augmentation du nombre de backtests produit des mesures de précision plus fiables, car une plus grande partie des séries chronologiques est utilisée pendant les tests et Forecast est en mesure de prendre une moyenne des métriques pour tous les backtests.

Vous pouvez définir les paramètres du backtesting à l'aide du kit de développement logiciel (SDK) Amazon Forecast et de la console Amazon Forecast.

HPO et AutoML

Par défaut, Amazon Forecast utilise les quantiles 0.1 (P10), 0.5 (P50) et 0.9 (P90) pour le réglage des hyperparamètres lors de l'optimisation des hyperparamètres (HPO) et pour la sélection du modèle pendant AutoML. Si vous spécifiez des types de prévisions personnalisés lors de la création d'un prédicteur, Forecast utilise ces types de prévisions pendant HPO et AutoML.

Si des types de prévisions personnalisés sont spécifiés, Forecast utilise ces types de prévisions pour déterminer les résultats optimaux pendant HPO et AutoML. Pendant HPO, Forecast utilise la première fenêtre de backtest pour trouver les valeurs d'hyperparamètres optimales. Pendant AutoML, Forecast utilise les moyennes de toutes les fenêtres de backtest et les valeurs d'hyperparamètres optimales de HPO pour trouver l'algorithme optimal.

Pour AutoML et HPO, Forecast choisit l'option qui minimise les pertes moyennes par rapport aux types de prévisions. Vous pouvez également optimiser votre prédicteur pendant AutoML et HPO avec l'une des mesures de précision suivantes : perte quantile pondérée moyenne (WQL moyenne), erreur absolue pondérée en pourcentage (WAPE), erreur quadratique moyenne (RMSE), erreur moyenne absolue en pourcentage (MAPE) ou erreur graduelle absolue moyenne (MASE).

Vous pouvez choisir une métrique d'optimisation à l'aide du kit de développement logiciel (SDK) Amazon Forecast et de la console Amazon Forecast.