Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Migrer une base de données Oracle sur site vers Amazon RDS for Oracle à l'aide d'Oracle Data Pump

Mohan Annam et Brian Motzer, Amazon Web Services

Récapitulatif

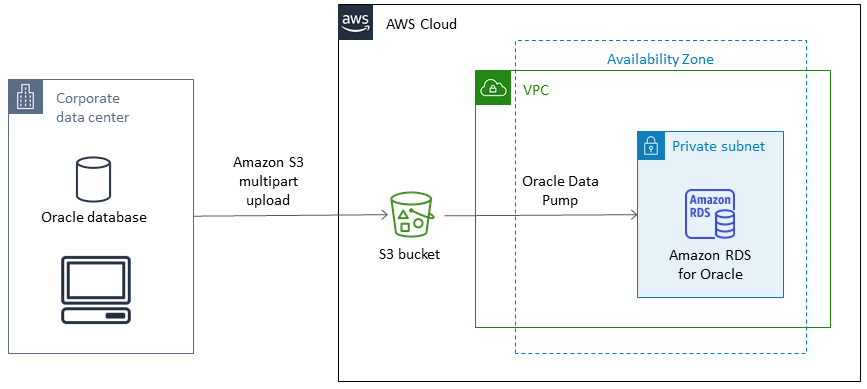

Ce modèle décrit comment migrer une base de données Oracle d'un centre de données sur site vers une instance de base de données Amazon Relational Database Service (Amazon RDS) pour Oracle à l'aide d'Oracle Data Pump.

Le modèle implique la création d'un fichier de vidage de données à partir de la base de données source, le stockage du fichier dans un bucket Amazon Simple Storage Service (Amazon S3), puis la restauration des données sur une instance de base de données Amazon RDS for Oracle. Ce modèle est utile lorsque vous rencontrez des difficultés lors de l'utilisation d'AWS Database Migration Service (AWS DMS) pour la migration.

Conditions préalables et limitations

Prérequis

Un compte AWS actif

Les autorisations requises pour créer des rôles dans AWS Identity and Access Management (IAM) et pour un téléchargement partitionné sur Amazon S3

Les autorisations requises pour exporter des données depuis la base de données source

Interface de ligne de commande (AWS CLI) (AWS CLI) installée et configurée

Versions du produit

Oracle Data Pump est uniquement disponible pour Oracle Database 10g version 1 (10.1) et versions ultérieures.

Architecture

Pile technologique source

Bases de données Oracle sur site

Pile technologique cible

Amazon RDS for Oracle

Client SQL (développeur Oracle SQL)

Compartiment S3

Architecture source et cible

Outils

Services AWS

AWS Identity and Access Management (IAM) vous aide à gérer en toute sécurité l'accès à vos ressources AWS en contrôlant qui est authentifié et autorisé à les utiliser. Dans ce modèle, IAM est utilisé pour créer les rôles et les politiques nécessaires à la migration des données d'Amazon S3 vers Amazon RDS for Oracle.

Amazon Relational Database Service (Amazon RDS) pour Oracle vous aide à configurer, exploiter et dimensionner une base de données relationnelle Oracle dans le cloud AWS.

Amazon Simple Storage Service (Amazon S3) est un service de stockage d'objets basé sur le cloud qui vous permet de stocker, de protéger et de récupérer n'importe quel volume de données.

Autres outils

Oracle Data Pump

vous aide à déplacer des données et des métadonnées d'une base de données à une autre à grande vitesse. Dans ce modèle, Oracle Data Pump est utilisé pour exporter le fichier de vidage de données (.dmp) vers le serveur Oracle et pour l'importer dans Amazon RDS for Oracle. Pour plus d'informations, consultez la section Importation de données dans Oracle sur Amazon RDS dans la documentation Amazon RDS. Oracle SQL Developer

est un environnement de développement intégré qui simplifie le développement et la gestion des bases de données Oracle dans les déploiements traditionnels et basés sur le cloud. Il interagit à la fois avec la base de données Oracle sur site et avec Amazon RDS for Oracle pour exécuter les commandes SQL nécessaires à l'exportation et à l'importation de données.

Épopées

| Tâche | Description | Compétences requises |

|---|---|---|

Créer le compartiment. | Pour créer le compartiment S3, suivez les instructions de la documentation AWS. | Administrateur système AWS |

| Tâche | Description | Compétences requises |

|---|---|---|

Configurez les autorisations IAM. | Pour configurer les autorisations, suivez les instructions de la documentation AWS. | Administrateur système AWS |

| Tâche | Description | Compétences requises |

|---|---|---|

Créez l'instance de base de données Amazon RDS for Oracle cible. | Pour créer l'instance Amazon RDS for Oracle, suivez les instructions de la documentation AWS. | Administrateur système AWS |

Associez le rôle à l'instance de base de données. | Pour associer le rôle à l'instance, suivez les instructions de la documentation AWS. | DBA |

| Tâche | Description | Compétences requises |

|---|---|---|

Créez l'utilisateur. | Connectez-vous à la base de données Amazon RDS for Oracle cible depuis Oracle SQL Developer ou SQL*Plus, puis exécutez la commande SQL suivante pour créer l'utilisateur dans lequel importer le schéma.

| DBA |

| Tâche | Description | Compétences requises |

|---|---|---|

Créez un fichier de vidage de données. | Pour créer un fichier de vidage nommé

Vérifiez les détails de l'exportation en consultant le | DBA |

| Tâche | Description | Compétences requises |

|---|---|---|

Téléchargez le fichier de vidage de données de la source vers le compartiment S3. | À l'aide de l'AWS CLI, exécutez la commande suivante.

| DBA |

| Tâche | Description | Compétences requises |

|---|---|---|

Téléchargez le fichier de vidage de données sur Amazon RDS | Pour copier le fichier

La commande précédente génère un identifiant de tâche. Pour vérifier l'état du téléchargement en consultant les données contenues dans l'ID de tâche, exécutez la commande suivante.

Pour voir les fichiers du

| Administrateur système AWS |

| Tâche | Description | Compétences requises |

|---|---|---|

Restaurez le schéma et les données sur Amazon RDS. | Pour importer le fichier de vidage dans le schéma

Pour consulter le fichier journal de l'importation, exécutez la commande suivante.

| DBA |

| Tâche | Description | Compétences requises |

|---|---|---|

Répertoriez et nettoyez les fichiers d'exportation. | Répertoriez et supprimez les fichiers d'exportation dans le

| Administrateur système AWS |