Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Lo scenario seguente descrive un'applicazione di e-commerce senza server e basata sugli eventi che utilizza AWS Event Fork Pipelines. È possibile utilizzare questo esempio di applicazione di e-commerce

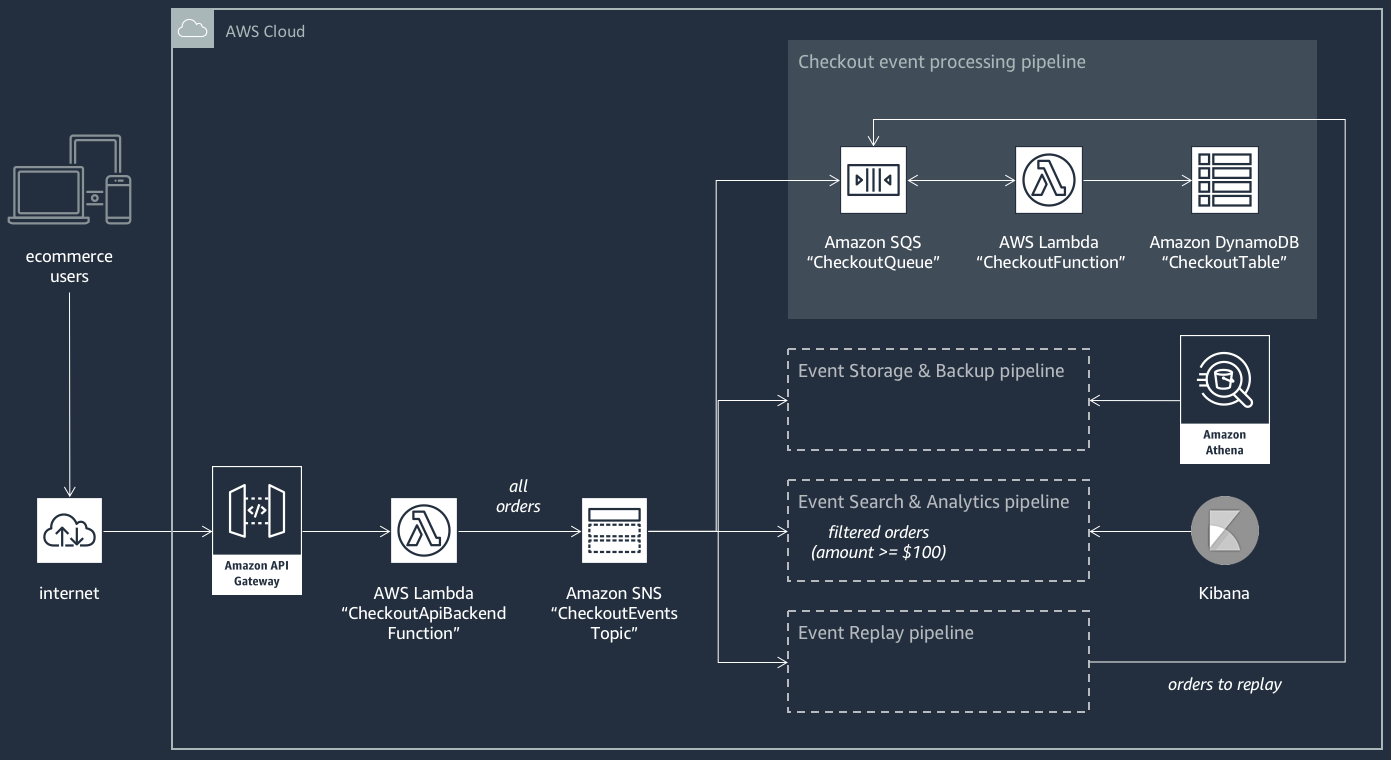

Questa applicazione di e-commerce riceve gli ordini dagli acquirenti tramite un' RESTful API ospitata da API Gateway e supportata dalla AWS Lambda funzioneCheckoutApiBackendFunction. La funzione pubblica tutti gli ordini ricevuti in un argomento Amazon SNS denominato CheckoutEventsTopic che, a sua volta, li distribuisce a quattro diverse pipeline.

La prima è la normale pipeline di elaborazione del checkout progettata e implementata dal proprietario dell'applicazione di E-Commerce. Questa pipeline include la CheckoutQueue coda Amazon SQS che memorizza nel buffer tutti gli ordini ricevuti, AWS Lambda una funzione CheckoutFunction denominata che esegue il polling della coda per elaborare questi ordini e la tabella DynamoDB che salva in modo sicuro tutti gli ordini effettuati. CheckoutTable

Applicazione di Event Fork AWS Pipelines

La logica di business principale è gestita dai componenti dell'applicazione di E-Commerce, il cui proprietario deve comunque tenere conto anche dei seguenti fattori:

-

Conformità—backup protetti e compressi crittografati a riposo e sanificazione delle informazioni sensibili

-

Resilienza—riproduzione degli ordini più recenti in caso di interruzione del processo di evasione

-

Searchability—esecuzione di analisi e generazione di metriche sugli ordini effettuati

Invece di implementare questa logica di elaborazione degli eventi, il proprietario dell'applicazione può sottoscrivere AWS Event Fork Pipelines all'argomento Amazon CheckoutEventsTopic SNS

-

La pipeline di archiviazione di eventi e di backup è configurata per trasformare i dati in modo da rimuovere i dettagli delle carte di credito, eseguire il buffer dei dati per 60 secondi, comprimerli usando GZIP e crittografarli tramite la chiave predefinita gestita dal cliente per Amazon S3. Questa chiave è gestita AWS e alimentata da (). AWS Key Management Service AWS KMS

Per ulteriori informazioni, consulta Scegli Amazon S3 per la tua destinazione, Amazon Data Firehose Data Transformation e Configure Settings nella Amazon Data Firehose Developer Guide.

-

La pipeline di ricerca di eventi e di analisi dei dati è configurata con un valore di 30 secondi per la durata dei nuovi tentativi di indice, un bucket per lo storage di ordini non indicizzati nel dominio di ricerca e una policy di filtro per limitare il set degli ordini indicizzati.

Per ulteriori informazioni, consulta Scegli il OpenSearch servizio per la tua destinazione nella Amazon Data Firehose Developer Guide.

-

Pipeline di riproduzione eventi è configurata con la coda Amazon SQS che fa parte della normale pipeline di elaborazione degli ordini progettata e implementata dal proprietario dell'applicazione di E-Commerce.

Per ulteriori informazioni, consulta la sezione al Nome della coda e URL nella Guida per gli sviluppatori di Amazon Simple Queue Service.

Nella configurazione per la pipeline di ricerca di eventi e di analisi è impostata la seguente policy di filtro in formato JSON, che trova solo ordini in entrata il cui importo totale sia di 100 dollari o più. Per ulteriori informazioni, consulta Filtraggio messaggi di Amazon SNS.

{

"amount": [{ "numeric": [ ">=", 100 ] }]

}Utilizzando il pattern AWS Event Fork Pipelines, il proprietario dell'applicazione di e-commerce può evitare il sovraccarico di sviluppo che spesso deriva dalla logica di codifica indifferenziata per la gestione degli eventi. Invece, può implementare AWS Event Fork Pipelines direttamente dal suo interno. AWS Serverless Application Repository Account AWS