As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Gere insights de z/OS dados do Db2 usando AWS Mainframe Modernization o Amazon Q em QuickSight

Shubham Roy, Roshna Razack e Santosh Kumar Singh, da Amazon Web Services

Resumo

Se sua organização está hospedando dados essenciais para os negócios em um ambiente de mainframe IBM Db2, obter insights desses dados é crucial para impulsionar o crescimento e a inovação. Ao desbloquear dados do mainframe, você pode criar inteligência de negócios mais rápida, segura e escalável para acelerar a tomada de decisões, o crescimento e a inovação orientados por dados na nuvem da Amazon Web Services ().AWS

Esse padrão apresenta uma solução para gerar insights de negócios e criar narrativas compartilháveis a partir de dados de mainframe no IBM Db2 for tables. z/OS As alterações nos dados do mainframe são transmitidas para o tópico Amazon Managed Streaming for Apache Kafka (AmazonAWS Mainframe Modernization MSK) usando a replicação de dados com o Preciously. Usando a ingestão de streaming do Amazon Redshift, os dados de tópicos do Amazon MSK são armazenados em tabelas de armazém de dados do Amazon Redshift Serverless para análise na Amazon. QuickSight

Depois que os dados estiverem disponíveis QuickSight, você poderá usar solicitações em linguagem natural com o Amazon Q in QuickSight para criar resumos dos dados, fazer perguntas e gerar histórias de dados. Você não precisa escrever consultas SQL ou aprender uma ferramenta de business intelligence (BI).

Contexto de negócios

Esse padrão apresenta uma solução para casos de uso de análises de dados de mainframe e insights de dados. Usando o padrão, você cria um painel visual para os dados da sua empresa. Para demonstrar a solução, esse padrão usa uma empresa de assistência médica que fornece planos médicos, odontológicos e oftalmológicos para seus membros nos EUA. Neste exemplo, as informações demográficas e do plano dos membros são armazenadas no IBM Db2 para tabelas de z/OS dados. O painel visual mostra o seguinte:

Distribuição de membros por região

Distribuição de membros por gênero

Distribuição de membros por idade

Distribuição de membros por tipo de plano

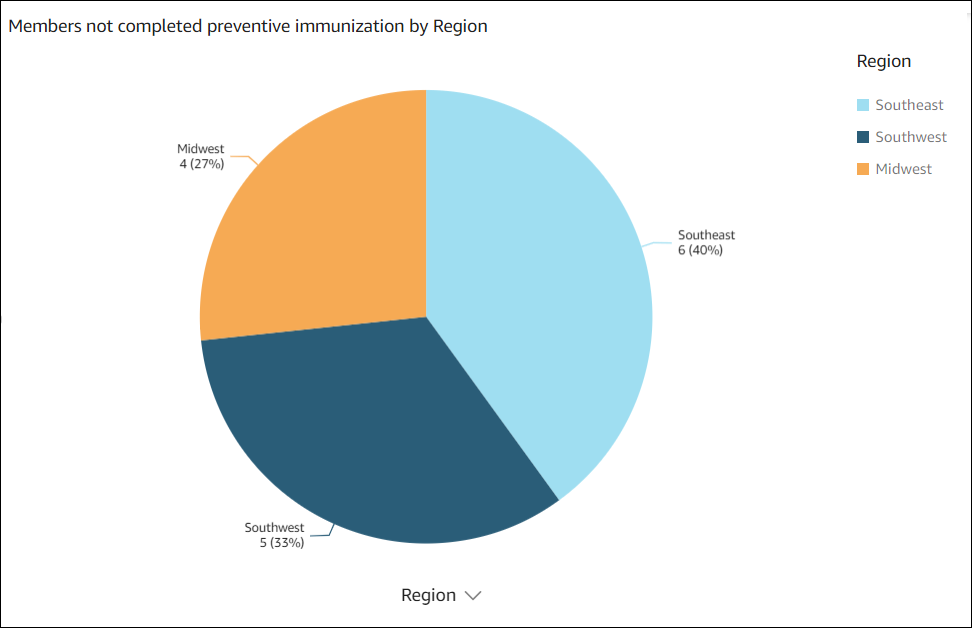

Membros que não concluíram a imunização preventiva

Para exemplos de distribuição de membros por região e membros que não concluíram a imunização preventiva, consulte a seção Informações adicionais.

Depois de criar o painel, você gera uma história de dados que explica os insights da análise anterior. A história dos dados fornece recomendações para aumentar o número de membros que concluíram as imunizações preventivas.

Pré-requisitos e limitações

Pré-requisitos

Um ativo Conta da AWS. Essa solução foi criada e testada no Amazon Linux 2 no Amazon Elastic Compute Cloud (Amazon EC2).

Uma nuvem privada virtual (VPC) com uma sub-rede que pode ser acessada pelo seu sistema de mainframe.

Um banco de dados de mainframe com dados comerciais. Para ver os dados de exemplo usados para criar e testar essa solução, consulte a seção Anexos.

Captura de dados de alteração (CDC) ativada nas tabelas do Db2 z/OS . Para habilitar o CDC no Db2 z/OS, consulte a documentação da IBM.

Conecte o CDC com precisão para z/OS instalação no z/OS sistema que hospeda os bancos de dados de origem. O CDC Preciously Connect para z/OS imagem é fornecido como um arquivo zip no AWS Mainframe Modernization - Data Replication for IBM z/OS Amazon Machine Image (AMI). Para instalar o Preciously Connect CDC z/OS no mainframe, consulte a documentação de instalação do Precisely Connect.

Limitações

Os dados do seu mainframe Db2 devem estar em um tipo de dados compatível com o Precisely Connect CDC. Para obter uma lista dos tipos de dados compatíveis, consulte a documentação do CDC do Precisely Connect.

Seus dados no Amazon MSK devem estar em um tipo de dados compatível com o Amazon Redshift. Para obter uma lista dos tipos de dados compatíveis, consulte a documentação do Amazon Redshift.

O Amazon Redshift tem comportamentos e limites de tamanho diferentes para diferentes tipos de dados. Para obter mais informações, consulte a documentação do Amazon Redshift.

Os dados quase em tempo real QuickSight dependem do intervalo de atualização definido para o banco de dados do Amazon Redshift.

Alguns Serviços da AWS não estão disponíveis em todos Regiões da AWS. Para ver a disponibilidade da região, consulte Serviços da AWS por região. No momento, o Amazon Q in QuickSight não está disponível em todas as regiões que oferecem suporte QuickSight. Para endpoints específicos, consulte a página de endpoints e cotas do serviço e escolha o link para o serviço.

Versões do produto

AWS Mainframe Modernization Replicação de dados com a versão 4.1.44 do Precision

Python versão 3.6 ou posterior

Apache Kafka versão 3.5.1

Arquitetura

Arquitetura de destino

O diagrama a seguir mostra uma arquitetura para gerar insights de negócios a partir de dados de mainframe usando a replicação de AWS Mainframe Modernization dados com o Precisely e o Amazon Q in. QuickSight

O diagrama mostra o seguinte fluxo de trabalho:

O Preciously Log Reader Agent lê dados dos registros do Db2 e grava os dados em armazenamento temporário em um sistema de arquivos OMVS no mainframe.

O Publisher Agent lê os registros brutos do Db2 a partir do armazenamento temporário.

O daemon do controlador local autentica, autoriza, monitora e gerencia as operações.

O Apply Agent é implantado na Amazon EC2 usando a AMI pré-configurada. Ele se conecta ao Publisher Agent por meio do daemon do controlador usando TCP/IP. O Apply Agent envia dados para o Amazon MSK usando vários trabalhadores para obter uma alta taxa de transferência.

Os trabalhadores gravam os dados no tópico do Amazon MSK no formato JSON. Como destino intermediário para as mensagens replicadas, o Amazon MSK fornece recursos de failover automatizados e altamente disponíveis.

A ingestão de streaming do Amazon Redshift fornece ingestão de dados de baixa latência e alta velocidade do Amazon MSK para um banco de dados Amazon Redshift Serverless. Um procedimento armazenado no Amazon Redshift realiza a reconciliação dos dados de alteração do mainframe (insert/update/deletes) nas tabelas do Amazon Redshift. Essas tabelas do Amazon Redshift servem como fonte de análise de dados para. QuickSight

Os usuários acessam os dados QuickSight para análises e insights. Você pode usar o Amazon Q in QuickSight para interagir com os dados usando prompts em linguagem natural.

Ferramentas

Serviços da AWS

A Amazon Elastic Compute Cloud (Amazon EC2) fornece capacidade de computação escalável na Nuvem AWS. Você pode iniciar quantos servidores virtuais precisar e escalá-los rapidamente para cima ou para baixo.

AWS Key Management Service (AWS KMS) ajuda você a criar e controlar chaves criptográficas para ajudar a proteger seus dados.

O Amazon Managed Streaming for Apache Kafka (Amazon MSK) é um serviço totalmente gerenciado que ajuda você a criar e executar aplicações que usam o Apache Kafka para processar dados em streaming.

QuickSightA Amazon é um serviço de inteligência de negócios (BI) em escala de nuvem que ajuda você a visualizar, analisar e relatar seus dados em um único painel. Esse padrão usa os recursos generativos de BI do Amazon Q in QuickSight.

O Amazon Redshift Serverless é uma opção sem servidor do Amazon Redshift que torna mais eficiente executar e escalar análises em segundos, sem a necessidade de configurar e gerenciar a infraestrutura de armazém de dados.

O AWS Secrets Manager ajuda a substituir credenciais codificadas, incluindo senhas, por uma chamada de API ao Secrets Manager para recuperar o segredo por programação.

Outras ferramentas

Repositório de código

O código desse padrão está disponível no repositório GitHub Mainframe_ DataInsights _change_data_reconciliation. O código é um procedimento armazenado no Amazon Redshift. Esse procedimento armazenado reconcilia as alterações de dados do mainframe (inserções, atualizações e exclusões) do Amazon MSK com as tabelas do Amazon Redshift. Essas tabelas do Amazon Redshift servem como fonte de análise de dados para. QuickSight

Práticas recomendadas

Épicos

| Tarefa | Descrição | Habilidades necessárias |

|---|

Configure um grupo de segurança. | Para se conectar ao daemon do controlador e ao cluster Amazon MSK, crie um grupo de segurança para a instância. EC2 Adicione as seguintes regras de entrada e saída: Regra de entrada 1: Em Tipo, escolha TCP personalizado. Para Protocolo, escolha TCP. Em Intervalo de portas, escolha 2626 (porta padrão para o daemon do controlador Preciously) ou o número da porta do daemon do controlador em execução no mainframe. Em Source, escolha Bloco CIDR.

Regra de entrada 2: Em Type (Tipo), escolha Custom TCP (TCP personalizada). Em Protocolo, escolha SSH. Em Intervalo de portas, escolha 22. Em Origem, escolha endereço IP ou lista de prefixos.

Regra de entrada 3: Em Type (Tipo), escolha Custom TCP (TCP personalizada). Para Protocolo, escolha TCP. Em Intervalo de portas, escolha 9092-9098. Em Source, escolha Bloco CIDR.

Regra de saída 1: Em Type (Tipo), escolha Custom TCP (TCP personalizada). Para Protocolo, escolha TCP. Em Intervalo de portas, escolha 9092-9098. Em Source, escolha Bloco CIDR.

Regra de saída 2: Em Type (Tipo), escolha Custom TCP (TCP personalizada). Para Protocolo, escolha TCP. Em Intervalo de portas, escolha 2626 (porta padrão para o daemon do controlador Preciously) ou o número da porta do daemon do controlador em execução no mainframe. Em Source, escolha Bloco CIDR.

Anote o nome do grupo de segurança. Você precisará referenciar o nome ao iniciar a EC2 instância e configurar o cluster Amazon MSK. | DevOps engenheiro, AWS DevOps |

Crie uma política do IAM e uma função do IAM. | Para criar uma política do IAM e uma função do IAM, siga as instruções na documentação da AWS. A política do IAM concede acesso para criar tópicos no cluster Amazon MSK e enviar dados para esses tópicos. Depois de criar a função do IAM, associe a política a ela. Observe o nome da função do IAM. Essa função será usada como o perfil da instância do IAM quando você executar a EC2 instância.

| DevOps engenheiro, administrador de sistemas da AWS |

Provisione uma EC2 instância. | Para provisionar uma EC2 instância para executar o Preciously CDC e conectar-se ao Amazon MSK, faça o seguinte: Faça login no AWS Marketplace e assine o AWS Mainframe Modernization ‒ Replicação de dados para IBM z/OS. Selecione a AMI nas assinaturas gerenciadas e escolha Launch new instance. Forneça outros detalhes de configuração, como nome da instância, tipo de instância, key pair, VPC e sub-redes. Para obter mais informações, consulte a EC2 documentação da Amazon. Na lista suspensa, escolha o grupo de segurança que você criou anteriormente. Em Detalhes avançados, perfil da instância do IAM, você deve selecionar a função que você criou anteriormente. Escolha Iniciar instância.

| Administrador e DevOps engenheiro da AWS |

| Tarefa | Descrição | Habilidades necessárias |

|---|

Crie o cluster do Amazon MSK. | Para criar um cluster Amazon MSK, faça o seguinte: Faça login no AWS Management Console e abra o console do Amazon MSK em https://console.aws.amazon.com/msk/. Selecione Criar cluster. Para o método de criação de cluster, escolha Criação personalizada e, para o tipo de cluster, escolha Provisionado. Forneça um nome para o cluster. Atualize as configurações do cluster conforme necessário e mantenha os padrões para as outras configurações. Observe a versão < Kafka>. Você precisará dele durante a configuração do cliente Kafka. Escolha Próximo. Escolha a mesma VPC e sub-redes que você usou para a EC2 instância Preciously e escolha o grupo de segurança que você criou anteriormente. Na seção Configurações de segurança, ative a autenticação baseada em funções SASL/SCRAM e IAM. O CDC Precision Connect usa SASL/SCRAM (Simple Authentication and Security Layer/Salted Challenge Response Mechanism), e o IAM é necessário para se conectar ao Amazon Redshift. Escolha Próximo. Para análise, escolha o método de monitoramento e entrega de registros do Broker. Escolha Avançar e, em seguida, escolha Criar o cluster.

Um cluster provisionado típico leva até 15 minutos para ser criado. Depois que o cluster é criado, seu status muda de Criando para Ativo. | AWS DevOps, administrador de nuvem |

Configure a SASL/SCRAM autenticação. | Para configurar a SASL/SCRAM autenticação para um cluster Amazon MSK, faça o seguinte: Para configurar um segredo no Secrets Manager, siga as instruções na AWS documentação. Abra o console do Amazon MSK e selecione o cluster do Amazon MSK que você criou anteriormente. Escolha a guia Properties (Propriedades). Escolha Associar segredos, Escolha os segredos, selecione a chave secreta que você criou e escolha Associar segredos. Você verá uma mensagem de sucesso semelhante à seguinte: Successfully associated 1 secret for cluster <chosen cluster name>

Escolha o nome do cluster. No resumo do cluster, escolha Exibir informações do cliente. Observe a cadeia de conexão privada do endpoint para o tipo de autenticação SASL/SCRAM.

| Arquiteto de nuvem |

Crie o tópico do Amazon MSK. | Para criar o tópico do Amazon MSK, faça o seguinte: Conecte-se à EC2 instância que você criou anteriormente e instale as atualizações mais recentes executando o seguinte comando: sudo yum update -y

Instale a biblioteca Java e Kafka executando o seguinte comando: sudo yum install -y java-11 librdkafka librdkafka-devel

Para criar uma pasta chamada kafka in/home/ec2-user, navegue até essa pasta e execute o seguinte comando: mkdir kafka;cd kafka

Faça o download da biblioteca do kafka cliente para a kafka pasta, <YOUR MSK VERSION> substituindo-a pela versão do Kafka que você anotou durante a criação do cluster Amazon MSK: wget https://archive.apache.org/dist/kafka//kafka_2.13-<YOUR MSK VERSION>.tgz

Para extrair o arquivo baixado, execute o seguinte comando, substituindoYOUR MSK VERSION>: tar -xzf kafka_2.13-<YOUR MSK VERSION>.tgz

Para navegar até o kafka libs diretório e baixar o arquivo Java Archive (JAR) de autenticação do Java IAM, execute os seguintes comandos, substituindo<YOUR MSK VERSION>: cd kafka_2.13-<YOUR MSK VERSION>/libs

wget https://github.com/aws/aws-msk-iam-auth/releases/download/v1.1.1/aws-msk-iam-auth-1.1.1-all.jarkafka

Para navegar até o bin diretório do Kafka e criar o client.properties arquivo, execute os seguintes comandos: cd /home/ec2-user/kafka/kafka_2.13-<YOUR MSK VERSION>/bin

cat >client.properties

Atualize o client.properties arquivo com o seguinte conteúdo: security.protocol=SASL_SSL

sasl.mechanism=AWS_MSK_IAM

sasl.jaas.config=software.amazon.msk.auth.iam.IAMLoginModule required;

sasl.client.callback.handler.class=software.amazon.msk.auth.iam.IAMClientCallbackHandler

Para criar um tópico do Kafka, navegue até o compartimento do Kafka e execute o seguinte comando, <kafka broker> substituindo-o pelo endpoint privado do servidor de bootstrap do IAM que você observou durante a criação do cluster Amazon MSK: ./kafka-topics.sh --bootstrap-server <kafka broker> --command-config client.properties --create --replication-factor 3 —partitions 6 --topic <topic name>

Quando a mensagem Created topic <topic name> aparecer, anote o nome do tópico.

| Administrador de nuvem |

| Tarefa | Descrição | Habilidades necessárias |

|---|

Configure os scripts Precisely para replicar as alterações nos dados. | Para configurar os scripts do CDC Precisely Connect para replicar dados alterados do mainframe para o tópico do Amazon MSK, faça o seguinte: Para criar um nome de pasta com precisão e mudar para essa pasta, execute o seguinte comando: mkdir /home/ec2-user/precisely;cd /home/ec2-user/precisely

Para criar duas pastas dentro precisamente chamadas de scripts e eddls, em seguida, mudar para a scripts pasta, execute o seguinte comando: mkdir scripts;mkdir ddls;cd scripts

Para criar um arquivo nomeado sqdata_kafka_producer.conf na scripts pasta, execute o seguinte comando: cat >sqdata_kafka_producer.conf

Atualize o sqdata_kafka_producer.conf arquivo com o seguinte conteúdo: builtin.features=SASL_SCRAM

security.protocol=SASL_SSL

sasl.mechanism=SCRAM-SHA-512

sasl.username=<User Name>

sasl.password=<Password>

metadata.broker.list=<SASL/SCRAM Bootstrap servers>

Atualize <SASL/SCRAM Bootstrap servers> com a lista de agentes do Amazon SASL/SCRAM MSK que você configurou anteriormente. Atualize <User Name> e <Password> com o nome de usuário e senha que você configurou anteriormente no Secrets Manager. Crie um script.sqd arquivo na scripts pasta. cat >script.sqd

O Apply Engine usa script.sqd para processar dados de origem e replicar os dados de origem para o destino. Para ver um exemplo de script do Apply Engine, consulte a seção Informações adicionais. Para mudar para a ddls pasta e criar um arquivo.ddl para cada tabela do Db2, execute os seguintes comandos: cd /home/ec2-user/precisely/ddls

cat >mem_details.ddl

cat >mem_plans.ddl

Por exemplo, arquivos.ddl, consulte a seção Informações adicionais. | Desenvolvedor de aplicativos, arquiteto de nuvem |

Gere a chave ACL da rede. | Para gerar a chave da lista de controle de acesso à rede (Network ACL), faça o seguinte: Para exportar o caminho de sqdata instalação, execute o seguinte comando: export PATH=$PATH:/usr/sbin:/opt/precisely/di/sqdata/bin

Para mudar para o /home/ec2-user diretório e gerar a chave ACL de rede, execute os seguintes comandos: cd /home/ec2-user

sqdutil keygen --force

Depois que as chaves públicas e privadas são geradas, a seguinte mensagem é exibida: SQDUT04I Generating a private key in file /home/ec2-user/.nacl/id_nacl

SQDC017I sqdutil(pid=27344) terminated successfully

Observe a chave pública gerada que está armazenada na .nacl pasta.

| Arquiteto de nuvem, AWS DevOps |

| Tarefa | Descrição | Habilidades necessárias |

|---|

Configure os padrões na tela do ISPF. | Para definir as configurações padrão no Interactive System Productivity Facility (ISPF), siga as instruções na documentação do Precisely. | Administrador do sistema de mainframe |

Configure o daemon do controlador. | Para configurar o daemon do controlador, faça o seguinte: Na tela do menu principal do SQData z/OS, escolha a opção 2. Na tela Adicionar Daemon à Lista, no campo Nome do Daemon, insira um nome para o daemon e pressione Enter.

| Administrador do sistema de mainframe |

Configure o editor. | Para configurar o editor, faça o seguinte: Na tela do menu principal do SQData z/OS, escolha a opção 3. Isso leva você para a tela de resumo do Capture/Publisher. Escolha a opção para adicionar um arquivo CAB. Isso o levará para a tela Adicionar arquivo CAB à lista. No campo Nome, insira um nome para o arquivo CAB. Para Db2, insira o Tipo comoD. Pressione Enter. Isso leva você para a tela Create New Db2 Capture CAB File. No campo zFS Dir, especifique o ponto de montagem do armazenamento. Pressione Enter para salvar e continuar.

| Administrador do sistema de mainframe |

Atualize o arquivo de configuração do daemon. | Para atualizar os detalhes do editor no arquivo de configuração do daemon do controlador, faça o seguinte: Na tela do menu principal do SQData z/OS, escolha a opção 2. Entre S perto do daemon que você criou para ver os detalhes do daemon. Enter e1, em seguida, pressione Enter para editar o arquivo do agente. Adicione os detalhes do seu arquivo CAB. O exemplo a seguir mostra os detalhes de um arquivo CAB chamadoDB2ZTOMSK. Use seu ID de usuário do mainframe em vez de. <userid> ÝDB2ZTOMSK¨

type=capture

cab=/u/<userid>/sqdata/DB2ZTOMSK.cab

Pressione F3. Digite 2 para editar o arquivo ACL. Adicione seu userid ao arquivo acl de configuração conforme mostrado no exemplo a seguir: Ýacls¨

prod=admin,<userid>

Pressione F3 para salvar e sair.

| Administrador do sistema de mainframe |

Crie o trabalho para iniciar o daemon do controlador. | Para criar o trabalho, faça o seguinte: Em Opções, insiraG. Insira o cartão de trabalho, as bibliotecas de tarefas e processos e os detalhes Db2 load da biblioteca. Insira os detalhes do arquivo ACL de rede e insira a opção 2 para gerar o arquivo de linguagem de controle de tarefas (JCL) na biblioteca de tarefas especificada.

| Administrador do sistema de mainframe |

Gere o arquivo JCL do editor de captura. | Para gerar o arquivo JCL do editor de captura, faça o seguinte: Na tela do menu principal do SQData z/OS, escolha a opção 3. Isso leva você para a tela de resumo do Capture/Publisher. Digite S ao lado do arquivo CAB para selecioná-lo. Isso leva você para a tela Db2 Capture/Publisher Detail. Em Opções, insira G as opções para gerar o capture/publisher trabalho. Insira o cartão JOB, as bibliotecas de tarefas e procedimentos e os detalhes da biblioteca de carga do Db2. Para criar o trabalho, escolha a opção 4. O trabalho é criado na biblioteca de trabalhos especificada na biblioteca de trabalhos.

| Administrador do sistema de mainframe |

Verifique e atualize o CDC. | Verifique o DATACAPTURE sinalizador da tabela Db2 executando a consulta a seguir, alterando <table name> para o nome da tabela Db2: SELECT DATACAPTURE FROM SYSIBM.SYSTABLES WHERE NAME='<table name>';

Confirme se o resultado é exibido DATACAPTURE comoY. Se não DATACAPTURE estiverY, execute a consulta a seguir para habilitar o CDC na tabela Db2, alterando <table name> para o nome da tabela Db2: ALTER TABLE <table name> DATA CAPTURE CHANGES;

| Administrador do sistema de mainframe |

Envie os arquivos JCL. | Envie os seguintes arquivos JCL que você configurou nas etapas anteriores: Depois de enviar os arquivos JCL, você pode iniciar o Apply Engine em Precisly na EC2 instância. | Administrador do sistema de mainframe |

| Tarefa | Descrição | Habilidades necessárias |

|---|

Inicie o Apply Engine e valide o CDC. | Para iniciar o Apply Engine na EC2 instância e validar o CDC, faça o seguinte: Para se conectar à EC2 instância, siga as instruções na AWS documentação. Vá para o diretório que contém o script.sqd arquivo: cd /home/ec2-user/precisely/scripts

Para iniciar o Apply Engine, execute o seguinte comando sqdeng start: sqdeng -s script.sqd --identity=/home/ec2-user/.nacl/id_nacl

O Apply Engine começará a aguardar atualizações da fonte do mainframe. Para testar o CDC, faça algumas inserções ou atualizações de registros na tabela Db2. Verifique se o registro do Apply Engine mostra o número de registros capturados e gravados no destino.

| Arquiteto de nuvem, desenvolvedor de aplicativos |

Valide os registros no tópico do Amazon MSK. | Para ler a mensagem do tópico Kafka, faça o seguinte: Para mudar para o bin diretório do caminho de instalação do cliente Kafka na EC2 instância, execute o comando a seguir, <Kafka version> substituindo-o pela sua versão: cd /home/ec2-user/kafka/kafka_2.13-<Kafka version>/bin

Para validar o Db2 CDC escrito como mensagens no tópico do Kafka, execute o comando a seguir, substituindo <kafka broker> e pelo tópico que você <Topic Name> criou anteriormente: ./kafka-console-consumer.sh --bootstrap-server <kafka broker>:9098 --topic <Topic Name> --from-beginning --consumer.config client.properties

Valide se as mensagens correspondem ao número de registros atualizados na tabela Db2.

| Desenvolvedor de aplicativos, arquiteto de nuvem |

| Tarefa | Descrição | Habilidades necessárias |

|---|

Configure o Amazon Redshift Serverless. | Para criar um armazém de dados sem servidor do Amazon Redshift, siga as instruções na documentação.AWS No painel do Amazon Redshift Serverless, valide se o namespace e o grupo de trabalho foram criados e estão disponíveis. Para esse exemplo de padrão, o processo pode levar de 2 a 5 minutos. | Engenheiro de dados |

Configure a função do IAM e a política de confiança necessárias para a ingestão de streaming. | Para configurar a ingestão de streaming sem servidor do Amazon Redshift a partir do Amazon MSK, faça o seguinte: Crie uma política do IAM para o Amazon Redshift acessar o Amazon MSK. [region]Substituindo Região da AWS pelo do Amazon MSK, [account-id] pelo seu Conta da AWS ID e [msk-cluster-name] pelo nome do cluster do Amazon MSK, execute o seguinte código:

{"Version": "2012-10-17", "Statement": [{"Sid": "MSKIAMpolicy","Effect": "Allow","Action": ["kafka-cluster:ReadData","kafka-cluster:DescribeTopic","kafka-cluster:Connect"],"Resource": ["arn:aws:kafka:[region]:[account-id]:cluster/[msk-cluster-name]/*","arn:aws:kafka:[region]:[account-id]:topic/[msk-cluster-name]/*"]},{"Effect": "Allow","Action": ["kafka-cluster:AlterGroup","kafka-cluster:DescribeGroup"],"Resource": ["arn:aws:kafka:[region]:[account-id]:group/[msk-cluster-name]/*"]}]}

Você pode encontrar o nome do cluster e o Amazon Resource Name (ARN) no console do Amazon MSK. No console, escolha Resumo do cluster e, em seguida, escolha ARN. Para criar uma função do IAM e anexar a política, siga as instruções na AWS documentação. Para anexar a função do IAM ao namespace Amazon Redshift Serverless, faça o seguinte: Faça login no console e abra o console do Amazon Redshift em. https://console.aws.amazon.com/redshiftv2/ Escolha o Serverless dashboard (Painel do Serverless). Escolha Namespace. Escolha a guia Segurança e criptografia. Escolha Permissão e anexe a função do IAM que você criou.

Em seu grupo de segurança Amazon Redshift Serverless, crie uma regra de entrada com os seguintes detalhes: Em Type (Tipo), escolha Custom TCP (TCP personalizada). Para Protocolo, escolha TCP. Em Intervalo de portas, escolha 9098, 9198. Em Source, escolha o grupo de segurança Amazon MSK.

No seu grupo de segurança do Amazon MSK, crie uma regra de entrada com os seguintes detalhes: Em Type (Tipo), escolha Custom TCP (TCP personalizada). Para Protocolo, escolha TCP. Em Intervalo de portas, escolha 9098, 9198. Em Source, escolha o grupo de segurança do Amazon Redshift.

Esse padrão usa a porta para autenticação do IAM para a configuração do Amazon Redshift e do Amazon MSK. Para obter mais informações, consulte a AWS documentação (etapa 2). Ative o roteamento de VPC aprimorado para o grupo de trabalho Amazon Redshift Serverless. Para obter mais informações, consulte a documentação do AWS.

| Engenheiro de dados |

Conecte o Amazon Redshift Serverless ao Amazon MSK. | Para se conectar ao tópico do Amazon MSK, crie um esquema externo no Amazon Redshift Serverless. No editor de consultas v2 do Amazon Redshift, execute o seguinte comando SQL, 'iam_role_arn' substituindo pela função que você criou anteriormente e substituindo 'MSK_cluster_arn 'pelo ARN do seu cluster. CREATE EXTERNAL SCHEMA member_schema

FROM MSK

IAM_ROLE 'iam_role_arn'

AUTHENTICATION iam

URI 'MSK_cluster_arn';

| Engenheiro de migração |

Crie uma visão materializada. | Para consumir os dados do tópico Amazon MSK no Amazon Redshift Serverless, crie uma visualização materializada. No editor de consultas v2 do Amazon Redshift, execute os seguintes comandos SQL, <MSK_Topic_name> substituindo-os pelo nome do seu tópico do Amazon MSK. CREATE MATERIALIZED VIEW member_view

AUTO REFRESH YES

AS SELECT

kafka_partition,

kafka_offset,

refresh_time,

json_parse(kafka_value) AS Data

FROM member_schema.<MSK_Topic_name>

WHERE CAN_JSON_PARSE(kafka_value);

| Engenheiro de migração |

Crie tabelas de destino no Amazon Redshift. | As tabelas do Amazon Redshift fornecem a entrada para. QuickSight Esse padrão usa as tabelas member_dtls emember_plans, que correspondem às tabelas Db2 de origem no mainframe. Para criar as duas tabelas no Amazon Redshift, execute os seguintes comandos SQL no editor de consultas v2 do Amazon Redshift: -- Table 1: members_dtls

CREATE TABLE members_dtls (

memberid INT ENCODE AZ64,

member_name VARCHAR(100) ENCODE ZSTD,

member_type VARCHAR(50) ENCODE ZSTD,

age INT ENCODE AZ64,

gender CHAR(1) ENCODE BYTEDICT,

email VARCHAR(100) ENCODE ZSTD,

region VARCHAR(50) ENCODE ZSTD

) DISTSTYLE AUTO;

-- Table 2: member_plans

CREATE TABLE member_plans (

memberid INT ENCODE AZ64,

medical_plan CHAR(1) ENCODE BYTEDICT,

dental_plan CHAR(1) ENCODE BYTEDICT,

vision_plan CHAR(1) ENCODE BYTEDICT,

preventive_immunization VARCHAR(50) ENCODE ZSTD

) DISTSTYLE AUTO;

| Engenheiro de migração |

Crie um procedimento armazenado no Amazon Redshift. | Esse padrão usa um procedimento armazenado para sincronizar dados de alteração (INSERT,UPDATE,DELETE) do mainframe de origem com a tabela de armazenamento de dados de destino do Amazon Redshift para análise em. QuickSight Para criar o procedimento armazenado no Amazon Redshift, use o editor de consultas v2 para executar o código do procedimento armazenado que está no repositório. GitHub | Engenheiro de migração |

Leia a partir da visualização materializada de streaming e carregue nas tabelas de destino. | O procedimento armazenado lê as alterações de dados da visualização materializada de streaming e carrega as alterações de dados nas tabelas de destino. Para executar o procedimento armazenado, use o seguinte comando: call SP_Members_Load();

Você pode usar EventBridge a Amazon para programar os trabalhos em seu armazém de dados do Amazon Redshift para chamar esse procedimento armazenado com base em seus requisitos de latência de dados. EventBridge executa trabalhos em intervalos fixos. Para monitorar se a chamada anterior para o procedimento foi concluída, talvez seja necessário usar um mecanismo como uma máquina de AWS Step Functionsestado. Para obter mais informações, consulte os seguintes recursos: Outra opção é usar o editor de consultas v2 do Amazon Redshift para programar a atualização. Para obter mais informações, consulte Agendamento de uma consulta com o editor de consultas v2. | Engenheiro de migração |

| Tarefa | Descrição | Habilidades necessárias |

|---|

Configurar QuickSight. | Para configurar QuickSight, siga as instruções na AWS documentação. | Engenheiro de migração |

Configure uma conexão segura entre QuickSight e o Amazon Redshift. | Para configurar uma conexão segura entre o Amazon Redshift QuickSight e o Amazon Redshift, faça o seguinte Para autorizar conexões do QuickSight Amazon Redshift, abra o console do Amazon Redshift e adicione uma regra de entrada no grupo de segurança do Amazon Redshift. A regra deve permitir o tráfego para a porta 5439 (a porta padrão do Redshift) a partir do intervalo CIDR em que você configurou. QuickSight Para obter uma lista de Regiões da AWS e seus endereços IP, consulte Compatível com Regiões da AWS QuickSight. No console do Amazon Redshift, escolha Grupo de trabalho, acesso a dados, rede e segurança e habilite o acesso público.

| Engenheiro de migração |

Crie um conjunto de dados para QuickSight. | Para criar um conjunto de dados QuickSight do Amazon Redshift, faça o seguinte: No QuickSight console, no painel de navegação, escolha Conjuntos de dados. Na página Conjuntos de dados, escolha Novo conjunto de dados. Escolha Conexão manual do Redshift. Na janela Nova fonte de dados do Redshift, insira as informações de conexão: Em Nome da fonte de dados, insira um nome para a fonte de dados do Amazon Redshift. Em Servidor de banco de dados, insira o endpoint do cluster Amazon Redshift. Você pode obter o valor do endpoint no campo Endpoint na seção Informações gerais do grupo de trabalho do cluster no painel do Amazon Redshift Serverless. O endereço do servidor é a primeira parte do endpoint antes dos dois pontos, conforme mostrado no exemplo a seguir: mfdata-insights.NNNNNNNNN.us-east-1.redshift-serverless.amazonaws.com:5439/dev

Para a porta, insira 5439 (a porta padrão para o Amazon Redshift). Insira o nome do banco de dados (após a barra no endpoint). Nesse caso, o nome do banco de dados édev. Em Nome de usuário e senha, insira o nome de usuário e a senha do banco de dados do Amazon Redshift.

Escolha Validar conexão. Se for bem-sucedido, você deverá ver uma marca de seleção verde, que indica validação. Se a validação falhar, consulte a seção Solução de problemas. Escolha Criar fonte de dados.

| Engenheiro de migração |

Junte-se ao conjunto de dados. | Para criar análises em QuickSight, junte as duas tabelas seguindo as instruções na AWS documentação. No painel Configuração de junção, escolha Esquerda para o tipo de junção. Em Cláusulas de união, usememberid from member_plans = memberid from members_details. | Engenheiro de migração |

| Tarefa | Descrição | Habilidades necessárias |

|---|

Configure o Amazon Q em QuickSight. | Para configurar o recurso Amazon Q in QuickSight Generative BI, siga as instruções na AWS documentação. | Engenheiro de migração |

Analise os dados do mainframe e crie um painel visual. | Para analisar e visualizar seus dados em QuickSight, faça o seguinte: Para criar a análise de dados do mainframe, siga as instruções na AWS documentação. Para o conjunto de dados, escolha o conjunto de dados que você criou. Na página de análise, escolha Criar visual. Na janela Criar tópico para análise, escolha Atualizar tópico existente. Na lista suspensa Selecionar um tópico, escolha o tópico que você criou anteriormente. Escolha Vinculação de tópicos. Depois de vincular o tópico, escolha Criar visual para abrir a janela Amazon Q Build a Visual. Na barra de prompts, escreva suas perguntas de análise. Os exemplos de perguntas usadas para esse padrão são os seguintes: Mostrar distribuição de membros por região Mostrar distribuição de membros por idade Mostrar distribuição de membros por gênero Mostrar distribuição de membros por tipo de plano Mostrar aos membros que não concluíram a imunização preventiva

Depois de inserir suas perguntas, escolha Criar. O Amazon Q in QuickSight cria os recursos visuais. Para adicionar os elementos visuais ao seu painel visual, escolha ADICIONAR À ANÁLISE.

Ao terminar, você poderá publicar seu painel para compartilhar com outras pessoas em sua organização. Para ver exemplos, consulte Painel visual do mainframe na seção Informações adicionais. | Engenheiro de migração |

| Tarefa | Descrição | Habilidades necessárias |

|---|

Crie uma história de dados. | Crie uma história de dados para explicar os insights da análise anterior e gere uma recomendação para aumentar a imunização preventiva dos membros: Para criar a história de dados, siga as instruções na AWS documentação. Para o prompt da história de dados, use o seguinte: Build a data story about Region with most numbers of members. Also show the member distribution by medical plan, vision plan, dental plan. Recommend how to motivate members to complete immunization. Include 4 points of supporting data for this pattern.

Você também pode criar seu próprio prompt para gerar histórias de dados para outros insights de negócios. Escolha Adicionar elementos visuais e adicione os elementos visuais que são relevantes para a história dos dados. Para esse padrão, use as imagens que você criou anteriormente. Escolha Criar. Por exemplo, saída da história de dados, consulte Saída da história de dados na seção Informações adicionais.

| Engenheiro de migração |

Veja a história de dados gerada. | Para ver a história de dados gerada, escolha essa história na página Histórias de dados. | Engenheiro de migração |

Edite uma história de dados gerada. | Para alterar a formatação, o layout ou os elementos visuais em uma história de dados, siga as instruções na AWS documentação. | Engenheiro de migração |

Compartilhe uma história de dados. | Para compartilhar uma história de dados, siga as instruções na AWS documentação. | Engenheiro de migração |

Solução de problemas

| Problema | Solução |

|---|

QuickSight Para a criação do conjunto de dados do Amazon Redshift, Validate Connection falhou. | Confirme se o grupo de segurança vinculado à instância do Amazon Redshift Serverless permite tráfego de entrada do intervalo de endereços IP associado à região em que você configurou. QuickSight Confirme se a VPC na qual o Amazon Redshift Serverless está implantado está disponível publicamente. Confirme se você está usando o nome de usuário e a senha corretos para o Amazon Redshift. Você pode redefinir o nome de usuário e a senha no console do Amazon Redshift.

|

A tentativa de iniciar o mecanismo de aplicação na EC2 instância retorna o seguinte erro: -bash: sqdeng: command not found

| Exporte o caminho de sqdata instalação executando o seguinte comando: export PATH=$PATH:/usr/sbin:/opt/precisely/di/sqdata/bin

|

A tentativa de iniciar o Apply Engine retorna um dos seguintes erros de conexão: SQDD018E Cannot connect to transfer socket(rc==0x18468). Agent:<Agent Name > Socket:/u/./sqdata/.DB2ZTOMSK.cab.data

SQDUR06E Error opening url cdc://<VPC end point name>:2626/DB2ZTOMSK/DB2ZTOMSK : errno:1128 (Unknown error 1128)

| Verifique o spool do mainframe para garantir que os trabalhos do daemon do controlador estejam em execução. |

Recursos relacionados

Mais informações

Exemplo de arquivos.ddl

members_details.ddl

CREATE TABLE MEMBER_DTLS (

memberid INTEGER NOT NULL,

member_name VARCHAR(50),

member_type VARCHAR(20),

age INTEGER,

gender CHAR(1),

email VARCHAR(100),

region VARCHAR(20)

);

planos_do_membros.ddl

CREATE TABLE MEMBER_PLANS (

memberid INTEGER NOT NULL,

medical_plan CHAR(1),

dental_plan CHAR(1),

vision_plan CHAR(1),

preventive_immunization VARCHAR(20)

);

Exemplo de arquivo.sqd

<kafka topic name>Substitua pelo nome do seu tópico do Amazon MSK.

script.sqd

-- Name: DB2ZTOMSK: DB2z To MSK JOBNAME DB2ZTOMSK;REPORT EVERY 1;OPTIONS CDCOP('I','U','D');-- Source Descriptions

JOBNAME DB2ZTOMSK;

REPORT EVERY 1;

OPTIONS CDCOP('I','U','D');

-- Source Descriptions

BEGIN GROUP DB2_SOURCE;

DESCRIPTION DB2SQL /var/precisely/di/sqdata/apply/DB2ZTOMSK/ddl/mem_details.ddl AS MEMBER_DTLS;

DESCRIPTION DB2SQL /var/precisely/di/sqdata/apply/DB2ZTOMSK/ddl/mem_plans.ddl AS MEMBER_PLANS;

END GROUP;

-- Source Datastore

DATASTORE cdc://<zos_host_name>/DB2ZTOMSK/DB2ZTOMSK

OF UTSCDC

AS CDCIN

DESCRIBED BY GROUP DB2_SOURCE ;

-- Target Datastore(s)

DATASTORE 'kafka:///<kafka topic name>/key'

OF JSON

AS TARGET

DESCRIBED BY GROUP DB2_SOURCE;

PROCESS INTO TARGET

SELECT

{

REPLICATE(TARGET)

}

FROM CDCIN;

Painel visual do mainframe

O visual de dados a seguir foi criado pela Amazon Q em QuickSight para a pergunta de análise show member distribution by region.

O visual de dados a seguir foi criado pela Amazon Q QuickSight para a perguntashow member distribution by Region who have not completed preventive immunization, in pie chart.

Saída da história de dados

As capturas de tela a seguir mostram seções da história de dados criada pela Amazon Q QuickSight para o promptBuild a data story about Region with most numbers of members. Also show the member distribution by age, member distribution by gender. Recommend how to motivate members to complete immunization. Include 4 points of supporting data for this pattern.

Na introdução, a história dos dados recomenda escolher a região com mais membros para obter o maior impacto dos esforços de imunização.

A história dos dados fornece uma análise do número de membros das quatro regiões. As regiões Nordeste, Sudoeste e Sudeste têm o maior número de membros.

A história dos dados apresenta uma análise dos membros por idade.

A história dos dados se concentra nos esforços de imunização no Centro-Oeste.

Anexos

Para acessar o conteúdo adicional associado a este documento, descompacte o seguinte arquivo: attachment.zip